Амазонська аптека є аптекою повного спектру послуг на Amazon.com який пропонує прозорі ціни, клінічну підтримку та підтримку клієнтів, а також безкоштовну доставку прямо до ваших дверей. Агенти з обслуговування клієнтів відіграють вирішальну роль у швидкому й точному отриманні інформації, пов’язаної з інформацією про аптеку, включно з уточненнями про рецепти та статусом передачі, деталями замовлень і видачі, а також інформацією профілю пацієнта, у режимі реального часу. Amazon Pharmacy надає інтерфейс чату, де клієнти (пацієнти та лікарі) можуть спілкуватися онлайн з представниками служби підтримки клієнтів (агентами). Однією з проблем, з якою стикаються агенти, є пошук точної інформації під час відповідей на запитання клієнтів, оскільки різноманітність, обсяг і складність процесів охорони здоров’я (таких як пояснення попередніх авторизацій) можуть викликати страх. Пошук правильної інформації, її узагальнення та пояснення потребує часу, сповільнюючи швидкість обслуговування пацієнтів.

Щоб впоратися з цією проблемою, Amazon Pharmacy створив генеративний чат-бот-бот для запитань і відповідей (Q&A), щоб агенти могли отримувати інформацію за допомогою пошуку природною мовою в режимі реального часу, зберігаючи взаємодію людини з клієнтами. Рішення відповідає HIPAA, що забезпечує конфіденційність клієнтів. Крім того, агенти надсилають свої відгуки, пов’язані зі згенерованими машиною відповідями, команді розробників Amazon Pharmacy, щоб їх можна було використати для майбутніх вдосконалень моделі.

У цьому дописі ми описуємо, як Amazon Pharmacy реалізувала своє рішення чат-бота помічника агента з обслуговування клієнтів за допомогою продуктів AWS AI, включаючи базові моделі в Amazon SageMaker JumpStart прискорити його розвиток. Ми починаємо з висвітлення загального досвіду роботи агента з обслуговування клієнтів із додаванням чат-бота на основі великої мовної моделі (LLM). Потім ми пояснюємо, як це рішення використовує шаблон Retrieval Augmented Generation (RAG) для його реалізації. Нарешті, ми опишемо архітектуру продукту. Ця публікація демонструє, як генеративний штучний інтелект інтегрується у вже працюючу програму в складному та суворо регульованому бізнесі, покращуючи досвід обслуговування клієнтів аптек.

Чат-бот Q&A на базі LLM

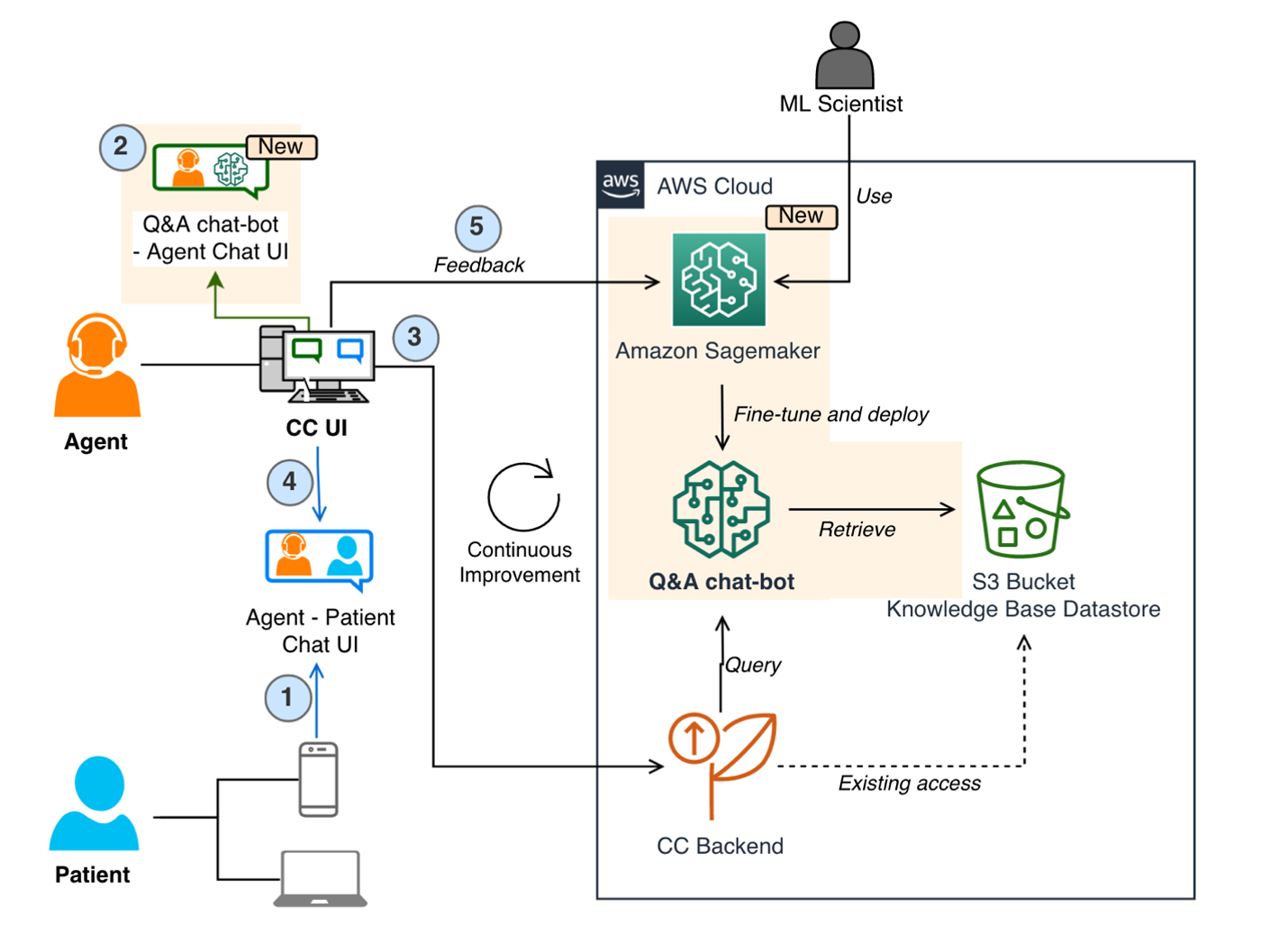

На наступному малюнку показано процес звернення пацієнта до служби підтримки клієнтів Amazon Pharmacy через чат (крок 1). Агенти використовують окремий внутрішній інтерфейс служби підтримки клієнтів, щоб задавати запитання чат-боту Q&A на основі LLM (Крок 2). Потім інтерфейс служби підтримки клієнтів надсилає запит до серверної частини служби, на якій розміщено AWS Fargate (Крок 3), де запити організовуються за допомогою комбінації моделей і процесів пошуку даних, спільно відомих як процес RAG. Цей процес є основою рішення чат-бота на базі LLM, і його деталі пояснюються в наступному розділі. Наприкінці цього процесу згенерована машиною відповідь повертається агенту, який може переглянути відповідь перед тим, як надати її кінцевому клієнту (Крок 4). Слід зазначити, що агенти навчені приймати рішення та використовувати рішення для чат-бота на базі LLM як інструмент, який покращує їхню роботу, щоб вони могли присвятити свій час особистій взаємодії з клієнтом. Агенти також позначають згенеровану машиною відповідь своїм відгуком (наприклад, позитивним чи негативним). Цей відгук потім використовується командою розробників Amazon Pharmacy для вдосконалення рішення (шляхом тонкого налаштування або покращення даних), утворюючи безперервний цикл розробки продукту з користувачем (Крок 5).

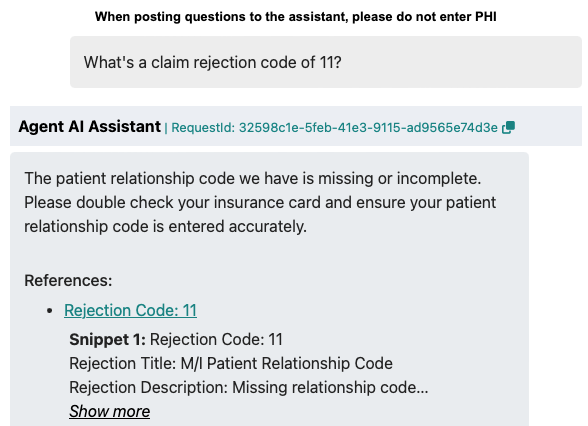

На наступному малюнку показано приклад взаємодії чат-бота із запитаннями та відповідями та агента. Тут агент запитував про код відхилення претензії. Чат-бот Q&A (Agent AI Assistant) відповідає на запитання чітким описом коду відхилення. Він також надає посилання на оригінальну документацію, за якою агенти можуть звернутися за потребою.

Прискорення розробки моделі ML

На попередньому малюнку, який зображує робочий процес чат-бота, ми пропустили деталі навчання початкової версії моделей чат-бота із запитаннями та відповідями. Для цього команда розробників Amazon Pharmacy використала SageMaker JumpStart. SageMaker JumpStart дозволив команді швидко експериментувати з різними моделями, запускаючи різні контрольні показники та тести, за потреби швидко виявляючи невдачі. Швидка невдача це концепція, яку практикують вчені та розробники, щоб швидко створювати максимально реалістичні рішення та вчитися на їхніх зусиллях, щоб покращити їх у наступній ітерації. Після того, як команда визначилася з моделлю та виконала необхідне тонке налаштування та налаштування, вони використали Хостинг SageMaker щоб розгорнути рішення. Повторне використання основних моделей у SageMaker JumpStart дозволило команді розробників скоротити місяці роботи, які в іншому випадку були б потрібні для навчання моделей з нуля.

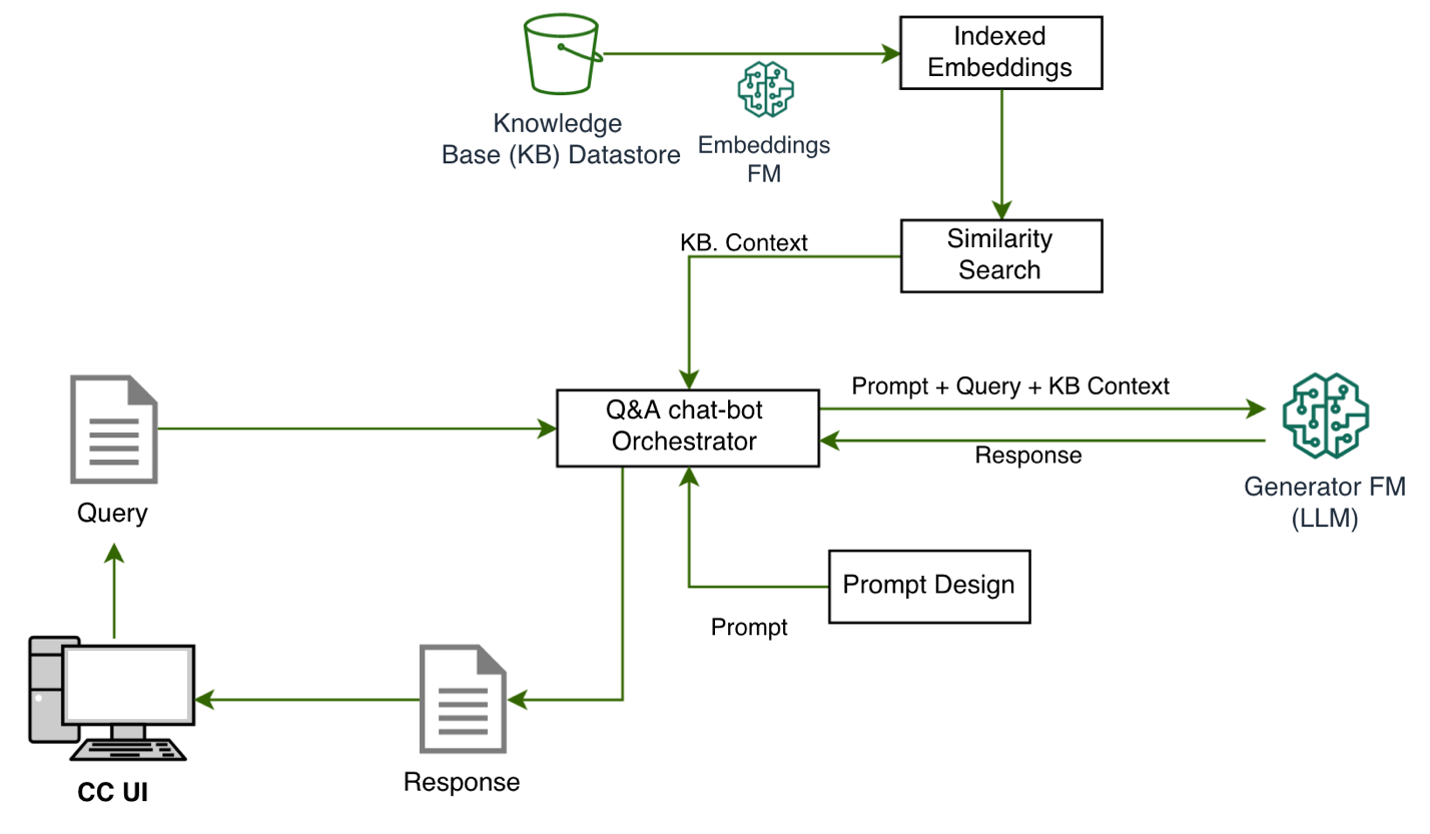

Шаблон дизайну RAG

Однією з основних частин рішення є використання Доповнена генерація пошуку (RAG) шаблон проектування для впровадження рішень із запитань і відповідей. Першим кроком у цьому шаблоні є ідентифікація набору відомих пар запитань і відповідей, які є початковою основною істиною для рішення. Наступним кроком є перетворення запитань на краще представлення з метою подібності та пошуку, що називається вбудовування (ми вбудовуємо об’єкт з більшою розмірністю в гіперплощину з меншими розмірами). Це робиться за допомогою спеціальної моделі фундаменту для вбудовування. Ці вбудовування використовуються як індекси для відповідей, подібно до того, як індекс бази даних відображає первинний ключ у рядок. Тепер ми готові підтримувати нові запити від клієнтів. Як пояснювалося раніше, досвід полягає в тому, що клієнти надсилають свої запити агентам, які потім взаємодіють із чат-ботом на основі LLM. У чат-боті Q&A запит перетворюється на вбудовування, а потім використовується як пошуковий ключ для відповідного індексу (з попереднього кроку). Критерії відповідності базуються на моделі подібності, наприклад ФАЙС or Служба відкритого пошуку Amazon (детальніше див Пояснено можливості векторної бази даних Amazon OpenSearch Service). Якщо є збіги, найкращі відповіді витягуються та використовуються як підказковий контекст для генеративної моделі. Це відповідає другому етапу в шаблоні RAG — генеративному етапу. На цьому кроці підказка надсилається до LLM (модаль основи генератора), який складає остаточну машинно-генеровану відповідь на оригінальне запитання. Ця відповідь надається агенту через інтерфейс служби підтримки клієнтів, який перевіряє відповідь, редагує її за потреби та надсилає назад пацієнту. Наступна діаграма ілюструє цей процес.

Управління базою знань

Як ми дізналися з шаблону RAG, перший крок у виконанні Q&A складається з отримання даних (пар запитання та відповіді), які будуть використовуватися як контекст для підказки LLM. Ці дані називаються даними чат-бота база знань. Прикладами цих даних є внутрішні стандартні операційні процедури (SOP) Amazon Pharmacy та інформація, доступна в Довідковий центр аптек Amazon. Щоб полегшити процес індексування та пошуку (як описано раніше), часто корисно зібрати всю цю інформацію, яка може розміщуватися в різних рішеннях, наприклад у вікі-сайтах, файлах і базах даних, в єдине сховище. У конкретному випадку чат-бота Amazon Pharmacy ми використовуємо Служба простого зберігання Amazon (Amazon S3) для цієї мети через його простоту та гнучкість.

Огляд рішення

На наступному малюнку показано архітектуру рішення. Додаток обслуговування клієнтів і чат-бот Q&A на основі LLM розгорнуті у власному VPC для ізоляції мережі. Зв'язок між в Кінцеві точки VPC реалізується через AWS PrivateLink, гарантуючи їх конфіденційність. Чат-бот Q&A також має власний обліковий запис AWS для розподілу ролей, ізоляції та простоти моніторингу з метою безпеки, вартості та дотримання вимог. Логіка оркестровки чат-бота Q&A розміщена у Fargate with Служба еластичних контейнерів Amazon (Amazon ECS). Щоб налаштувати PrivateLink, a Балансувальник мережевого навантаження доручає запити до an Балансувальник навантаження програми, який зупиняє TLS-з’єднання кінцевого клієнта та передає запити Fargate. Основною службою зберігання є Amazon S3. Як згадувалося раніше, відповідні вхідні дані імпортуються в потрібний формат в обліковий запис чат-бота Q&A та зберігаються в сегментах S3.

Що стосується інфраструктури машинного навчання (ML), Amazon SageMaker знаходиться в центрі архітектури. Як пояснювалося в попередніх розділах, використовуються дві моделі, модель вбудовування та модель LLM, і вони розміщені в двох окремих кінцевих точках SageMaker. За допомогою SageMaker захоплення даних ми можемо реєструвати всі запити на висновок і відповіді з метою усунення несправностей, використовуючи необхідні обмеження конфіденційності та безпеки. Потім відгуки, отримані від агентів, зберігаються в окремому відрі S3.

Чат-бот «Питання та відповіді» розроблено як рішення для кількох клієнтів і підтримує додаткові продукти охорони здоров’я від Amazon Health Services, наприклад Amazon Clinic. Наприклад, рішення розгорнуто з AWS CloudFormation шаблони для інфраструктури як коду (IaC), що дозволяє використовувати різні бази знань.

Висновок

У цьому дописі було представлено технічне рішення для вдосконалення генеративного штучного інтелекту для обслуговування клієнтів Amazon Pharmacy. Рішення складається з чат-бота, який відповідає на запитання, який реалізує шаблон дизайну RAG на SageMaker, і базові моделі в SageMaker JumpStart. За допомогою цього рішення агенти з обслуговування клієнтів можуть швидше допомагати пацієнтам, надаючи точні, інформативні та стислі відповіді.

Архітектура використовує модульні мікросервіси з окремими компонентами для підготовки та завантаження бази знань, логіки чат-бота (інструкцій), вбудованого індексування та пошуку, генерації контенту LLM та контролю зворотного зв’язку. Останнє особливо важливо для постійного вдосконалення моделі. Основні моделі в SageMaker JumpStart використовуються для швидкого експериментування з моделлю, що виконується за допомогою кінцевих точок SageMaker. Нарешті, сервер чат-бота, сумісний із HIPAA, розміщено на Fargate.

Таким чином, ми побачили, як Amazon Pharmacy використовує генеративний ШІ та AWS для покращення обслуговування клієнтів, віддаючи пріоритет відповідальним принципам і практикам ШІ.

Ти можеш почніть експериментувати з моделями основи в SageMaker JumpStart сьогодні, щоб знайти правильні базові моделі для вашого випадку використання та почати створювати свою генеративну програму ШІ на SageMaker.

Про автора

Бурак Гозлуклу є головним архітектором рішень спеціаліста зі штучного інтелекту та ML, що знаходиться в Бостоні, Массачусетс. Він допомагає глобальним клієнтам застосовувати технології AWS і, зокрема, рішення AI/ML для досягнення їхніх бізнес-цілей. Бурак має ступінь доктора філософії в аерокосмічній інженерії в METU, ступінь магістра в галузі системної інженерії та пост-документацію в системній динаміці в MIT в Кембриджі, Массачусетс. Бурак захоплюється йогою та медитацією.

Бурак Гозлуклу є головним архітектором рішень спеціаліста зі штучного інтелекту та ML, що знаходиться в Бостоні, Массачусетс. Він допомагає глобальним клієнтам застосовувати технології AWS і, зокрема, рішення AI/ML для досягнення їхніх бізнес-цілей. Бурак має ступінь доктора філософії в аерокосмічній інженерії в METU, ступінь магістра в галузі системної інженерії та пост-документацію в системній динаміці в MIT в Кембриджі, Массачусетс. Бурак захоплюється йогою та медитацією.

Джангвон Кім є старшим науковим співробітником Amazon Health Store & Tech. Він має досвід LLM, NLP, Speech AI і Search. До того як приєднатися до Amazon Health, Джангвон працював науковим співробітником Amazon Alexa Speech. Він живе в Лос-Анджелесі.

Джангвон Кім є старшим науковим співробітником Amazon Health Store & Tech. Він має досвід LLM, NLP, Speech AI і Search. До того як приєднатися до Amazon Health, Джангвон працював науковим співробітником Amazon Alexa Speech. Він живе в Лос-Анджелесі.

Александр Алвес є старшим головним інженером Amazon Health Services, який спеціалізується на ML, оптимізації та розподілених системах. Він допомагає покращити стан здоров’я.

Александр Алвес є старшим головним інженером Amazon Health Services, який спеціалізується на ML, оптимізації та розподілених системах. Він допомагає покращити стан здоров’я.

Нірвай Кумар є старшим інженером-розробником програмного забезпечення в Amazon Health Services, керуючим архітектурою в Pharmacy Operations після багатьох років роботи в Fulfillment Technologies. Маючи досвід у розподілених системах, він культивував зростаючу пристрасть до потенціалу ШІ. Nirvay спрямовує свої таланти в інженерні системи, які вирішують реальні потреби клієнтів за допомогою креативності, турботи, безпеки та довгострокового бачення. Коли він не подорожує горами Вашингтона, він зосереджується на продуманому дизайні, який передбачає несподіване. Nirvay прагне створювати системи, які витримують випробування часом і відповідають потребам клієнтів, що постійно розвиваються.

Нірвай Кумар є старшим інженером-розробником програмного забезпечення в Amazon Health Services, керуючим архітектурою в Pharmacy Operations після багатьох років роботи в Fulfillment Technologies. Маючи досвід у розподілених системах, він культивував зростаючу пристрасть до потенціалу ШІ. Nirvay спрямовує свої таланти в інженерні системи, які вирішують реальні потреби клієнтів за допомогою креативності, турботи, безпеки та довгострокового бачення. Коли він не подорожує горами Вашингтона, він зосереджується на продуманому дизайні, який передбачає несподіване. Nirvay прагне створювати системи, які витримують випробування часом і відповідають потребам клієнтів, що постійно розвиваються.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/learn-how-amazon-pharmacy-created-their-llm-based-chat-bot-using-amazon-sagemaker/