Програми генеративного штучного інтелекту (AI), побудовані на основі великих мовних моделей (LLM), продемонстрували потенціал для створення та прискорення економічної цінності для бізнесу. Приклади програм включають розмовний пошук, допомога агента служби підтримки клієнтів, аналітика підтримки клієнтів, віртуальні помічники самообслуговування, chatbots, створення мультимедіа, модерація вмісту, програмні компаньйони для прискорення розробки безпечного високопродуктивного програмного забезпечення, глибше розуміння з мультимодальних джерел вмісту, прискорення розслідувань безпеки вашої організації та пом’якшень, і багато іншого. Багато клієнтів шукають вказівки щодо керування безпекою, конфіденційністю та відповідністю, коли вони розробляють генеративні програми ШІ. Розуміння та усунення вразливостей, загроз і ризиків LLM на етапах проектування та архітектури допомагає командам зосередитися на максимізації економічних і продуктивних переваг, які може принести генеруючий ШІ. Усвідомлення ризиків сприяє прозорості та довірі до генеративних програм штучного інтелекту, заохочує більшу спостережливість, допомагає відповідати вимогам відповідності та сприяє прийняттю обґрунтованих рішень керівниками.

Мета цієї публікації — надати інженерам штучного інтелекту та машинного навчання (ML), дослідникам обробки даних, архітекторам рішень, командам безпеки та іншим зацікавленим сторонам мати спільну розумову модель і структуру для застосування найкращих практик безпеки, дозволяючи командам штучного інтелекту/ML рухатися швидко, без шкоди для безпеки заради швидкості. Зокрема, ця публікація спрямована на те, щоб допомогти спеціалістам зі штучного інтелекту/ML та дослідникам даних, які, можливо, раніше не знайомилися з принципами безпеки, отримати розуміння основних найкращих практик безпеки та конфіденційності в контексті розробки генеративних програм ШІ з використанням LLM. Ми також обговорюємо загальні проблеми безпеки, які можуть підірвати довіру до штучного інтелекту, як визначено Open Worldwide Application Security Project (OWASP) 10 найкращих програм LLM, а також показати способи використання AWS для підвищення рівня безпеки та впевненості, впроваджуючи інновації за допомогою генеративного ШІ.

Ця публікація містить три покрокові кроки для розробки стратегій управління ризиками під час розробки генеративних програм штучного інтелекту за допомогою LLM. Спочатку ми досліджуємо вразливості, загрози та ризики, які виникають у результаті впровадження, розгортання та використання рішень LLM, і надаємо вказівки щодо того, як розпочати інновації з урахуванням безпеки. Потім ми обговорюємо, як для генеративного штучного інтелекту важливо будувати надійний фундамент. Нарешті, ми поєднуємо їх разом із прикладом робочого навантаження LLM, щоб описати підхід до розробки архітектури з поглибленим захистом безпеки через межі довіри.

До кінця цього посту, Інженери штучного інтелекту/ML, спеціалісти з обробки даних і технологи, які займаються безпекою, зможуть визначити стратегії створення багатошарових захистів для своїх генеративних додатків штучного інтелекту, зрозуміють, як зіставити 10 найпопулярніших проблем безпеки OWASP для магістрів права на деякі відповідні елементи керування, а також набудуть фундаментальних знань для відповідаючи на наступні основні теми запитань клієнтів AWS щодо їхніх програм:

- Які поширені ризики для безпеки та конфіденційності пов’язані з використанням генеративного штучного інтелекту на основі LLM у моїх програмах, на які я можу найбільше вплинути за допомогою цих вказівок?

- Які існують способи впровадження засобів контролю безпеки та конфіденційності в життєвому циклі розробки генеративних додатків AI LLM на AWS?

- Які передові операційні та технічні методи я можу застосувати в тому, як моя організація створює генеративні програми ШІ LLM для управління ризиками та підвищення довіри до генеративних програм ШІ за допомогою LLM?

Покращуйте результати безпеки під час розробки генеративного ШІ

Інновації з генеративним штучним інтелектом з використанням LLMs вимагають починати з безпеки, щоб розвинути організаційну відмовостійкість, побудувати безпечну основу та інтегрувати безпеку з підходом до глибокого захисту. Безпека - це a спільна відповідальність між AWS і клієнтами AWS. Усі принципи моделі спільної відповідальності AWS застосовні до генеративних рішень ШІ. Оновіть своє розуміння моделі спільної відповідальності AWS, оскільки вона застосовується до інфраструктури, послуг і даних, коли ви створюєте рішення LLM.

Почніть з безпеки, щоб розвинути організаційну стійкість

Почніть із безпеки, щоб розвинути організаційну відмовостійкість для розробки генеративних програм штучного інтелекту, які відповідають вашим цілям безпеки та відповідності. Організаційна стійкість спирається на та розширює визначення стійкості в AWS Well-Architected Framework включити та підготувати здатність організації відновлюватися після збоїв. Оцінюючи загальну готовність до розробки генеративного штучного інтелекту за допомогою магістерських програм, а також стійкість вашої організації до будь-яких потенційних впливів, враховуйте рівень безпеки, керування та операційну досконалість. Оскільки ваша організація вдосконалює використання нових технологій, таких як генеративний штучний інтелект та LLM, загальну стійкість організації слід розглядати як наріжний камінь багаторівневої оборонної стратегії для захисту активів і напрямків діяльності від непередбачуваних наслідків.

Організаційна стійкість має суттєве значення для програм LLM

Хоча всі програми управління ризиками можуть виграти від стійкості, організаційна стійкість має суттєве значення для генеративного ШІ. П’ять із 10 основних ризиків, визначених OWASP для додатків LLM, залежать від визначення архітектурних і операційних засобів контролю та їх застосування на рівні організації з метою управління ризиками. До цих п’яти ризиків належать ненадійна обробка результатів, вразливість ланцюга постачання, розкриття конфіденційної інформації, надмірна свобода дій і надмірна довіра. Почніть підвищувати стійкість організації, об’єднавши свої команди, щоб вважати ШІ, машинне навчання та генеративну безпеку штучного інтелекту основною бізнес-вимогою та головним пріоритетом протягом усього життєвого циклу продукту, від зародження ідеї до дослідження, до розробки програми, розгортання та використовувати. На додаток до обізнаності, ваші команди повинні вжити заходів для врахування генеративного штучного інтелекту в практиках управління, гарантії та підтвердження відповідності.

Створіть організаційну стійкість навколо генеративного ШІ

Організації можуть почати застосовувати способи нарощування потенціалу та можливостей для AI/ML та генеративної безпеки AI у своїх організаціях. Ви повинні почати з розширення існуючих програм безпеки, гарантії, відповідності та розвитку, щоб врахувати генеративний ШІ.

Нижче наведено п’ять ключових сфер інтересів для організаційної безпеки ШІ, машинного навчання та генеративної безпеки ШІ:

- Зрозумійте ландшафт безпеки AI/ML

- Включайте різні точки зору в стратегії безпеки

- Вживайте активних дій для забезпечення науково-дослідної діяльності

- Узгодьте стимули з результатами організації

- Підготуйтеся до реалістичних сценаріїв безпеки в AI/ML і generative AI

Розробіть модель загроз протягом життєвого циклу генеративного ШІ

Організації, які створюють генеративний штучний інтелект, повинні зосереджуватися на управлінні ризиками, а не на усуненні ризиків, і включати моделювання загроз в і планування безперервності бізнесу планування, розробка та функціонування генеративних робочих навантажень ШІ. Відступіть від виробничого використання генеративного штучного інтелекту, розробивши модель загроз для кожної програми з використанням традиційних ризиків безпеки, а також генеративних ризиків, специфічних для штучного інтелекту. Деякі ризики можуть бути прийнятними для вашого бізнесу, і вправа з моделювання загроз може допомогти вашій компанії визначити, яка ваша прийнятна схильність до ризику. Наприклад, ваш бізнес може не вимагати 99.999% безвідмовної роботи генеративної програми AI, тому додатковий час відновлення, пов’язаний із відновленням за допомогою Резервне копіювання AWS з Льодовик Amazon S3 може бути прийнятним ризиком. І навпаки, дані у вашій моделі можуть бути надзвичайно чутливими та суворо регламентованими, тому відхилення від Служба управління ключами AWS (AWS KMS) керований клієнтом ключ (CMK) обертання та використання Мережевий брандмауер AWS Допомога в застосуванні безпеки транспортного рівня (TLS) для вхідного та вихідного трафіку для захисту від викрадання даних може бути неприйнятним ризиком.

Оцініть ризики (внутрішні чи залишкові) використання генеративної програми штучного інтелекту у виробничих умовах, щоб визначити правильні базові засоби керування та засоби керування на рівні програми. Сплануйте відкат і відновлення після подій безпеки виробництва та збоїв у службі, таких як швидке впровадження, отруєння навчальних даних, відмова в обслуговуванні моделі та крадіжка моделі на ранній стадії, а також визначте засоби пом’якшення, які ви використовуватимете під час визначення вимог до програми. Ознайомлення з ризиками та засобами контролю, які необхідно запровадити, допоможе визначити найкращий підхід до впровадження для створення генеративної програми штучного інтелекту та надасть зацікавленим сторонам і особам, які приймають рішення, інформацію для прийняття обґрунтованих бізнес-рішень щодо ризиків. Якщо ви не знайомі із загальним робочим процесом AI та ML, почніть із перегляду 7 способів покращити безпеку робочих навантажень машинного навчання покращити знайомство з елементами безпеки, необхідними для традиційних систем AI/ML.

Так само, як створення будь-якої програми ML, створення генеративної програми ШІ передбачає проходження ряду етапів життєвого циклу досліджень і розробки. Ви можете переглянути AWS Generative AI Security Scoping Matrix щоб допомогти побудувати ментальну модель для розуміння ключових дисциплін безпеки, які слід враховувати залежно від того, яке генеративне рішення ШІ ви виберете.

Генеративні додатки штучного інтелекту, що використовують LLM, зазвичай розробляються та працюють у наступному порядку:

- Застосування вимог – Визначте бізнес-цілі, вимоги та критерії успіху

- Вибір моделі – Виберіть базову модель, яка відповідає вимогам сценарію використання

- Адаптація та доведення моделі – Підготуйте дані, підказки інженера та налаштуйте модель

- Оцінка моделі – Оцініть базові моделі за допомогою метрик, що стосуються конкретних випадків, і виберіть найефективнішу модель

- Розгортання та інтеграція – Розгорніть вибрану базову модель у своїй оптимізованій інфраструктурі та інтегруйте її з генеративною програмою AI

- Моніторинг додатків – Відстежуйте продуктивність програми та моделі, щоб увімкнути аналіз першопричини

Переконайтеся, що команди розуміють критичну природу безпеки як частини етапів проектування та архітектури вашого життєвого циклу розробки програмного забезпечення в день 1. Це означає обговорення безпеки на кожному рівні вашого стеку та життєвого циклу, а також позиціонування безпеки та конфіденційності як факторів, що сприяють досягненню бізнес-цілей. Архітектор контролює загрози перед тим, як запустити свою програму LLM, і подумайте, чи дані та інформація, які ви використовуватимете для адаптації та точного налаштування моделі, гарантують контроль за впровадженням у середовищах досліджень, розробки та навчання. У рамках тестів забезпечення якості запроваджуйте синтетичні загрози безпеці (наприклад, спроби викривити навчальні дані або спроби витягти конфіденційні дані за допомогою зловмисної оперативної розробки), щоб регулярно перевіряти ваш захист і стан безпеки.

Крім того, зацікавлені сторони повинні встановити послідовну каденцію перегляду робочих навантажень виробничого штучного інтелекту, машинного навчання та генеративного штучного інтелекту та встановити організаційний пріоритет щодо розуміння компромісів між керуванням і помилками людини та машини до запуску. Перевірка та забезпечення дотримання цих компромісів у розгорнутих програмах LLM підвищить вірогідність успіху зменшення ризиків.

Створюйте генеративні програми штучного інтелекту на захищеній хмарній основі

Для AWS безпека є нашим головним пріоритетом. AWS створено як найбезпечнішу глобальну хмарну інфраструктуру, на якій можна створювати, переносити та керувати програмами та робочими навантаженнями. Це підтверджується нашим широким набором із понад 300 хмарних інструментів безпеки та довірою наших мільйонів клієнтів, у тому числі найбільш чутливих до безпеки організацій, таких як уряд, охорона здоров’я та фінансові служби. Створюючи генеративні програми штучного інтелекту за допомогою LLM на AWS, ви отримуєте переваги безпеки від безпечне, надійне та гнучке середовище хмарних обчислень AWS.

Використовуйте глобальну інфраструктуру AWS для забезпечення безпеки, конфіденційності та відповідності

Коли ви розробляєте додатки з інтенсивним об’ємом даних на AWS, ви можете отримати вигоду від інфраструктури глобального регіону AWS, створеної для забезпечення можливостей, які відповідають вашим основним вимогам безпеки та відповідності. Це підкріплюється нашими Обіцянка цифрового суверенітету AWS, ми прагнемо запропонувати вам найдосконаліший набір елементів керування суверенітетом і функцій, доступних у хмарі. Ми прагнемо розширювати наші можливості, щоб ви могли задовольнити свої потреби цифровий суверенітет без шкоди для продуктивності, інновацій, безпеки чи масштабу AWS Cloud. Щоб спростити впровадження передових методів безпеки та конфіденційності, розгляньте можливість використання еталонних проектів та інфраструктури як кодових ресурсів, таких як Еталонна архітектура безпеки AWS (AWS SRA) і AWS Privacy Reference Architecture (AWS PRA). Детальніше про архітектурні рішення конфіденційності, суверенітет за задумом та відповідність AWS і користуватися такими послугами, як Конфігурація AWS, Артефакт AWS та Менеджер з аудиту AWS для забезпечення ваших потреб у конфіденційності, відповідності, аудиті та спостережливості.

Зрозумійте свою безпеку за допомогою AWS Well-Architected і Cloud Adoption Frameworks

AWS пропонує рекомендації з передового досвіду, розроблені на основі багаторічного досвіду підтримки клієнтів у розробці їхніх хмарних середовищ за допомогою Добре побудований фреймворк AWS і в розвитку, щоб реалізувати цінність бізнесу від хмарних технологій за допомогою AWS Cloud Adoption Framework (AWS CAF). Зрозумійте стан безпеки ваших робочих навантажень штучного інтелекту, машинного навчання та генеративного штучного інтелекту, виконавши перевірку добре архітектурної інфраструктури. Огляди можна виконувати за допомогою таких інструментів, як Добре архітектурний інструмент AWSабо за допомогою вашої команди AWS Підтримка AWS Enterprise. Добре архітектурний інструмент AWS автоматично інтегрує статистичні дані від Довірений радник AWS щоб оцінити, які найкращі практики існують і які існують можливості для покращення функціональності та оптимізації витрат. AWS Well-Architected Tool також пропонує персоналізовані лінзи з конкретними передовими методами, як-от Об’єктив машинного навчання щоб ви могли регулярно порівнювати свою архітектуру з найкращими практиками та визначати області для вдосконалення. Перевірте свою подорож на шляху до реалізації цінностей і зрілості хмари, розуміючи, як клієнти AWS приймають стратегії для розвитку організаційних можливостей у AWS Cloud Adoption Framework для штучного інтелекту, машинного навчання та генеративного штучного інтелекту. Ви також можете отримати користь від розуміння своєї загальної готовності до хмари, взявши участь у Оцінка готовності до хмари AWS. AWS пропонує додаткові можливості для залучення — попросіть команду свого облікового запису AWS дізнатися більше про те, як розпочати роботу з Інноваційний центр Generative AI.

Прискоріть навчання безпеки та AI/ML за допомогою передових методів, навчання та сертифікації

AWS також курує рекомендації від Найкращі методи безпеки, ідентичності та відповідності та Документація безпеки AWS щоб допомогти вам визначити способи захисту вашого навчання, розробки, тестування та робочого середовища. Якщо ви тільки починаєте, зануртеся глибше в навчання безпеки та сертифікацію, спробуйте почати з Основи безпеки AWS і План навчання безпеки AWS. Ви також можете використовувати Модель зрілості безпеки AWS щоб допомогти вам знайти та визначити пріоритети найкращих видів діяльності на різних етапах зрілості на AWS, починаючи від швидких перемог, через базові, ефективні та оптимізовані етапи. Після того, як ви та ваші команди отримаєте базове уявлення про безпеку на AWS, ми настійно рекомендуємо переглянути Як підійти до моделювання загроз а потім провести вправу з моделювання загроз зі своїми командами, починаючи з Семінар з моделювання загроз для будівельників тренувальна програма. Є багато інших Ресурси навчання та сертифікації AWS Security в наявності.

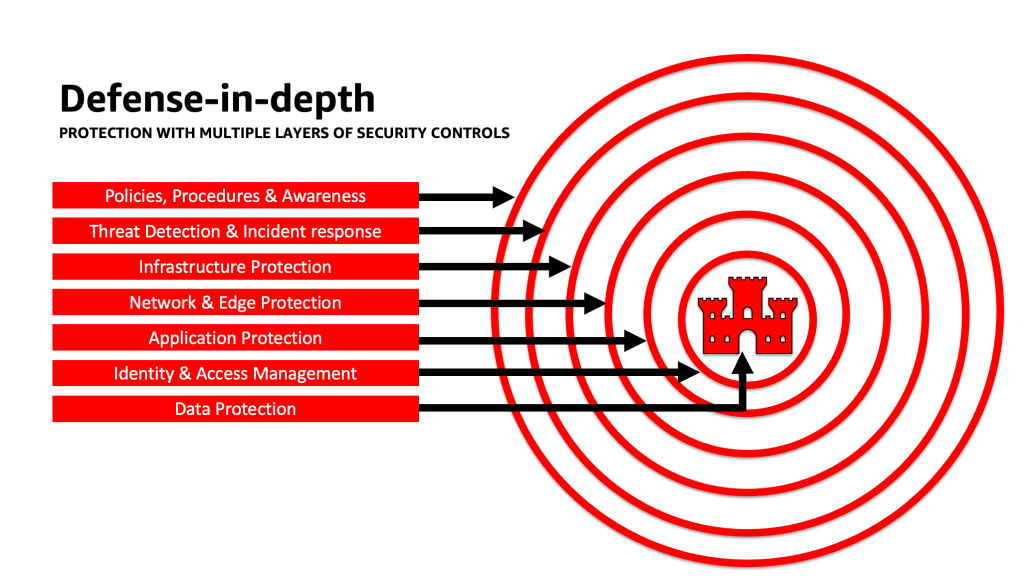

Застосуйте підхід поглибленого захисту для захисту програм LLM

Застосування підходу поглибленого захисту до ваших генеративних робочих навантажень ШІ, даних і інформації може допомогти створити найкращі умови для досягнення ваших бізнес-цілей. Найкращі практики безпеки Defence-in-in-Defense зменшують багато поширених ризиків, з якими стикається будь-яке робоче навантаження, допомагаючи вам і вашим командам прискорити генеративні інновації ШІ. Стратегія безпеки з поглибленим захистом використовує кілька резервних засобів захисту для захисту ваших облікових записів, робочих навантажень, даних і активів AWS. Це допомагає переконатися, що якщо будь-який засіб безпеки скомпрометовано або виходить з ладу, існують додаткові рівні, які допомагають ізолювати загрози та запобігати, виявляти, реагувати та відновлюватися після подій безпеки. Ви можете використовувати комбінацію стратегій, включаючи служби та рішення AWS, на кожному рівні, щоб покращити безпеку та стійкість ваших генеративних робочих навантажень ШІ.

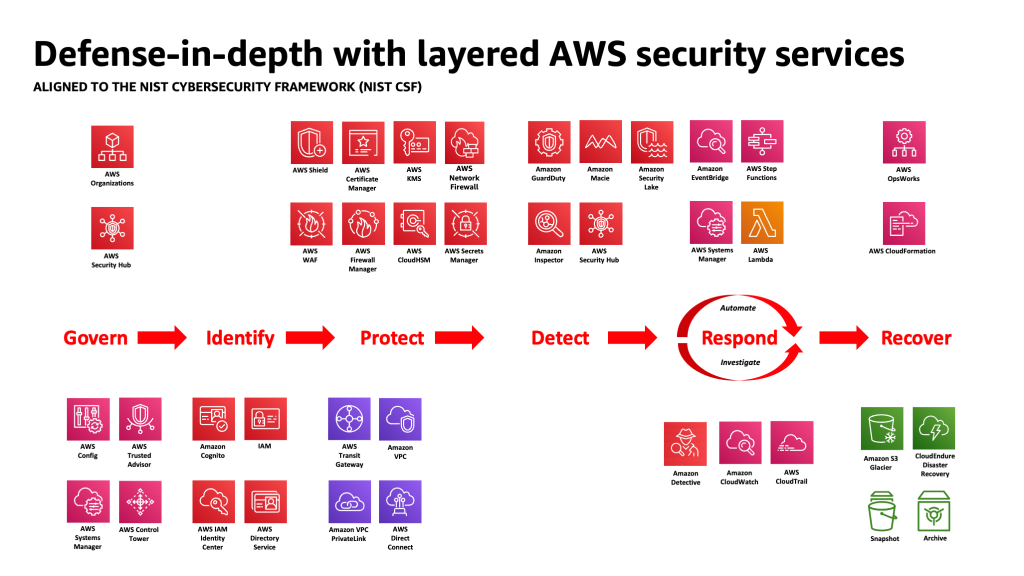

Багато клієнтів AWS узгоджуються з галузевими стандартними фреймворками, такими як Структура кібербезпеки NIST. Ця структура допомагає гарантувати, що ваші засоби захисту мають захист на основі таких компонентів, як «Ідентифікація», «Захист», «Виявлення», «Відповідь», «Відновлення» та нещодавно доданий «Керування». Потім цей фреймворк може легко зіставлятися зі службами безпеки AWS та службами інтегрованих третіх сторін, щоб допомогти вам перевірити адекватне покриття та політики для будь-якої події безпеки, з якою стикається ваша організація.

Поглиблений захист: захистіть своє середовище, а потім додайте розширені можливості безпеки та конфіденційності, що стосуються AI/ML

Стратегія поглибленого захисту повинна починатися із захисту ваших облікових записів і організації, а потім використовувати додаткові вбудовані функції безпеки та конфіденційності таких служб, як Amazon Bedrock та Amazon SageMaker. Amazon має понад 30 послуг у портфелі безпеки, ідентичності та відповідності які інтегровані зі службами AWS AI/ML і можуть використовуватися разом, щоб захистити ваші робочі навантаження, облікові записи та організацію. Для належного захисту від OWASP Top 10 для LLM їх слід використовувати разом із службами AWS AI/ML.

Почніть із впровадження політики найменших привілеїв, використовуючи такі служби, як Аналізатор доступу IAM до шукайте надто дозволені облікові записи, ролі та ресурси, щоб обмежити доступ за допомогою короткострокових облікових даних. Далі переконайтеся, що всі дані в стані спокою зашифровано за допомогою AWS KMS, включно з використанням CMK, а всі дані та моделі мають версії та резервні копії за допомогою Служба простого зберігання Amazon (Amazon S3) створення версій і застосування незмінності на рівні об’єкта Блокування об’єктів Amazon S3. Захистіть усі дані, що передаються між службами Менеджер сертифікатів AWS та / або AWS Private CAі зберігайте його в межах VPC за допомогою AWS PrivateLink. Визначте суворі правила надходження та виходу даних, щоб захистити від маніпуляцій і викрадання за допомогою VPC з Мережевий брандмауер AWS політики. Розглянемо вставку Брандмауер веб-програм AWS (AWS WAF) попереду до захистити веб-програми та API від шкідливі боти, Атаки SQL-ін'єкції, міжсайтовий скриптинг (XSS), і захоплення рахунків с Контроль шахрайства. Журнал с AWS CloudTrail, Віртуальна приватна хмара Amazon (Amazon VPC) журнали потоків і Послуга Amazon Elastic Kubernetes Журнали аудиту (Amazon EKS) допоможуть забезпечити криміналістичну перевірку кожної транзакції, доступної для таких служб, як Амазонський детектив. Ви можете використовувати Амазонський інспектор для автоматизації виявлення вразливостей і керування ними Обчислювальна хмара Amazon Elastic (Amazon EC2) примірники, контейнери, AWS Lambda функції та визначити мережеву доступність ваших робочих навантажень. Захистіть свої дані та моделі від підозрілої діяльності Вартовий обов'язок AmazonМоделі загроз і розвідувальні канали на базі ML, а також увімкнення додаткових функцій для EKS Protection, ECS Protection, S3 Protection, RDS Protection, Protection Malware, Lambda Protection тощо. Ви можете скористатися такими послугами, як Центр безпеки AWS централізувати й автоматизувати ваші перевірки безпеки, щоб виявити відхилення від найкращих методів безпеки, а також прискорити розслідування та автоматизувати виправлення результатів безпеки за допомогою посібників. Ви також можете розглянути можливість реалізації a нульова довіра архітектури на AWS для подальшого посилення тонкої автентифікації та контролю авторизації для того, до чого користувачі-людини або міжмашинні процеси можуть отримати доступ на основі кожного запиту. Також розгляньте можливість використання Озеро безпеки Амазонки для автоматичної централізації даних безпеки із середовищ AWS, постачальників SaaS, локальних і хмарних джерел у спеціально створене озеро даних, яке зберігається у вашому обліковому записі. За допомогою Security Lake ви можете отримати більш повне розуміння своїх даних безпеки в усій організації.

Після того, як ваше генеративне робоче середовище штучного інтелекту буде захищено, ви можете додати специфічні функції ШІ/ML, як-от Amazon SageMaker Data Wrangler для виявлення потенційної упередженості під час підготовки даних та Роз'яснити Amazon SageMaker для виявлення зміщення в даних і моделях ML. Ви також можете використовувати Монітор моделі Amazon SageMaker щоб оцінити якість моделей SageMaker ML у виробництві та повідомити вас, коли є дрейф у якості даних, якості моделі та атрибуції функцій. Ці служби AWS AI/ML, що працюють разом (зокрема, SageMaker, що працює з Amazon Bedrock) із службами безпеки AWS, можуть допомогти вам визначити потенційні джерела природних упереджень і захистити від зловмисного втручання в дані. Повторіть цей процес для кожної з 10 найпопулярніших уразливостей OWASP для LLM, щоб переконатися, що ви максимізуєте цінність служб AWS для впровадження глибокого захисту для захисту ваших даних і робочих навантажень.

Як написав стратег AWS Enterprise Кларк Роджерс у своєму блозі «CISO Insight: кожна служба AWS — це служба безпеки», «Я б стверджував, що практично кожна служба в хмарі AWS або сама по собі забезпечує безпеку, або може використовуватися (окремо чи в поєднанні з однією чи декількома послугами) клієнтами для досягнення мети безпеки, ризиків або відповідності». І «Офіцери з інформаційної безпеки клієнтів (CISO) (або їхні відповідні команди) можуть витратити час, щоб переконатися, що вони добре обізнані з усіма послугами AWS, оскільки можуть існувати цілі безпеки, ризику або відповідності, яких можна досягти, навіть якщо послуга не належить до категорії «Безпека, ідентифікація та відповідність».

Рівень захисту на кордонах довіри в програмах LLM

Розробляючи генеративні системи та додатки на основі штучного інтелекту, ви повинні враховувати ті ж проблеми, що й у випадку з будь-якою іншою програмою ML, як зазначено в MITRE ATLAS Матриця загроз машинного навчання, як-от уважність до походження програмного забезпечення та компонентів даних (наприклад, проведення аудиту програмного забезпечення з відкритим вихідним кодом, перевірка номенклатури програмного забезпечення (SBOM) та аналіз робочих процесів даних та інтеграції API) і впровадження необхідних засобів захисту від загроз ланцюжка поставок LLM. Включіть уявлення з галузевих інфраструктур і знайте способи використання кількох джерел аналізу загроз та інформації про ризики, щоб налаштувати та розширити ваші засоби захисту для врахування ШІ, ML та генеративних ризиків безпеки ШІ, які виникають і не включені в традиційні фреймворки. Шукайте супутню інформацію про специфічні ризики штучного інтелекту в промислових, оборонних, урядових, міжнародних і академічних джерелах, оскільки нові загрози з’являються та розвиваються в цьому просторі регулярно, а супутні рамки та посібники часто оновлюються. Наприклад, якщо використовується модель Retrieval Augmented Generation (RAG), якщо модель не містить потрібних даних, вона може запросити їх із зовнішнього джерела даних для використання під час висновків і тонкого налаштування. Джерело, яке він запитує, може бути поза вашим контролем і може бути потенційним джерелом компрометації у вашому ланцюжку постачання. Підхід поглибленого захисту слід поширити на зовнішні джерела для встановлення довіри, автентифікації, авторизації, доступу, безпеки, конфіденційності та точності даних, до яких він отримує доступ. Щоб зануритися глибше, прочитайте "Створіть безпечну корпоративну програму за допомогою Generative AI і RAG за допомогою Amazon SageMaker JumpStart"

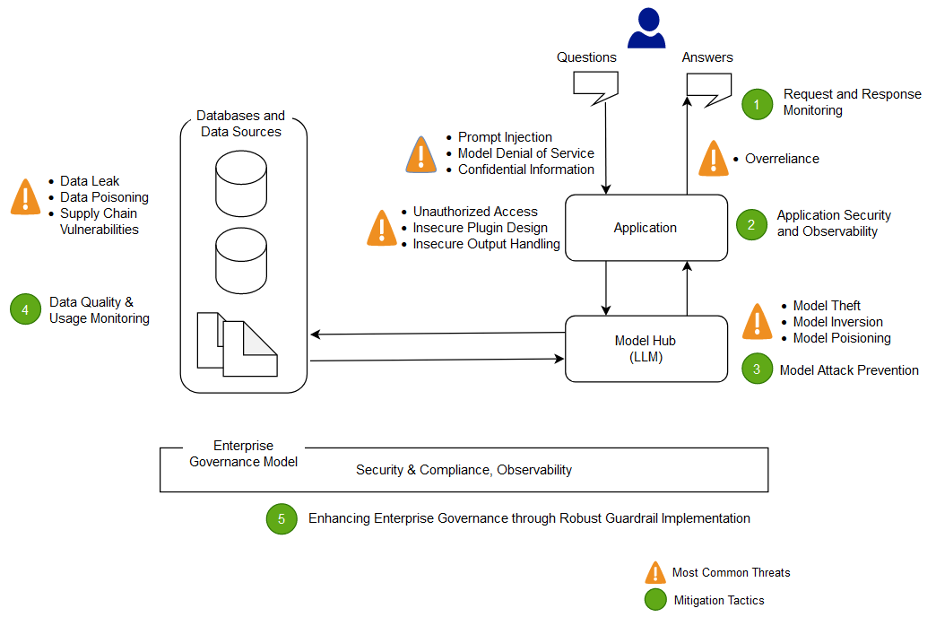

Аналізуйте та зменшуйте ризики у своїх програмах LLM

У цьому розділі ми аналізуємо та обговорюємо деякі методи зменшення ризиків, засновані на межах довіри та взаємодії, або окремих областях робочого навантаження з аналогічним відповідним обсягом контролю та профілем ризику. У цьому прикладі архітектури програми чат-бота існує п’ять меж довіри, де демонструються елементи керування, засновані на тому, як клієнти AWS зазвичай створюють свої програми LLM. Ваша програма LLM може мати більше або менше визначених меж довіри. У наведеному нижче прикладі архітектури ці межі довіри визначені як:

- Взаємодія з інтерфейсом користувача (запит і відповідь)

- Взаємодія додатків

- Модель взаємодії

- Взаємодія даних

- Організаційні взаємодії та використання

Взаємодія з інтерфейсом користувача: розробка моніторингу запитів і відповідей

Своєчасно виявляйте кіберінциденти, пов’язані з генеративним штучним інтелектом, і реагуйте на них, оцінюючи стратегію усунення ризиків, пов’язаних із вхідними та вихідними даними програми генеративного штучного інтелекту. Наприклад, додатковий моніторинг поведінки та витоку даних може знадобитися інструментально для виявлення розкриття конфіденційної інформації за межами вашого домену чи організації, якщо це використовується в програмі LLM.

Програми Generative AI все одно повинні підтримувати стандартні найкращі методи безпеки, коли мова йде про захист даних. Встановіть a захищений периметр даних та безпечні сховища конфіденційних даних. Шифруйте дані та інформацію, які використовуються для додатків LLM у стані спокою та під час передачі. Захистіть дані, які використовуються для навчання вашої моделі, від отруєння навчальними даними, розуміючи та контролюючи, яким користувачам, процесам і ролям дозволено робити внесок у сховища даних, а також те, як дані надходять у програму, відстежуйте відхилення у зміщеннях, а також використовуючи версії та незмінне сховище в службах зберігання, таких як Amazon S3. Встановіть суворий контроль надходження та виходу даних за допомогою таких служб, як мережевий брандмауер AWS і AWS VPC, щоб захистити від підозрілого введення та можливого викрадання даних.

Під час процесу навчання, перенавчання або вдосконалення ви повинні знати про будь-які конфіденційні дані, які використовуються. Після того, як дані використовуються під час одного з цих процесів, ви повинні спланувати сценарій, за якого будь-який користувач вашої моделі раптово зможе отримати дані або інформацію назад, використовуючи методи оперативного впровадження. Зрозумійте ризики та переваги використання конфіденційних даних у ваших моделях і висновках. Впроваджуйте надійні механізми автентифікації та авторизації для встановлення детальних дозволів доступу та керування ними, які не покладаються на логіку програми LLM для запобігання розкриттю. Контрольований користувачем вхід у генеративну програму штучного інтелекту продемонстровано за певних умов, щоб забезпечити вектор для вилучення інформації з моделі або будь-яких частин введення, які не контролюються користувачем. Це може статися через оперативне введення, коли користувач надає вхідні дані, які спричиняють відхилення результату моделі від очікуваних огорож програми LLM, включаючи надання підказок до наборів даних, на яких спочатку навчалася модель.

Впровадити квоти доступу на рівні користувача для користувачів, які вводять дані та отримують вихідні дані від моделі. Вам слід розглянути підходи, які не дозволяють анонімний доступ за умов, коли навчальні дані та інформація моделі є конфіденційними, або коли існує ризик навчання зловмисника факсиміле вашої моделі на основі їхнього введення та вирівняного результату моделі. Загалом, якщо частина вхідних даних до моделі складається з довільного наданого користувачем тексту, вважайте, що вихідні дані сприйнятливі до швидкого впровадження, і, відповідно, переконайтеся, що використання вихідних даних включає впроваджені технічні та організаційні контрзаходи для пом’якшення небезпечної обробки вихідних даних, надмірної агенції , і надмірна залежність. У попередньому прикладі, пов’язаному з фільтрацією зловмисного введення за допомогою AWS WAF, подумайте про створення фільтра перед вашою програмою для такого потенційного зловживання підказками та розробіть політику щодо того, як обробляти та розвивати їх у міру зростання вашої моделі та даних. Також розгляньте відфільтровану перевірку виходу, перш ніж його повернути користувачеві, щоб переконатися, що він відповідає стандартам якості, точності або модерації вмісту. Ви можете додатково налаштувати це для потреб вашої організації за допомогою додаткового рівня контролю входів і виходів перед вашими моделями, щоб пом’якшити підозрілі моделі трафіку.

Взаємодія додатків: безпека додатків і можливість спостереження

Перегляньте свою програму LLM, звернувши увагу на те, як користувач може використати вашу модель, щоб обійти стандартну авторизацію інструмента або ланцюга інструментів, до яких він не має права доступу або використання. Інше занепокоєння на цьому рівні передбачає доступ до зовнішніх сховищ даних за допомогою моделі як механізму атаки з використанням непослаблених технічних або організаційних ризиків LLM. Наприклад, якщо ваша модель навчена отримувати доступ до певних сховищ даних, які можуть містити конфіденційні дані, вам слід переконатися, що між вашою моделлю та сховищами даних є належні перевірки авторизації. Під час перевірки авторизації використовуйте незмінні атрибути про користувачів, які не походять із моделі. Незахищена обробка вихідних даних, незахищений дизайн плагіна та надмірна активність можуть створити умови, коли суб’єкт загрози може використати модель, щоб обманом змусити систему авторизації підвищити ефективні привілеї, що призведе до того, що нижній компонент повірить, що користувач уповноважений отримувати дані або виконувати певні дії. дію.

При впровадженні будь-якого генеративного плагіна або інструменту штучного інтелекту необхідно вивчити та зрозуміти рівень наданого доступу, а також уважно вивчити налаштовані елементи керування доступом. Використання незахищених генеративних плагінів штучного інтелекту може зробити вашу систему сприйнятливою до вразливостей і загроз у ланцюзі поставок, що потенційно може призвести до зловмисних дій, зокрема до віддаленого запуску коду.

Взаємодія моделі: запобігання атак моделі

Ви повинні знати про походження будь-яких моделей, плагінів, інструментів або даних, які ви використовуєте, щоб оцінити та пом’якшити вразливі місця в ланцюзі поставок. Наприклад, деякі поширені формати моделей дозволяють вбудовувати довільний виконуваний код у самі моделі. Використовуйте дзеркала пакетів, сканування та додаткові перевірки відповідно до цілей безпеки вашої організації.

Необхідно також переглянути набори даних, на яких ви тренуєте та налаштовуєте свої моделі. Якщо ви далі автоматично налаштовуєте модель на основі відгуків користувачів (або іншої інформації, яку може контролювати кінцевий користувач), ви повинні розглянути, чи може зловмисник змінити модель довільно на основі маніпулювання своїми відповідями та досягти отруєння даних навчання.

Взаємодія з даними: відстежуйте якість і використання даних

Генеративні моделі штучного інтелекту, такі як LLMs, як правило, добре працюють, оскільки їх навчали на великій кількості даних. Незважаючи на те, що ці дані допомагають LLM виконувати складні завдання, вони також можуть наражати вашу систему на ризик отруєння навчальними даними, що виникає, коли в навчальний набір даних включено або опущено невідповідні дані, що може змінити поведінку моделі. Щоб зменшити цей ризик, ви повинні переглянути свій ланцюг поставок і зрозуміти процес перевірки даних для вашої системи, перш ніж її використовувати у вашій моделі. Незважаючи на те, що навчальний конвеєр є головним джерелом отруєння даних, ви також повинні подивитися, як ваша модель отримує дані, наприклад, у моделі RAG або озері даних, і чи надійне та захищене джерело цих даних. Використовуйте служби безпеки AWS, такі як AWS Security Hub, Amazon GuardDuty та Amazon Inspector, щоб постійно стежити за підозрілою активністю в Amazon EC2, Amazon EKS, Amazon S3, Служба реляційних баз даних Amazon (Amazon RDS) і доступ до мережі, який може бути індикатором нових загроз, і використовувати Detective для візуалізації розслідувань безпеки. Також подумайте про використання таких послуг, як Озеро безпеки Амазонки щоб прискорити дослідження безпеки шляхом створення спеціально створеного озера даних для автоматичної централізації даних безпеки з середовищ AWS, постачальників SaaS, локальних і хмарних джерел, які сприяють вашому робочому навантаженню AI/ML.

Організаційна взаємодія: запровадження засобів управління підприємством для генеративного ШІ

Визначте ризики, пов’язані з використанням генеративного ШІ для вашого бізнесу. Вам слід створити таксономію ризиків вашої організації та провести оцінку ризиків, щоб приймати обґрунтовані рішення під час розгортання генеративних рішень ШІ. Розробити a план безперервності бізнесу (BCP) який включає в себе AI, ML і генеративні робочі навантаження AI і які можна швидко ввести в дію, щоб замінити втрачену функціональність ураженої або автономної програми LLM відповідно до ваших SLA.

Визначте прогалини в процесах і ресурсах, неефективність і неузгодженість, а також підвищте обізнаність і відповідальність у всьому вашому бізнесі. Модель загрози усі генеративні робочі навантаження штучного інтелекту для виявлення та пом’якшення потенційних загроз безпеці, які можуть призвести до наслідків для бізнесу, включаючи несанкціонований доступ до даних, відмову в обслуговуванні та зловживання ресурсами. Скористайтеся перевагами нового Інструмент моделювання AWS Threat Composer щоб допомогти скоротити час до отримання вартості під час виконання моделювання загроз. Пізніше у своїх циклах розробки подумайте про введення інженерія хаосу безпеки експерименти з впровадженням помилок, щоб створити реальні умови, щоб зрозуміти, як ваша система реагує на невідомі, і зміцнити впевненість у відмовостійкості та безпеці системи.

Включайте різноманітні точки зору в розробку стратегій безпеки та механізмів управління ризиками, щоб забезпечити дотримання та охоплення AI/ML та генеративної безпеки для всіх посадових ролей і функцій. Впровадьте мислення щодо безпеки з самого початку та дослідження будь-якої генеративної програми ШІ, щоб узгодити її з вимогами. Якщо вам потрібна додаткова допомога від AWS, попросіть свого менеджера облікового запису AWS переконатися, що існує однакова підтримка, звернувшись за допомогою до архітекторів рішень AWS з AWS Security та AI/ML.

Переконайтеся, що ваша організація безпеки регулярно вживає заходів для сприяння комунікації щодо усвідомлення ризиків і розуміння управління ризиками серед генеративних зацікавлених сторін штучного інтелекту, таких як менеджери продуктів, розробники програмного забезпечення, спеціалісти з обробки даних та виконавче керівництво, дозволяючи розвідці про загрози та керівним засобам охопити команди, які можуть піддаватися впливу. Організації з безпеки можуть підтримувати культуру відповідального розкриття інформації та періодичного вдосконалення, беручи участь в обговореннях і доносячи нові ідеї та інформацію зацікавленим сторонам, що займаються ШІ, які стосуються їхніх бізнес-цілей. Дізнайтеся більше про наша відданість відповідальному ШІ і додаткові відповідальні ресурси ШІ щоб допомогти нашим клієнтам.

Отримайте перевагу в забезпеченні кращої організаційної позиції для генеративного штучного інтелекту, розблокувавши ефективність часу в існуючих процесах безпеки вашої організації. Проактивно оцінюйте, де ваша організація може вимагати процесів, які є надто обтяжливими з огляду на генеративний контекст безпеки штучного інтелекту, і вдосконалюйте їх, щоб надати розробникам і вченим чіткий шлях до запуску з правильними елементами керування.

Оцініть, де можуть бути можливості вирівняти стимули, позбутися ризику та забезпечити чітке бачення бажаних результатів. Оновіть керівні вказівки та засоби захисту, щоб відповідати зростаючим потребам штучного інтелекту/ML і генеративної розробки додатків штучного інтелекту, щоб зменшити плутанину та невизначеність, які можуть коштувати часу на розробку, збільшувати ризик і посилювати вплив.

Переконайтеся, що зацікавлені сторони, які не є експертами з безпеки, можуть розуміти, як організаційне управління, політики та кроки з управління ризиками застосовуються до їхніх робочих навантажень, а також застосовувати механізми управління ризиками. Підготуйте свою організацію до реагування на реалістичні події та сценарії, які можуть виникнути з генеративними програмами штучного інтелекту, і переконайтеся, що ролі розробника генеративного штучного інтелекту та групи реагування знають про шляхи ескалації та дії у разі виникнення занепокоєння щодо будь-якої підозрілої діяльності.

Висновок

Щоб успішно комерціалізувати інновації з будь-якими новими технологіями, що розвиваються, потрібно починати з мислення, яке насамперед передбачає безпеку, спираючись на безпечну інфраструктурну основу, і думати про те, як ще на ранній стадії інтегрувати безпеку на кожному рівні технологічного стеку з поглибленим захистом. підхід. Це включає взаємодію на кількох рівнях вашого технологічного стеку та точки інтеграції у вашому цифровому ланцюжку поставок для забезпечення стійкості організації. Незважаючи на те, що генеративний штучний інтелект створює деякі нові проблеми безпеки та конфіденційності, якщо ви дотримуєтеся передових практик безпеки, як-от використання поглибленого захисту з багаторівневими службами безпеки, ви можете допомогти захистити свою організацію від багатьох поширених проблем і нових загроз. Вам слід запровадити багаторівневі послуги безпеки AWS у своїх генеративних робочих навантаженнях штучного інтелекту та більшій організації, а також зосередитися на точках інтеграції у ваших цифрових ланцюжках поставок, щоб захистити свої хмарні середовища. Потім ви можете використовувати розширені можливості безпеки та конфіденційності в службах AWS AI/ML, таких як Amazon SageMaker і Amazon Bedrock, щоб додати додаткові рівні розширеного контролю безпеки та конфіденційності до ваших генеративних програм AI. Впровадження безпеки з самого початку зробить інновації швидшими, легшими та рентабельнішими за допомогою генеративного штучного інтелекту, а також спростить відповідність. Це допоможе вам підвищити контроль, впевненість і спостережливість ваших генеративних програм ШІ для ваших співробітників, клієнтів, партнерів, регуляторів та інших зацікавлених сторін.

Додаткові посилання

- Інфраструктури галузевого стандарту для управління ризиками та безпеки, що стосуються AI/ML:

Про авторів

Крістофер Рей є головним світовим спеціалістом із безпеки GTM, який зосереджується на розробці та виконанні стратегічних ініціатив, які прискорюють і масштабують впровадження служб безпеки AWS. Він захоплюється перетином кібербезпеки та нових технологій, має понад 20 років досвіду роботи на глобальних стратегічних керівних посадах, надаючи рішення безпеки для медіа, розваг і телекомунікаційних клієнтів. Він заряджається за допомогою читання, подорожей, їжі та вина, відкриття нової музики та консультування стартапів на ранніх стадіях.

Крістофер Рей є головним світовим спеціалістом із безпеки GTM, який зосереджується на розробці та виконанні стратегічних ініціатив, які прискорюють і масштабують впровадження служб безпеки AWS. Він захоплюється перетином кібербезпеки та нових технологій, має понад 20 років досвіду роботи на глобальних стратегічних керівних посадах, надаючи рішення безпеки для медіа, розваг і телекомунікаційних клієнтів. Він заряджається за допомогою читання, подорожей, їжі та вина, відкриття нової музики та консультування стартапів на ранніх стадіях.

Ілля Зимовий є старшим інженером із безпеки в Amazon Security, має ступінь бакалавра з інженерії кібербезпеки та закоханий у Гаррі Поттера. Елайджа чудово справляється з виявленням і усуненням вразливостей у системах штучного інтелекту, поєднуючи технічну експертизу з відтінком чарівництва. Елайджа розробляє індивідуальні протоколи безпеки для екосистем штучного інтелекту, вносячи чарівний відтінок у цифровий захист. Керуючись принципом чесності, Елайджа має досвід роботи в державних і комерційних організаціях, які зосереджені на захисті довіри.

Ілля Зимовий є старшим інженером із безпеки в Amazon Security, має ступінь бакалавра з інженерії кібербезпеки та закоханий у Гаррі Поттера. Елайджа чудово справляється з виявленням і усуненням вразливостей у системах штучного інтелекту, поєднуючи технічну експертизу з відтінком чарівництва. Елайджа розробляє індивідуальні протоколи безпеки для екосистем штучного інтелекту, вносячи чарівний відтінок у цифровий захист. Керуючись принципом чесності, Елайджа має досвід роботи в державних і комерційних організаціях, які зосереджені на захисті довіри.

Рам Віттал є головним архітектором рішень ML в AWS. Він має понад 3 десятиліття досвіду розробки та створення розподілених, гібридних і хмарних програм. Він захоплений створенням безпечних і масштабованих рішень штучного інтелекту/ML і великих даних, які допомагають корпоративним клієнтам перейти до впровадження хмарних технологій та оптимізації для покращення бізнес-результатів. У вільний час він катається на мотоциклі та гуляє зі своїм 3-річним Шипадудлом!

Рам Віттал є головним архітектором рішень ML в AWS. Він має понад 3 десятиліття досвіду розробки та створення розподілених, гібридних і хмарних програм. Він захоплений створенням безпечних і масштабованих рішень штучного інтелекту/ML і великих даних, які допомагають корпоративним клієнтам перейти до впровадження хмарних технологій та оптимізації для покращення бізнес-результатів. У вільний час він катається на мотоциклі та гуляє зі своїм 3-річним Шипадудлом!

Навнеет Тутея є спеціалістом з даних у Amazon Web Services. До того як приєднатися до AWS, Navneet працював фасилітатором для організацій, які прагнуть модернізувати свої архітектури даних і впровадити комплексні рішення AI/ML. Вона має ступінь інженера в Університеті Тапар, а також ступінь магістра статистики в Техаському університеті A&M.

Навнеет Тутея є спеціалістом з даних у Amazon Web Services. До того як приєднатися до AWS, Navneet працював фасилітатором для організацій, які прагнуть модернізувати свої архітектури даних і впровадити комплексні рішення AI/ML. Вона має ступінь інженера в Університеті Тапар, а також ступінь магістра статистики в Техаському університеті A&M.

Емілі Совард є спеціалістом із Data Scientist з AWS Professional Services. Вона має ступінь магістра наук з відзнакою в галузі штучного інтелекту в Единбурзькому університеті в Шотландії, Великобританія з акцентом на обробку природної мови (NLP). Емілі працювала на прикладних наукових та інженерних посадах, зосереджених на дослідженнях і розробках продуктів з підтримкою AI, оперативному досконалості та управлінні робочими навантаженнями AI в організаціях у державному та приватному секторах. Вона вносить свій внесок у консультування клієнтів як старший спікер AWS, а нещодавно — як автор AWS Well-Architected in the Machine Learning Lens.

Емілі Совард є спеціалістом із Data Scientist з AWS Professional Services. Вона має ступінь магістра наук з відзнакою в галузі штучного інтелекту в Единбурзькому університеті в Шотландії, Великобританія з акцентом на обробку природної мови (NLP). Емілі працювала на прикладних наукових та інженерних посадах, зосереджених на дослідженнях і розробках продуктів з підтримкою AI, оперативному досконалості та управлінні робочими навантаженнями AI в організаціях у державному та приватному секторах. Вона вносить свій внесок у консультування клієнтів як старший спікер AWS, а нещодавно — як автор AWS Well-Architected in the Machine Learning Lens.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/