โพสต์นี้เขียนโดยความร่วมมือกับ Balaji Chandrasekaran, Jennifer Cwagenberg และ Andrew Sansom และ Eiman Ebrahimi จาก Protopia AI

โมเดลภาษาขนาดใหญ่ (LLM) ใหม่ที่ทรงพลังกำลังเปลี่ยนแปลงธุรกิจอย่างรวดเร็ว โดยปรับปรุงประสิทธิภาพและประสิทธิผลสำหรับกรณีการใช้งานระดับองค์กรที่หลากหลาย ความเร็วเป็นสิ่งสำคัญ และการใช้เทคโนโลยี LLM สามารถสร้างหรือทำลายความได้เปรียบทางการแข่งขันของธุรกิจได้ AWS เหมาะสมอย่างยิ่งที่จะมอบเครื่องมือที่จำเป็นสำหรับองค์กรในการปรับใช้ LLM ในวงกว้างเพื่อให้สามารถตัดสินใจที่สำคัญได้

ในการใช้เทคโนโลยี generative AI องค์กรต่างๆ มีความกังวลอย่างแท้จริงเกี่ยวกับการเปิดเผยข้อมูลและความเป็นเจ้าของข้อมูลที่เป็นความลับที่อาจถูกส่งไปยัง LLM ข้อกังวลด้านความเป็นส่วนตัวและการปกป้องข้อมูลเหล่านี้อาจทำให้การใช้งาน LLM ในองค์กรช้าลงหรือจำกัดได้ องค์กรต่างๆ ต้องการวิธีที่มีความรับผิดชอบและปลอดภัยกว่าในการส่งข้อมูลที่ละเอียดอ่อนไปยังโมเดลต่างๆ โดยไม่จำเป็นต้องจัดการกับ DevOps ภายในองค์กรที่มักจะมีค่าใช้จ่ายสูงจนเกินไป

โพสต์นี้จะอธิบายถึงวิธีที่คุณสามารถเอาชนะความท้าทายในการรักษาความเป็นเจ้าของข้อมูลและรักษาความเป็นส่วนตัวของข้อมูลในขณะที่ใช้ LLM โดยการปรับใช้ Stained Glass Transform ของ Protopia AI เพื่อปกป้องข้อมูลของคุณ โปรโทเปีย เอไอ ได้ร่วมมือกับ AWS เพื่อมอบองค์ประกอบที่สำคัญของการปกป้องข้อมูลและการเป็นเจ้าของเพื่อการนำ AI ทั่วไปมาใช้ในระดับองค์กรอย่างปลอดภัยและมีประสิทธิภาพ โพสต์นี้จะสรุปโซลูชันและสาธิตวิธีการใช้งานใน AWS สำหรับกรณีการใช้งานระดับองค์กรยอดนิยม เช่น การดึงข้อมูล Augmented Generation (RAG) และ LLM ที่ล้ำสมัยเช่น ลามะ 2.

ภาพรวมการแปลงกระจกสี

องค์กรต่างๆ พยายามรักษาความเป็นเจ้าของและการควบคุมข้อมูลองค์กรที่ละเอียดอ่อนของตนโดยสมบูรณ์ นี่คือเสาหลักของ AI ที่มีความรับผิดชอบและข้อกำหนดด้านการปกป้องข้อมูลและความเป็นส่วนตัวที่เกิดขึ้นใหม่ นอกเหนือจากการรักษาความปลอดภัยขั้นพื้นฐานและการรับประกันทางกฎหมายของผู้ให้บริการ LLM

แม้ว่าหน่วยธุรกิจขององค์กรต้องการใช้ LLM สำหรับงานต่างๆ แต่พวกเขายังกังวลเกี่ยวกับความลับทางการค้า ทรัพย์สินทางปัญญา และข้อมูลกรรมสิทธิ์อื่นๆ ที่รั่วไหลผ่านข้อมูลที่ส่งไปยังโมเดลเหล่านี้ ในเวลาเดียวกัน การรักษาความปลอดภัยขององค์กร การปฏิบัติตามกฎระเบียบ การจัดการข้อมูล และสำนักงานข้อมูลต่างหวาดกลัวต่อการเปิดเผยหรือรั่วไหลข้อมูลลูกค้าที่เป็นข้อความธรรมดาหรือข้อมูลที่ได้รับการควบคุมอื่น ๆ ภายนอกองค์กร AWS และ Protopia AI ร่วมมือกันเพื่อส่งมอบองค์ประกอบสำคัญที่ช่วยแก้ไขความต้องการทั่วไปของลูกค้าองค์กรนี้

การแปลงกระจกสี (SGT) ของ Protopia AI แก้ปัญหาความท้าทายเหล่านี้โดยการแปลงข้อมูลองค์กรที่ไม่มีการป้องกันไปเป็นการนำเสนอซ้ำแบบสุ่ม ซึ่งเรียกว่าข้อมูล RmoRed ดังแสดงในรูปต่อไปนี้ การแสดงนี้เป็นการสุ่มฝังข้อมูลต้นฉบับ โดยรักษาข้อมูลที่ LLM เป้าหมายจำเป็นต้องใช้ในการทำงานโดยไม่ต้องเปิดเผยพร้อมท์หรือการสืบค้นที่ละเอียดอ่อน บริบท หรือข้อมูลที่ปรับแต่งอย่างละเอียด การแสดงซ้ำนี้เป็นการเปลี่ยนแปลงทางเดียวที่ไม่สามารถย้อนกลับได้ ทำให้มั่นใจได้ถึงความเป็นส่วนตัวของข้อมูลองค์กรแบบองค์รวม และการป้องกันการรั่วไหลของข้อมูลที่ละเอียดอ่อนของข้อความธรรมดาไปยัง LLM การบังคับใช้ของ SGT ไม่ได้จำกัดอยู่เพียงโมเดลภาษาเท่านั้น นอกจากนี้ยังสามารถสร้างการนำเสนอซ้ำแบบสุ่มสำหรับข้อมูลภาพและข้อมูลที่มีโครงสร้างได้อีกด้วย ชื่อ Stained Glass Transform มีรากฐานมาจากลักษณะการมองเห็นของการนำเสนอข้อมูลภาพแบบสุ่ม ซึ่งสามารถคล้ายกับการดูข้อมูลผ่านกระจกสี ดังที่แสดงในบทความนี้ กรณีการใช้งานของกองทัพเรือสหรัฐฯ.

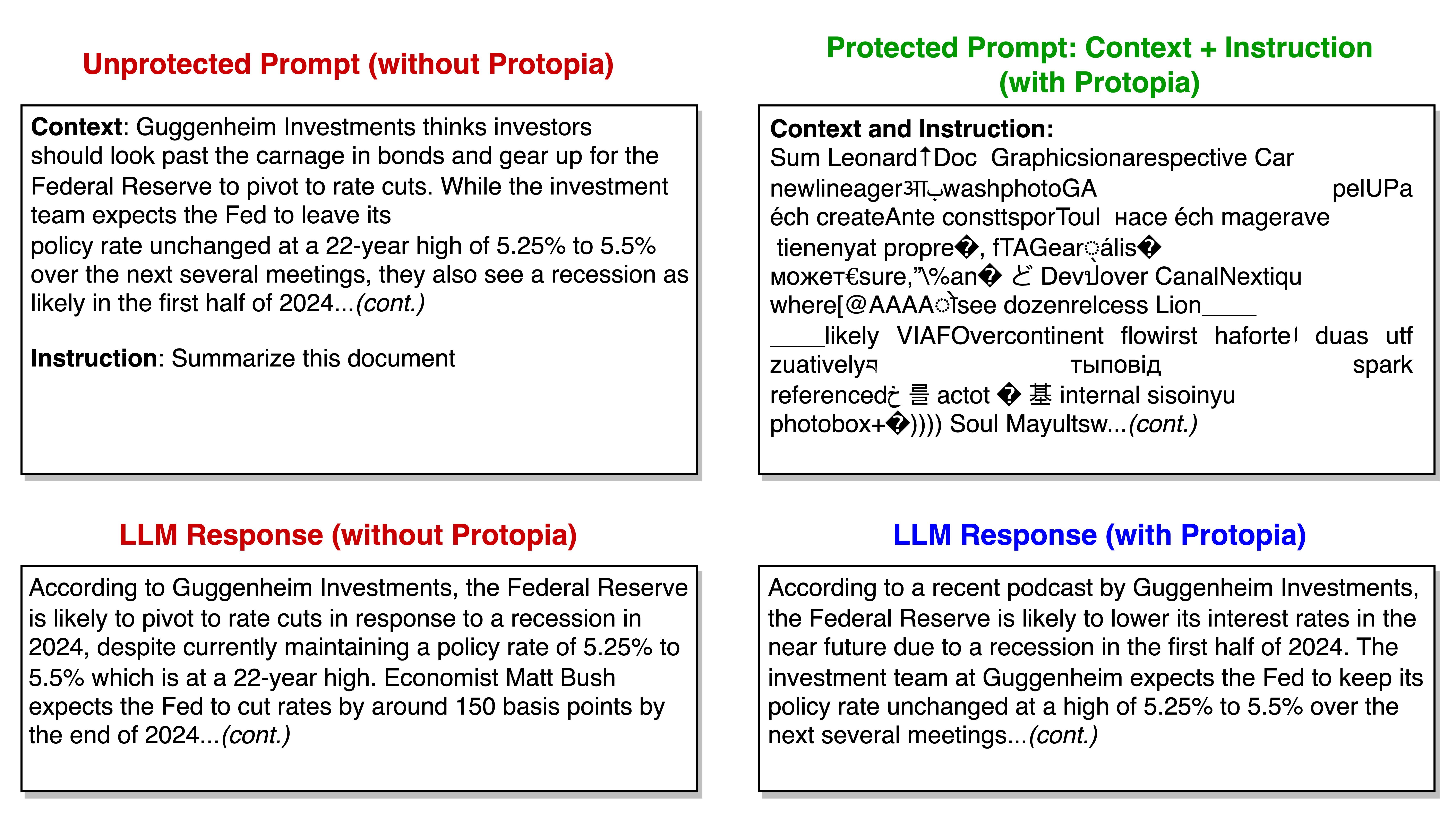

SGT ทำงานร่วมกับ LLM ที่ล้ำสมัย เช่น Llama 2 รูปต่อไปนี้แสดงตัวอย่างการนำ SGT ไปใช้กับโมเดล Llama 2 สำหรับการสอนตาม พร้อมทั้งเพิ่มชั้นการป้องกันให้กับคำสั่งและบริบท ด้านซ้ายของภาพแสดงตัวอย่างเอกสารทางการเงินเป็นบริบท โดยมีคำสั่งให้แบบจำลองสรุปเอกสาร ที่ด้านซ้ายล่าง การตอบสนองที่สร้างโดย Llama 2 เมื่อใช้งานบนพรอมต์ดิบจะปรากฏขึ้น เมื่อใช้ SGT การฝังที่เกี่ยวข้องกับพรอมต์นี้จะถูกแปลงบนฝั่งไคลเอ็นต์เป็นการฝังสุ่ม ดังที่อธิบายในรายละเอียดเพิ่มเติมภายหลังในโพสต์นี้ ด้านล่างขวาแสดงว่า Llama 2 ยังคงสามารถสร้างการตอบสนองที่ถูกต้องได้ หากข้อมูล RmoRed (การฝังหลังการเปลี่ยนแปลง) ถูกส่งไปแทนการฝังที่ไม่ได้รับการป้องกัน ด้านบนขวาแสดงว่าหากข้อมูล RmoRed รั่วไหล การสร้างพรอมต์เดิมขึ้นมาใหม่จะส่งผลให้มีข้อความที่ไม่สามารถเข้าใจได้

ในการสร้าง SGT สำหรับโมเดลที่กำหนด เช่น Llama 2 นั้น Protopia AI ได้จัดเตรียมไลบรารีน้ำหนักเบาที่เรียกว่า Stained Glass SDK ซึ่งเป็นส่วนขยายของ PyTorch ดังแสดงในรูปต่อไปนี้ หลังจากสร้าง SGT แล้ว จะสามารถรวมเข้ากับไปป์ไลน์การปรับใช้ได้หลายวิธี การแปลงที่สร้างขึ้นจาก SDK สามารถปรับใช้ภายในเครื่อง ในการตั้งค่าแบบไฮบริด หรือทั้งหมดบนระบบคลาวด์ สิ่งนี้เป็นไปได้เนื่องจาก SGT ได้รับการออกแบบให้เป็นกระบวนการที่มีน้ำหนักเบาซึ่งต้องใช้ทรัพยากรการประมวลผลน้อยมาก และด้วยเหตุนี้จึงมีผลกระทบน้อยที่สุดต่อเส้นทางวิกฤตของการอนุมาน การประเมินที่สำคัญอีกประการหนึ่งคือการรักษาความแม่นยำของแบบจำลองโดยใช้ข้อมูลที่เป็นตัวแทนใหม่ เราสังเกตเห็นว่าประเภทข้อมูลและรูปแบบต่างๆ ของแบบจำลอง ความแม่นยำจะคงอยู่ภายในขีดจำกัดความคลาดเคลื่อนที่ต้องการเมื่อใช้ข้อมูลที่เป็นตัวแทนอีกครั้ง

ตัวเลือกเหล่านี้สำหรับการปรับใช้และการรักษาความถูกต้องช่วยให้ผู้มีส่วนได้ส่วนเสียทั้งหมดภายในองค์กรสามารถนำ SGT ไปใช้ได้อย่างมั่นใจ เพื่อปกป้องเอาท์พุตของ LLM ให้ดียิ่งขึ้น Protopia AI สามารถเข้ารหัสเอาท์พุตการสืบค้นเพื่อแสดงซึ่งมีตัวถอดรหัสใช้งานได้เฉพาะกับเจ้าของข้อมูลระดับองค์กรเท่านั้น

ภาพรวมโซลูชัน

ส่วนก่อนหน้านี้อธิบายวิธีที่คุณสามารถใช้ Stained Glass Transform ในสถาปัตยกรรมที่หลากหลาย รูปต่อไปนี้ให้รายละเอียดขั้นตอนที่เกี่ยวข้องในการสร้าง การปรับใช้ และการใช้ SGT สำหรับ LLM:

- การสร้าง SGT – ทีมที่ฝึกอบรมโมเดลพื้นฐาน LLM (ผู้ให้บริการ LLM ที่เป็นกรรมสิทธิ์ ผู้ให้บริการระบบคลาวด์ หรือทีม ML ระดับองค์กรที่สร้าง LLM ของตนเอง) ใช้งานซอฟต์แวร์ Stained Glass SDK ของ Protopia AI โดยไม่เปลี่ยนแปลงแนวทางปฏิบัติที่มีอยู่สำหรับการฝึกอบรมและปรับใช้ LLM หลังจากการฝึกโมเดลพื้นฐานเสร็จสิ้นแล้ว SDK จะทำงานเป็นการส่งผ่านการปรับให้เหมาะสมผ่านโมเดลภาษาเพื่อคำนวณ SGT บัตรผ่านการปรับให้เหมาะสมนี้ส่งผ่านส่วนขยายไปยัง PyTorch SDK ล้อมรอบโมเดลพื้นฐานและค้นพบการแปลงกระจกสีที่เป็นเอกลักษณ์สำหรับ LLM นั้นในทางคณิตศาสตร์ รายละเอียดเพิ่มเติมของคณิตศาสตร์พื้นฐานสามารถพบได้ใน เอกสารไวท์เปเปอร์ที่แนบมาด้วย. โปรดทราบว่าเนื่องจากทีมที่ฝึกอบรม LLM เองก็กำลังใช้งาน Stained Glass SDK เช่นกัน จึงไม่เปิดเผยหรือส่งน้ำหนักแบบจำลองที่จำเป็นสำหรับขั้นตอนนี้ให้เสร็จสมบูรณ์

- การเปิดตัวและการปรับใช้ SGT – SGT ที่ส่งออกจากขั้นตอนการเพิ่มประสิทธิภาพก่อนหน้านี้จะถูกปรับใช้เป็นส่วนหนึ่งของไปป์ไลน์ข้อมูลที่ป้อน LLM ที่ได้รับการฝึกอบรม ตามที่อธิบายไว้ในส่วนก่อนหน้า SGT อยู่ที่ฝั่งไคลเอ็นต์ระดับองค์กร

- การใช้ SGT – SGT ทำงานบนพร้อมท์ที่สร้างโดยองค์กร และสร้างพร้อมต์ที่มีการป้องกัน ซึ่งจะถูกส่งไปยัง LLM ที่ปรับใช้ ซึ่งช่วยให้องค์กรสามารถรักษาความเป็นเจ้าของแบบสอบถามและบริบทที่ละเอียดอ่อนได้ การใช้กระจกสี Protopia AI ข้อมูลที่ละเอียดอ่อนที่ไม่มีการป้องกันจะไม่ออกจากไซต์หรือโซนความน่าเชื่อถือขององค์กร

คุณสามารถใช้ Stained Glass SDK เพื่อสร้าง SGT ได้หลายวิธี ตัวอย่างเช่น คุณสามารถใช้ Stained Glass SDK ในสภาพแวดล้อมการเรียนรู้ของเครื่อง (ML) แบบจัดการด้วยตนเองได้ บริการ Amazon Elastic Kubernetes (Amazon EKS) สำหรับการฝึกอบรมและการอนุมานหรือภายใน อเมซอน อีลาสติก คอมพิวท์ คลาวด์ (อเมซอน EC2) โดยตรง อีกทางเลือกหนึ่งคือสามารถเรียกใช้ภายในได้ อเมซอน SageMaker เพื่อสร้าง SGT สำหรับโมเดลที่ผ่านการฝึกอบรมที่กำหนด การแปลงอินพุตสำหรับการปรับใช้ระหว่างการอนุมานจากไคลเอนต์ไม่ขึ้นอยู่กับการใช้งานการปรับใช้ที่เลือก

รูปภาพต่อไปนี้แสดงให้เห็นถึงการใช้งานที่เป็นไปได้ในสภาพแวดล้อม ML ที่มีการจัดการด้วยตนเอง โดยที่การฝึกอบรมการแปลงกระจกสีจะดำเนินการบน Amazon EKS

ในเวิร์กโฟลว์นี้ คอนเทนเนอร์จะถูกสร้างขึ้นโดยใช้ Stained Glass SDK และปรับใช้ การลงทะเบียน Amazon Elastic Container (อเมซอน อีซีอาร์). จากนั้นคอนเทนเนอร์นี้จะถูกปรับใช้บน Amazon EKS เพื่อฝึก SGT ที่ถูกบันทึกไว้ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (อเมซอน S3). หากคุณใช้ Amazon EC2 คุณสามารถฝึกการเปลี่ยนแปลงได้โดยตรงบนอินสแตนซ์ของคุณโดยเป็นส่วนหนึ่งของการตั้งค่า ML Stained Glass SDK สามารถทำงานบนอินสแตนซ์ได้หลายประเภท รวมถึงกลุ่มอินสแตนซ์ Amazon P5, P4 หรือ G5 ตามข้อกำหนด LLM พื้นฐานของคุณ หลังจากที่ LLM ถูกปรับใช้เพื่อใช้สำหรับการอนุมาน แอปพลิเคชันไคลเอนต์จะใช้ SGT ที่สร้างขึ้น ซึ่งเป็นการดำเนินการแบบเบา เพื่อแปลงพร้อมท์และบริบทก่อนที่จะส่งไปยัง LLM เมื่อทำเช่นนี้ เฉพาะข้อมูลที่แปลงแล้วเท่านั้นที่จะเปิดเผยต่อ LLM และความเป็นเจ้าของอินพุตดั้งเดิมจะยังคงอยู่ที่ฝั่งไคลเอ็นต์

รูปต่อไปนี้สาธิตวิธีที่คุณสามารถฝึกการแปลงและดำเนินการอนุมานบน SageMaker

การสร้าง SGT เป็นไปตามเส้นทางที่คล้ายกันกับการตั้งค่า Amazon EKS โดยการนำเข้าข้อมูลการฝึกจาก Amazon S3, การฝึก SGT บนคอนเทนเนอร์ และบันทึกลงใน Amazon S3 คุณสามารถใช้ Stained Glass SDK ในการตั้งค่า SageMaker ที่มีอยู่ได้ สตูดิโอ Amazon SageMaker, โน้ตบุ๊ค SageMakerและใน งานฝึกอบรม SageMaker. LLM โฮสต์เป็นตำแหน่งข้อมูล SageMaker ที่แอปพลิเคชันไคลเอ็นต์เข้าถึงได้ การอนุมานสำหรับแอปพลิเคชันไคลเอนต์ยังเหมือนกับการตั้งค่า Amazon EKS ยกเว้นสิ่งที่ให้บริการโมเดล

การนำเสนอซ้ำแบบสุ่มเพื่อปกป้องพรอมต์ LLM และการปรับแต่งข้อมูล

ส่วนนี้ครอบคลุมถึงกรณีการใช้งานที่หลากหลายซึ่งสาธิตว่าการแสดงซ้ำแบบสุ่มช่วยปกป้องพร้อมท์ LLM ได้อย่างไร ตัวอย่างเหล่านี้แสดงให้เห็นถึงผลกระทบที่สำคัญสำหรับความพยายามในการสร้างสรรค์ AI สำหรับองค์กร: การเปิดประตูใหม่สู่กรณีการใช้งาน AI การเร่งความเร็วในการออกสู่ตลาดในขณะที่ปกป้องข้อมูลขององค์กรอย่างเหมาะสม และการรักษาความเป็นเจ้าของข้อมูลที่ละเอียดอ่อนที่จำเป็นสำหรับใช้ในพร้อมท์ LLM

กรณีการใช้งาน RAG

กรณีการใช้งานระดับองค์กรยอดนิยมสำหรับ LLM คือ การดึงข้อมูล Augmented Generation (RAG) รูปภาพต่อไปนี้แสดงตัวอย่างภาพประกอบที่ข้อความแจ้งและแหล่งที่มาได้รับการปกป้องโดยใช้กระจกสี ด้านซ้ายของภาพแสดงข้อความแจ้งและข้อมูลแหล่งที่มาที่ไม่มีการป้องกัน ในการดำเนินการ RAG ระดับองค์กร แหล่งที่มาอาจรวมถึงข้อมูลที่ละเอียดอ่อน เช่น ความลับทางการค้าขององค์กร ทรัพย์สินทางปัญญา หรือข้อมูลทางการเงิน ด้านขวาแสดงการสร้างข้อความที่มนุษย์อ่านได้ใหม่ที่ดีที่สุดเท่าที่จะเป็นไปได้จากข้อความแจ้ง RmoRed ที่สร้างโดย SGT

เราสามารถสังเกตได้ว่าแม้จะเป็นการสร้างใหม่ที่ดีที่สุดเท่าที่จะเป็นไปได้ ข้อมูลก็ถูกทำให้สับสนโดยสิ้นเชิง อย่างไรก็ตาม การตอบสนองจากโมเดลที่มีและไม่มีการแปลงจะเหมือนกัน โดยมีตัวชี้ไปยังเอกสารต้นฉบับ ดังนั้นจึงรักษาความถูกต้องของทั้งคำถามและเอกสารต้นฉบับในขณะที่ดำเนินการกรณีการใช้งานระดับองค์กรยอดนิยมนี้

การบังคับใช้ในวงกว้างสำหรับ LLM และภาษาต่างๆ

จุดเด่นประการหนึ่งของ Stained Glass SDK ก็คือมีความยืดหยุ่นสูงในการสร้างโมเดลที่ก้าวหน้าและสามารถปรับเปลี่ยนให้เข้ากับโมเดลที่ล้ำสมัย เช่น ลามะ 2. รูปต่อไปนี้แสดง SGT ที่สร้างขึ้นบน Llama 2 LLM ที่ได้รับการปรับแต่งก่อนหน้านี้สำหรับการทำงานกับข้อความภาษาญี่ปุ่น ตัวอย่างนี้แสดงให้เห็นเพิ่มเติมว่า SGT สามารถสร้างและนำไปใช้กับภาษาใดก็ได้ และแม้กระทั่งอินพุตสำหรับโมเดลที่ได้รับการปรับแต่งอย่างละเอียดก็สามารถแปลงได้ การบังคับใช้ทั่วไปของ SGT นั้นขับเคลื่อนโดยรากฐานที่แข็งแกร่งของ Stained Glass SDK ซึ่งเป็นโมเดลและไม่เชื่อเรื่องข้อมูล

การปกป้องข้อมูลการปรับแต่งอย่างละเอียดตลอดจนการแจ้งเตือน

Stained Glass Transform ไม่ได้จำกัดเพียงการปกป้องข้อมูลในเวลาอนุมานเท่านั้น นอกจากนี้ยังสามารถปกป้องข้อมูลที่ใช้ในการปรับแต่งโมเดลพื้นฐานได้อีกด้วย กระบวนการสร้างการเปลี่ยนแปลงสำหรับชุดข้อมูลที่มีการปรับแต่งอย่างละเอียดจะเหมือนกับที่อธิบายไว้ในส่วนสถาปัตยกรรมโซลูชันก่อนหน้าในโพสต์นี้ การเปลี่ยนแปลงถูกสร้างขึ้นเพื่อให้โมเดลพื้นฐานได้รับการปรับแต่งอย่างละเอียดโดยไม่ต้องเข้าถึงข้อมูลที่มีการปรับแต่งอย่างละเอียด หลังจากที่ SGT ถูกสร้างขึ้นและฝึกฝนสำหรับโมเดลพื้นฐานแล้ว ชุดข้อมูลที่ปรับแต่งอย่างละเอียดจะถูกแปลงเป็นการสุ่มแทนซ้ำ ซึ่งจากนั้นจะถูกนำมาใช้เพื่อปรับแต่งโมเดลพื้นฐานอย่างละเอียด กระบวนการนี้จะอธิบายรายละเอียดเพิ่มเติมใน เอกสารไวท์เปเปอร์ที่แนบมาด้วย.

ในตัวอย่างต่อไปนี้ ลูกค้าองค์กรจำเป็นต้องปรับแต่งโมเดลที่มีอยู่สำหรับการตรวจหาความผิดปกติของบันทึกเครือข่าย พวกเขาใช้กระจกสีเพื่อแปลงชุดข้อมูลที่ละเอียดอ่อนซึ่งมีการปรับแต่งอย่างละเอียดเป็นการฝังแบบสุ่ม ซึ่งใช้ในการปรับแต่งโมเดลพื้นฐานอย่างละเอียด พวกเขาพบว่าแบบจำลองการตรวจจับที่ได้รับการปรับแต่งอย่างละเอียดบนการนำเสนอที่แปลงแล้วมีความแม่นยำเกือบเท่ากันเมื่อเปรียบเทียบกับสถานการณ์สมมติในการปรับแต่งแบบจำลองพื้นฐานบนชุดข้อมูลการปรับแต่งแบบละเอียดที่ไม่มีการป้องกัน ตารางต่อไปนี้แสดงสองตัวอย่างของบันทึกข้อมูลข้อความธรรมดาจากชุดข้อมูลที่มีการปรับแต่ง และการสร้างข้อความของบันทึกข้อมูลเดียวกันเหล่านั้นจากชุดข้อมูลที่มีการปรับแต่งอย่างละเอียด

ภายใต้ฝากระโปรงของ Stained Glass Transform สำหรับ LLM

เมื่อนำไปใช้กับคอมพิวเตอร์วิทัศน์ SGT จะดำเนินการกับคุณสมบัติพิกเซลอินพุต และสำหรับ LLM จะดำเนินการที่ระดับการฝัง เพื่อเน้นวิธีการทำงานของ Stained Glass Transform ลองจินตนาการถึงการฝังพร้อมท์เป็นเมทริกซ์ ดังภาพประกอบทางด้านซ้ายของรูปต่อไปนี้ ในแต่ละรายการจะมีค่าที่กำหนดขึ้น ค่านี้สามารถแมปกับข้อมูลต้นฉบับได้ โดยเปิดเผยพร้อมท์ที่ไม่มีการป้องกัน การแปลงกระจกสีจะแปลงเมทริกซ์ของค่าที่กำหนดให้เป็นเมทริกซ์ที่มีองค์ประกอบเป็นกลุ่มก้อนเมฆแห่งความเป็นไปได้

พรอมต์ที่แปลงแล้วจะถูกเรนเดอร์โดยการสุ่มสัญญาณรบกวนจากการแจกแจงความน่าจะเป็นที่กำหนดโดย SGT และเพิ่มสัญญาณรบกวนตัวอย่างลงในการฝังที่กำหนด ซึ่งจะสุ่มค่าพรอมต์ดั้งเดิมอย่างไม่สามารถย้อนกลับได้ แบบจำลองยังคงเข้าใจพรอมต์ที่แสดงซ้ำแบบสุ่มในระดับคณิตศาสตร์และสามารถทำงานได้อย่างถูกต้อง

สรุป

โพสต์นี้พูดคุยถึงวิธีที่ Stained Glass Transform ของ Protopia AI แยกการเป็นเจ้าของข้อมูลดิบและการปกป้องจากกระบวนการดำเนินการ ML ได้อย่างไร ทำให้องค์กรต่างๆ สามารถรักษาความเป็นเจ้าของและรักษาความเป็นส่วนตัวของข้อมูลที่ละเอียดอ่อนในพร้อมท์ LLM และการปรับแต่งข้อมูล ด้วยการใช้การปกป้องข้อมูลอันล้ำสมัยสำหรับการใช้งาน LLM องค์กรต่างๆ สามารถเร่งการนำโมเดลพื้นฐานและ LLM มาใช้โดยไม่ต้องกังวลกับการเปิดเผยข้อมูลที่ละเอียดอ่อนน้อยลง ด้วยการปลดล็อกคุณค่าในข้อมูลองค์กรจริงอย่างปลอดภัย องค์กรต่างๆ จึงสามารถบรรลุประสิทธิภาพที่สัญญาไว้และผลลัพธ์ทางธุรกิจของ LLM ได้อย่างมีประสิทธิภาพและรวดเร็วยิ่งขึ้น หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับเทคโนโลยีนี้ คุณสามารถอ่านเพิ่มเติมได้ใน เอกสารไวท์เปเปอร์ที่แนบมาด้วย และ เชื่อมต่อกับ Protopia AI เพื่อเข้าถึงและทดลองใช้กับข้อมูลองค์กรของคุณ

เกี่ยวกับ Protopia AI

Protopia AI เป็นผู้นำในด้านการปกป้องข้อมูลและเทคโนโลยี AI/ML ที่รักษาความเป็นส่วนตัว ซึ่งตั้งอยู่ในเมืองออสติน รัฐเท็กซัส และเชี่ยวชาญในการทำให้อัลกอริธึม AI และแพลตฟอร์มซอฟต์แวร์สามารถทำงานได้โดยไม่จำเป็นต้องเข้าถึงข้อมูลที่เป็นข้อความธรรมดา ในช่วง 2 ปีที่ผ่านมา Protopia AI ประสบความสำเร็จในการสาธิตผลิตภัณฑ์ Stained Glass Transform ซึ่งเป็นผลิตภัณฑ์เรือธงของตนผ่านกรณีการใช้งาน ML และประเภทข้อมูลที่หลากหลายกับกองทัพเรือสหรัฐฯ บริการทางการเงินชั้นนำ และผู้ให้บริการเทคโนโลยีระดับโลก

Protopia AI ทำงานร่วมกับองค์กรต่างๆ ผู้ให้บริการ generative AI และ LLM และผู้ให้บริการระบบคลาวด์ (CSP) เพื่อรักษาความเป็นเจ้าของและการรักษาความลับของข้อมูลองค์กรในขณะที่ใช้โซลูชัน AI/ML Protopia AI ได้ร่วมมือกับ AWS เพื่อมอบองค์ประกอบที่สำคัญของการปกป้องข้อมูลและความเป็นเจ้าของสำหรับการนำ AI ทั่วไปมาใช้ในระดับองค์กร และเป็นหนึ่งใน 21 บริษัทสตาร์ทอัพที่ได้รับเลือกให้เข้าร่วมงานครั้งแรก AWS Generative AI Accelerator ในปี 2023.

เกี่ยวกับผู้แต่ง

พลาจี จันทรเสการัน เป็นรองประธานฝ่าย Go-to-Market & Customer Enablement ที่ Protopia AI ทำงานอย่างใกล้ชิดกับลูกค้าเพื่อใช้ประโยชน์จาก AI ในธุรกิจของพวกเขา ขณะเดียวกันก็ให้ความสำคัญกับการปกป้องข้อมูลและความเป็นส่วนตัว ก่อนที่จะมาร่วมงานกับ Protopia AI นั้น Balaji ดำรงตำแหน่งหัวหน้าผลิตภัณฑ์สำหรับโซลูชัน AI ของ Infor โดยพัฒนาผลิตภัณฑ์ที่เน้นคุณค่าเป็นหลัก ขณะเดียวกันก็ทำหน้าที่เป็นพันธมิตรที่เชื่อถือได้สำหรับลูกค้าองค์กรในอุตสาหกรรมที่หลากหลาย ภายนอกงาน เขาชอบดนตรี เดินป่า และท่องเที่ยวกับครอบครัว

พลาจี จันทรเสการัน เป็นรองประธานฝ่าย Go-to-Market & Customer Enablement ที่ Protopia AI ทำงานอย่างใกล้ชิดกับลูกค้าเพื่อใช้ประโยชน์จาก AI ในธุรกิจของพวกเขา ขณะเดียวกันก็ให้ความสำคัญกับการปกป้องข้อมูลและความเป็นส่วนตัว ก่อนที่จะมาร่วมงานกับ Protopia AI นั้น Balaji ดำรงตำแหน่งหัวหน้าผลิตภัณฑ์สำหรับโซลูชัน AI ของ Infor โดยพัฒนาผลิตภัณฑ์ที่เน้นคุณค่าเป็นหลัก ขณะเดียวกันก็ทำหน้าที่เป็นพันธมิตรที่เชื่อถือได้สำหรับลูกค้าองค์กรในอุตสาหกรรมที่หลากหลาย ภายนอกงาน เขาชอบดนตรี เดินป่า และท่องเที่ยวกับครอบครัว

เจนนิเฟอร์ ควาเกนเบิร์ก เป็นผู้นำทีมวิศวกรที่ Protopia AI และทำงานเพื่อให้แน่ใจว่าเทคโนโลยีกระจกสีตรงตามความต้องการของลูกค้าในการปกป้องข้อมูลของพวกเขา Jennifer มีประสบการณ์มาก่อนในการทำงานด้านความปลอดภัยที่ Toyota ในกลุ่ม Product Cybersecurity Group จัดการปริมาณงานบนคลาวด์ที่ N-able และรับผิดชอบข้อมูลที่ Match.com

เจนนิเฟอร์ ควาเกนเบิร์ก เป็นผู้นำทีมวิศวกรที่ Protopia AI และทำงานเพื่อให้แน่ใจว่าเทคโนโลยีกระจกสีตรงตามความต้องการของลูกค้าในการปกป้องข้อมูลของพวกเขา Jennifer มีประสบการณ์มาก่อนในการทำงานด้านความปลอดภัยที่ Toyota ในกลุ่ม Product Cybersecurity Group จัดการปริมาณงานบนคลาวด์ที่ N-able และรับผิดชอบข้อมูลที่ Match.com

แอนดรูว์ สันสม เป็นวิศวกรโซลูชัน AI ที่ Protopia AI โดยที่เขาช่วยให้องค์กรต่างๆ ใช้ AI ในขณะเดียวกันก็รักษาข้อมูลส่วนตัวและข้อมูลที่ละเอียดอ่อนไว้ในข้อมูลของพวกเขา ก่อนที่จะมาร่วมงานกับ Protopia AI เขาเคยทำงานเป็นที่ปรึกษาทางเทคนิคที่มุ่งเน้นการเปิดใช้งานโซลูชัน AI ให้กับลูกค้าในอุตสาหกรรมต่างๆ มากมาย รวมถึงการเงิน การผลิต การดูแลสุขภาพ และการศึกษา นอกจากนี้เขายังสอนวิทยาการคอมพิวเตอร์และคณิตศาสตร์ให้กับนักเรียนมัธยมปลาย มหาวิทยาลัย และนักศึกษาวิชาชีพอีกด้วย

แอนดรูว์ สันสม เป็นวิศวกรโซลูชัน AI ที่ Protopia AI โดยที่เขาช่วยให้องค์กรต่างๆ ใช้ AI ในขณะเดียวกันก็รักษาข้อมูลส่วนตัวและข้อมูลที่ละเอียดอ่อนไว้ในข้อมูลของพวกเขา ก่อนที่จะมาร่วมงานกับ Protopia AI เขาเคยทำงานเป็นที่ปรึกษาทางเทคนิคที่มุ่งเน้นการเปิดใช้งานโซลูชัน AI ให้กับลูกค้าในอุตสาหกรรมต่างๆ มากมาย รวมถึงการเงิน การผลิต การดูแลสุขภาพ และการศึกษา นอกจากนี้เขายังสอนวิทยาการคอมพิวเตอร์และคณิตศาสตร์ให้กับนักเรียนมัธยมปลาย มหาวิทยาลัย และนักศึกษาวิชาชีพอีกด้วย

ไอมาน เอบราฮิมิ, PhD, เป็นผู้ร่วมก่อตั้งและเป็นประธานเจ้าหน้าที่บริหารของ Protopia AI Dr. Ebrahimi มีความหลงใหลในการทำให้ AI สามารถเพิ่มพูนประสบการณ์ของมนุษย์ในแนวดิ่งทางสังคมและอุตสาหกรรมที่แตกต่างกัน Protopia AI เป็นวิสัยทัศน์ในการเพิ่มประสิทธิภาพเลนส์ โดยที่ AI จะสังเกตข้อมูลที่จำเป็นและมีคุณภาพที่ต้องการ ขณะเดียวกันก็สร้างความสามารถใหม่ในการปกป้องข้อมูลที่ละเอียดอ่อน ก่อนที่จะมี Protopia AI เขาเป็นนักวิทยาศาสตร์การวิจัยอาวุโสที่ NVIDIA เป็นเวลา 9 ปี งานของเขาในการวิจัยของ NVIDIA มีวัตถุประสงค์เพื่อแก้ไขปัญหาในการเข้าถึงชุดข้อมูลขนาดใหญ่ใน ML/AI นอกจากนี้เขายังร่วมเขียนสิ่งพิมพ์ที่ได้รับการตรวจสอบโดยผู้ทรงคุณวุฒิเกี่ยวกับวิธีการใช้พลังของ GPU นับพันตัวเพื่อให้การฝึกอบรมโมเดลภาษาขนาดใหญ่เป็นไปได้

ไอมาน เอบราฮิมิ, PhD, เป็นผู้ร่วมก่อตั้งและเป็นประธานเจ้าหน้าที่บริหารของ Protopia AI Dr. Ebrahimi มีความหลงใหลในการทำให้ AI สามารถเพิ่มพูนประสบการณ์ของมนุษย์ในแนวดิ่งทางสังคมและอุตสาหกรรมที่แตกต่างกัน Protopia AI เป็นวิสัยทัศน์ในการเพิ่มประสิทธิภาพเลนส์ โดยที่ AI จะสังเกตข้อมูลที่จำเป็นและมีคุณภาพที่ต้องการ ขณะเดียวกันก็สร้างความสามารถใหม่ในการปกป้องข้อมูลที่ละเอียดอ่อน ก่อนที่จะมี Protopia AI เขาเป็นนักวิทยาศาสตร์การวิจัยอาวุโสที่ NVIDIA เป็นเวลา 9 ปี งานของเขาในการวิจัยของ NVIDIA มีวัตถุประสงค์เพื่อแก้ไขปัญหาในการเข้าถึงชุดข้อมูลขนาดใหญ่ใน ML/AI นอกจากนี้เขายังร่วมเขียนสิ่งพิมพ์ที่ได้รับการตรวจสอบโดยผู้ทรงคุณวุฒิเกี่ยวกับวิธีการใช้พลังของ GPU นับพันตัวเพื่อให้การฝึกอบรมโมเดลภาษาขนาดใหญ่เป็นไปได้

โรหิต ตัลลูรี เป็นผู้เชี่ยวชาญด้าน Generative AI GTM ที่ Amazon Web Services (AWS) เขากำลังร่วมมือกับผู้สร้างโมเดล AI ชั้นนำ ลูกค้าเชิงกลยุทธ์ คู่ค้า AI/ML หลัก และทีมบริการของ AWS เพื่อเปิดใช้งานปัญญาประดิษฐ์ การเรียนรู้ของเครื่อง และการประมวลผลแบบเร่งความเร็วรุ่นต่อไปบน AWS ก่อนหน้านี้เขาเคยเป็นสถาปนิกโซลูชันองค์กร และหัวหน้าโซลูชันระดับโลกสำหรับที่ปรึกษาการควบรวมกิจการและการเข้าซื้อกิจการของ AWS

โรหิต ตัลลูรี เป็นผู้เชี่ยวชาญด้าน Generative AI GTM ที่ Amazon Web Services (AWS) เขากำลังร่วมมือกับผู้สร้างโมเดล AI ชั้นนำ ลูกค้าเชิงกลยุทธ์ คู่ค้า AI/ML หลัก และทีมบริการของ AWS เพื่อเปิดใช้งานปัญญาประดิษฐ์ การเรียนรู้ของเครื่อง และการประมวลผลแบบเร่งความเร็วรุ่นต่อไปบน AWS ก่อนหน้านี้เขาเคยเป็นสถาปนิกโซลูชันองค์กร และหัวหน้าโซลูชันระดับโลกสำหรับที่ปรึกษาการควบรวมกิจการและการเข้าซื้อกิจการของ AWS

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/foundational-data-protection-for-enterprise-llm-acceleration-with-protopia-ai/