Idag är vi glada att kunna meddela att Meta Llama 3 foundation-modeller är tillgängliga genom Amazon SageMaker JumpStart att distribuera och köra slutledning. Llama 3-modellerna är en samling förtränade och finjusterade generativa textmodeller.

I det här inlägget går vi igenom hur du upptäcker och distribuerar Llama 3-modeller via SageMaker JumpStart.

Vad är Meta Llama 3

Llama 3 kommer i två parameterstorlekar - 8B och 70B med 8k kontextlängd - som kan stödja ett brett spektrum av användningsfall med förbättringar i resonemang, kodgenerering och instruktioner att följa. Llama 3 använder en transformatorarkitektur endast avkodare och ny tokenizer som ger förbättrad modellprestanda med 128k storlek. Dessutom förbättrade Meta procedurerna efter träning som avsevärt minskade antalet falska avslag, förbättrade anpassningen och ökade mångfalden i modellsvar. Du kan nu få de kombinerade fördelarna med Llama 3-prestanda och MLOps-kontroller med Amazon SageMaker-funktioner som SageMaker Pipelines, SageMaker Debugger eller containerloggar. Dessutom kommer modellen att distribueras i en AWS säker miljö under dina VPC-kontroller, vilket hjälper till att tillhandahålla datasäkerhet.

Vad är SageMaker JumpStart

Med SageMaker JumpStart kan du välja från ett brett urval av allmänt tillgängliga foundationmodeller. ML-utövare kan distribuera grundmodeller till dedikerade SageMaker-instanser från en nätverksisolerad miljö och anpassa modeller med SageMaker för modellutbildning och implementering. Du kan nu upptäcka och distribuera Llama 3-modeller med några få klick in Amazon SageMaker Studio eller programmatiskt genom SageMaker Python SDK, vilket gör att du kan härleda modellprestanda och MLOps-kontroller med SageMaker-funktioner som t.ex. SageMaker-rörledningar, SageMaker-felsökare, eller behållarloggar. Modellen distribueras i en AWS säker miljö och under dina VPC-kontroller, vilket hjälper till att tillhandahålla datasäkerhet. Llama 3-modeller är tillgängliga idag för distribution och slutledning i Amazon SageMaker Studio i us-east-1 (N. Virginia), us-east-2 (Ohio), us-west-2 (Oregon), eu-west-1 (Irland) och ap-northeast-1 (Tokyo) AWS-regioner.

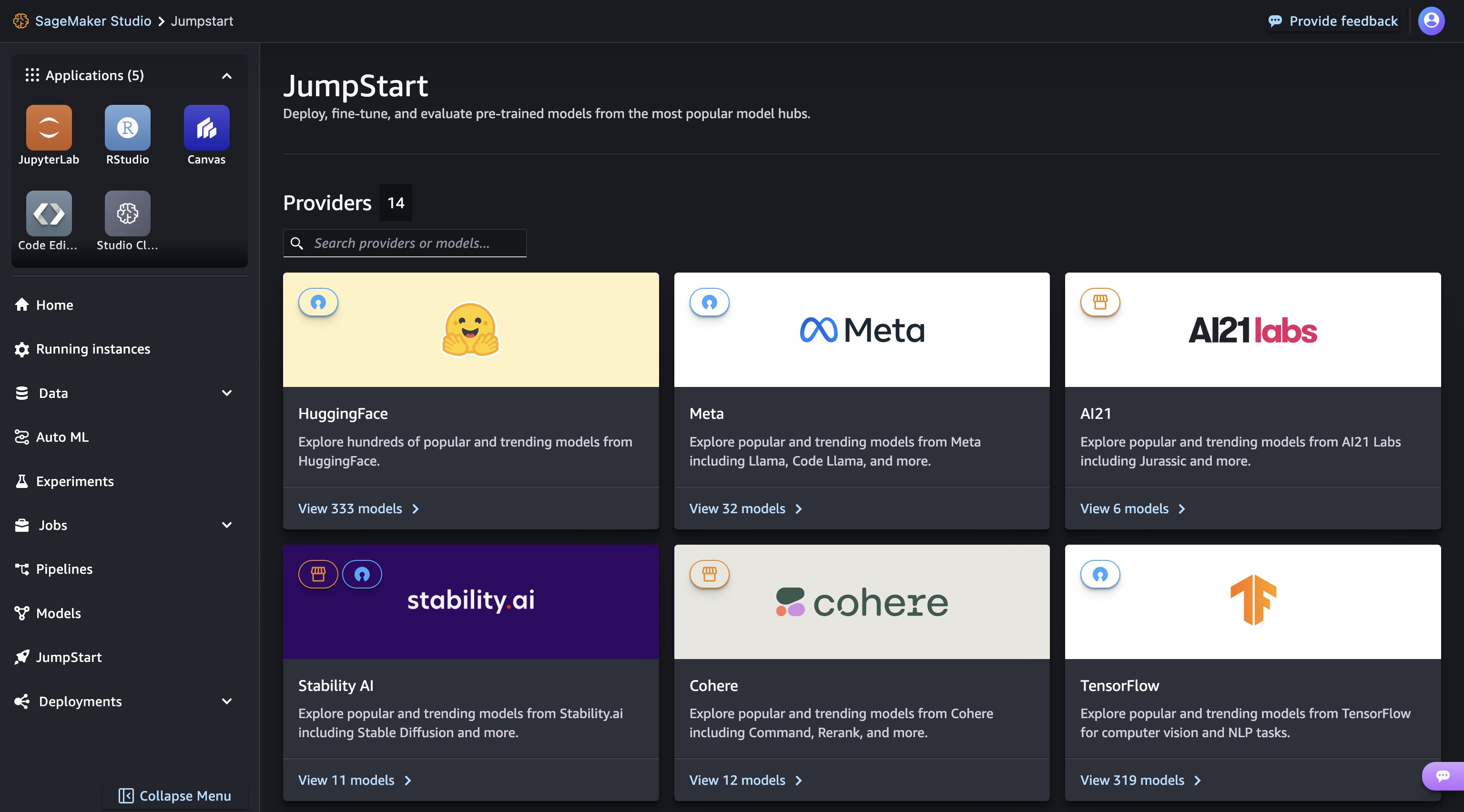

Upptäck modeller

Du kan komma åt grundmodellerna genom SageMaker JumpStart i SageMaker Studio UI och SageMaker Python SDK. I det här avsnittet går vi igenom hur du upptäcker modellerna i SageMaker Studio.

SageMaker Studio är en integrerad utvecklingsmiljö (IDE) som tillhandahåller ett enda webbaserat visuellt gränssnitt där du kan komma åt specialbyggda verktyg för att utföra alla ML-utvecklingssteg, från att förbereda data till att bygga, träna och distribuera dina ML-modeller. För mer information om hur du kommer igång och konfigurerar SageMaker Studio, se Amazon SageMaker Studio.

I SageMaker Studio kan du komma åt SageMaker JumpStart, som innehåller förutbildade modeller, bärbara datorer och förbyggda lösningar, under Förbyggda och automatiserade lösningar.

Från SageMaker JumpStarts landningssida kan du enkelt upptäcka olika modeller genom att bläddra igenom olika nav som är uppkallade efter modellleverantörer. Du kan hitta Llama 3-modeller i Meta hub. Om du inte ser Llama 3-modeller, uppdatera din SageMaker Studio-version genom att stänga av och starta om. För mer information, se Stäng av och uppdatera Studio Classic-appar.

Du kan hitta Llama 3-modeller genom att söka efter "Meta-llama-3" i sökrutan längst upp till vänster.

Du kan upptäcka alla Meta-modeller som finns tillgängliga i SageMaker JumpStart genom att klicka på Meta hub.

Genom att klicka på ett modellkort öppnas motsvarande modelldetaljsida, från vilken du enkelt kan distribuera modellen.

Distribuera en modell

När du väljer Distribuera och bekräfta villkoren för EULA, kommer implementeringen att starta.

Du kan övervaka utvecklingen av distributionen på sidan som visas efter att du klickat på knappen Distribuera.

Alternativt kan du välja Öppna anteckningsboken att distribuera genom exemplet på anteckningsboken. Exemplet på anteckningsboken ger vägledning från början till slut om hur man distribuerar modellen för slutledning och städar upp resurser.

För att distribuera med hjälp av anteckningsboken börjar du med att välja en lämplig modell, specificerad av model_id. Du kan distribuera vilken som helst av de valda modellerna på SageMaker med följande kod.

Som standard accept_eula är inställd på False. Du måste manuellt acceptera licensavtalet för att distribuera slutpunkten framgångsrikt. Genom att göra det accepterar du användarlicensavtalet och policyn för acceptabel användning. Du kan också hitta licensavtalet Lama hemsida. Detta distribuerar modellen på SageMaker med standardkonfigurationer inklusive standardinstanstypen och standard VPC-konfigurationer. Du kan ändra dessa konfigurationer genom att ange icke-standardvärden i JumpStartModel. För att lära dig mer, se följande dokumentation.

Följande tabell listar alla Llama 3-modeller som finns tillgängliga i SageMaker JumpStart tillsammans med model_ids, standardinstanstyper och maximalt antal totala tokens (summan av antalet inmatade tokens och antalet genererade tokens) som stöds för var och en av dessa modeller.

| Modellnamn | Modell-ID | Max totalt antal tokens | Standardinstanstyp |

| Meta-Llama-3-8B | meta-textgeneration-llama-3-8B | 8192 | ml.g5.12xlarge |

| Meta-Llama-3-8B-instruktion | meta-textgeneration-llama-3-8B-instruct | 8192 | ml.g5.12xlarge |

| Meta-Llama-3-70B | meta-textgeneration-llama-3-70b | 8192 | ml.p4d.24xlarge |

| Meta-Llama-3-70B-instruktion | meta-textgeneration-llama-3-70b-instruct | 8192 | ml.p4d.24xlarge |

Kör slutledning

När du har distribuerat modellen kan du köra slutledning mot den distribuerade slutpunkten genom SageMaker-prediktorn. Finjusterade instruktionsmodeller (Llama 3: 8B Instruct och 70B Instruct) accepterar en historik av chattar mellan användaren och chattassistenten och genererar den efterföljande chatten. De förtränade modellerna (Llama 3: 8B och 70B) kräver en strängprompt och utför textkomplettering på den medföljande prompten.

Inferensparametrar styr textgenereringsprocessen vid slutpunkten. Max nya tokens styr storleken på utdata som genereras av modellen. Detta är inte samma som antalet ord eftersom modellens ordförråd inte är detsamma som det engelska ordförrådet, och varje token kanske inte är ett engelskspråkigt ord. Temperaturparametern styr slumpmässigheten i utgången. Högre temperatur resulterar i mer kreativa och hallucinerade utgångar. Alla inferensparametrar är valfria.

Exempelmeddelanden för 70B-modellen

Du kan använda Llama 3-modeller för textkomplettering för vilken text som helst. Genom textgenerering kan du utföra en mängd olika uppgifter som att svara på frågor, översätta språk och analysera känslor med mera. Indatanyttolasten till slutpunkten ser ut som följande kod:

Följande är några exempel på uppmaningar och texten som genereras av modellen. Alla utgångar genereras med inferensparametrar {"max_new_tokens":64, "top_p":0.9, "temperature":0.6}.

I nästa exempel visar vi hur man använder Llama 3-modeller med få skott i kontextinlärning där vi tillhandahåller träningsexempel tillgängliga för modellen. Vi kör bara slutsatser om den utplacerade modellen och under denna process, och modellvikterna ändras inte.

Exempelmeddelanden för 70B-Instruct-modellen

Med Llama 3-instruktionsmodeller som är optimerade för dialoganvändningsfall, är input till instruktionsmodellens slutpunkter den tidigare historiken mellan chattassistenten och användaren. Du kan ställa frågor kontextuella till konversationen som har hänt hittills. Du kan också tillhandahålla systemkonfigurationen, såsom personas, som definierar chattassistentens beteende. Även om det inmatade nyttolastformatet är detsamma som den förtränade basmodellen, bör den inmatade texten formateras på följande sätt:

I den här instruktionsmallen kan du valfritt börja med en system roll och inkludera så många alternerande roller som önskas i den turbaserade historien. Den sista rollen ska alltid vara assistant och avsluta med två nya radmatningar.

Överväg sedan några exempel på uppmaningar och svar från modellen. I följande exempel ställer användaren en enkel fråga till assistenten.

I följande exempel har användaren ett samtal med assistenten om turistplatser i Paris. Sedan frågar användaren om det första alternativet som rekommenderas av chattassistenten.

I följande exempel ställer vi in systemets konfiguration.

Städa upp

När du är klar med att köra anteckningsboken, se till att ta bort alla resurser som du skapade under processen så att din fakturering stoppas. Använd följande kod:

Slutsats

I det här inlägget visade vi hur du kommer igång med Llama 3-modeller i SageMaker Studio. Du har nu tillgång till fyra Llama 3-grundmodeller som innehåller miljarder parametrar. Eftersom grundmodeller är förutbildade kan de också hjälpa till att sänka utbildnings- och infrastrukturkostnader och möjliggöra anpassning för ditt användningsfall. Kolla upp SageMaker JumpStart i SageMaker Studio nu för att komma igång.

Om författare

Kyle Ulrich är Applied Scientist II vid AWS

Xin Huang är Senior Applied Scientist på AWS

Qing Lan är Senior Software Developer Engineer på AWS

Haotian An är en Software Developer Engineer II på AWS

Christopher Whitten är en Software Development Engineer II på AWS

Tyler Österberg är mjukvaruutvecklingsingenjör I på AWS

Manan Shah är Software Development Manager på AWS

Jonathan Guinegagne är Senior Software Developer Engineer på AWS

Adriana Simmons är Senior Product Marketing Manager på AWS

Juni vann är Senior Product Manager på AWS

Ashish Khetan är Senior Applied Scientist på AWS

Rachna Chadha är Principal Solution Architect – AI/ML på AWS

Deepak Rupakula är en huvudsaklig GTM-specialist på AWS

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/meta-llama-3-models-are-now-available-in-amazon-sagemaker-jumpstart/