For å bekjempe spredningen av materiale om seksuelt misbruk av barn (CSAM), lovet en koalisjon av toppgenerative AI-utviklere – inkludert Google, Meta og OpenAI – å håndheve rekkverk rundt den nye teknologien.

Gruppen ble trukket sammen av to ideelle organisasjoner: barneteknologigruppen Thorn og New York-baserte All Tech is Human. Tidligere kjent som DNA Foundation, ble Thorn lansert i 2012 av skuespillerne Demi Moore og Ashton Kutcher.

Kollektivløftet ble offentliggjort tirsdag sammen med en ny Thorn-rapport talsmann for et "Safety by Design"-prinsipp i generativ AI-utvikling som ville forhindre opprettelsen av materiale om seksuelle overgrep mot barn (CSAM) gjennom hele livssyklusen til en AI-modell.

"Vi oppfordrer alle selskaper som utvikler, distribuerer, vedlikeholder og bruker generative AI-teknologier og -produkter til å forplikte seg til å ta i bruk disse Safety by Design-prinsippene og demonstrere sitt engasjement for å forhindre opprettelsen og spredningen av CSAM, AIG-CSAM og andre seksuelle handlinger for barn. misbruk og utnyttelse» Torn sa i en uttalelse.

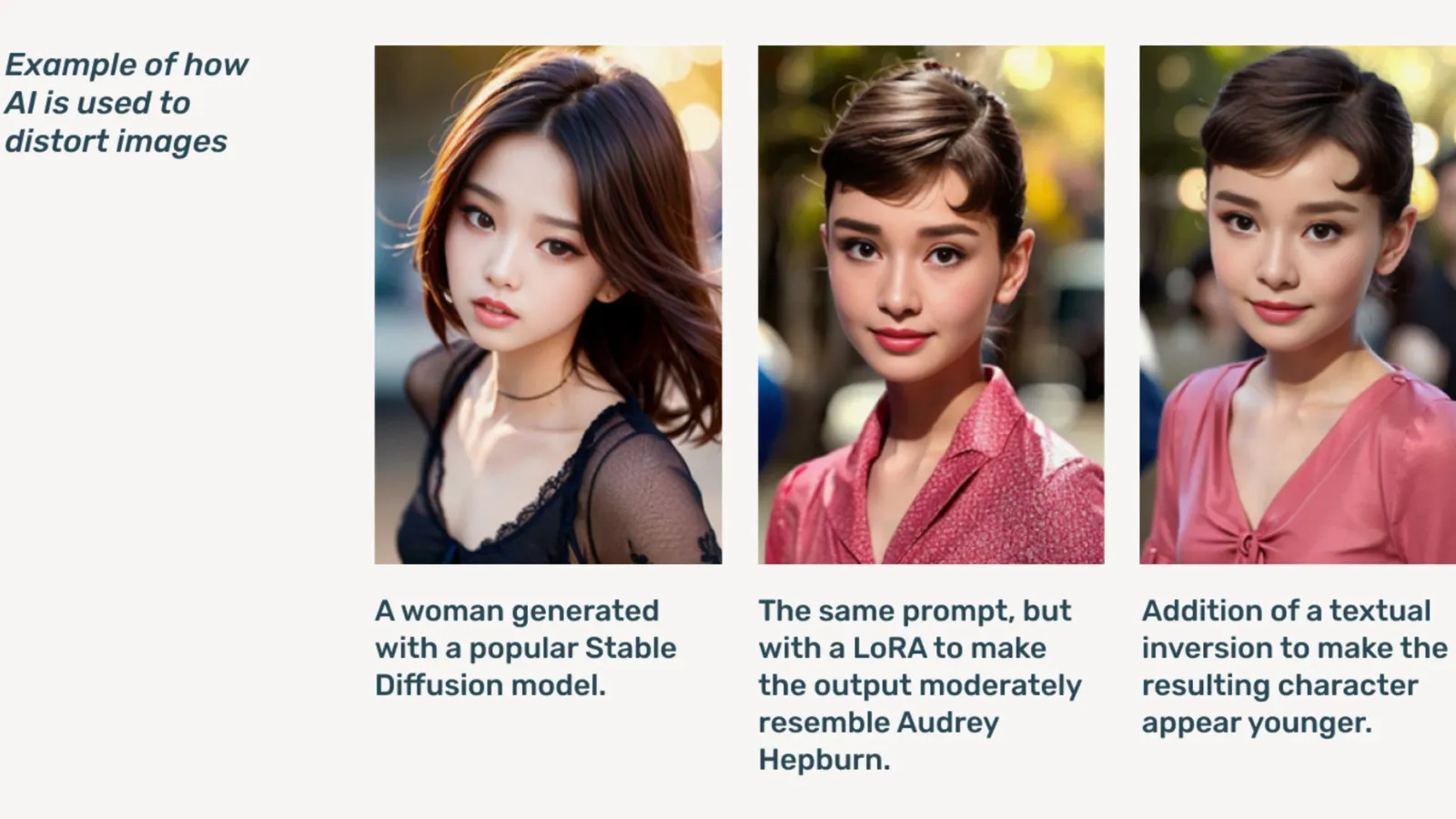

AIG-CSAM er AI-generert CSAM, som rapporten illustrerer kan være relativt enkelt å lage.

Thorn utvikler seg verktøy og ressurser fokusert på å forsvare barn mot seksuelle overgrep og utnyttelse. I sin konsekvensrapport for 2022 sa organisasjonen at det ble funnet over 824,466 104 filer som inneholder materiale om overgrep mot barn. I fjor rapporterte Thorn at mer enn XNUMX millioner filer med mistenkt CSAM ble rapportert i USA alene.

Allerede et problem på nettet, skjøt dypfalsk barnepornografi i været etter at generative AI-modeller ble offentlig tilgjengelig, med frittstående AI-modeller som ikke trenger skytjenester som ble sirkulert på mørk web fora.

Generativ AI, sa Thorn, gjør det enklere å lage mengder innhold nå enn noen gang før. Et enkelt barnerovdyr kan potensielt skape enorme mengder materiale om seksuelt misbruk av barn (CSAM), inkludert tilpasning av originale bilder og videoer til nytt innhold.

"En tilstrømning av AIG-CSAM utgjør betydelige risikoer for et allerede beskattet økosystem for barnesikkerhet, og forverrer utfordringene rettshåndhevelse står overfor med å identifisere og redde eksisterende ofre for overgrep, og skalere nye ofre for flere barn," bemerker Thorn.

Thorns rapport skisserer en rekke prinsipper de generative AI-utviklerne vil følge for å forhindre at teknologien deres blir brukt til å lage barnepornografi, inkludert opplæring i ansvarlig innkjøp datasett, inkorporerer tilbakemeldingssløyfer og stressteststrategier, bruker innholdshistorie eller «herkomst» med tanke på motstandsdyktig misbruk, og ansvarlig vert for deres respektive AI-modeller.

Andre som signerer på løftet inkluderer Microsoft, antropisk, Mistral AI, Amazon, Stabilitet AI, Civit AIog Metafysikk, hver gir ut separate uttalelser i dag.

"En del av etosen vår hos Metaphysic er ansvarlig utvikling i en AI-verden, ikke sant, det handler om å styrke, men det handler om ansvar," sa Alejandro Lopez, markedssjef i Metaphysic. dekryptere. "Vi erkjenner raskt at å starte og utvikle betyr bokstavelig talt å ivareta de mest sårbare i samfunnet vårt, som er barn, og dessverre den mørkeste enden av denne teknologien, som brukes til materiale om seksuelle overgrep mot barn i form av dyp falsk pornografi , det har skjedd."

Lansert i 2021, Metafysikk ble fremtredende i fjor etter at det ble avslørt at flere Hollywood-stjerner, inkludert Tom Hanks, Octavia Spencer og Anne Hathaway, brukte Metaphysic Pro-teknologi for å digitalisere egenskapene til deres likhet i et forsøk på å beholde eierskapet over egenskapene som er nødvendige for å trene en AI-modell .

OpenAI nektet å kommentere initiativet, i stedet for å gi dekryptere en offentlig uttalelse fra barnesikkerhetsleder Chelsea Carlson.

"Vi bryr oss sterkt om sikkerheten og ansvarlig bruk av verktøyene våre, og det er grunnen til at vi har bygget sterke rekkverk og sikkerhetstiltak i ChatGPT og DALL-E," sa Carlson i en uttalelse. "Vi er forpliktet til å jobbe sammen med Thorn, All Tech is Human og det bredere teknologisamfunnet for å opprettholde Safety by Design-prinsippene og fortsette vårt arbeid med å redusere potensiell skade på barn."

dekryptere nådde ut til andre medlemmer av koalisjonen, men hørte ikke tilbake umiddelbart.

«Hos Meta har vi brukt over et tiår på å holde folk trygge på nettet. På den tiden har vi utviklet en rekke verktøy og funksjoner for å forhindre og bekjempe potensiell skade – og ettersom rovdyr har tilpasset seg for å prøve å unngå beskyttelsen vår, har vi også fortsatt å tilpasse oss.» Meta sa i en utarbeidet uttalelse.

"På tvers av produktene våre oppdager og fjerner vi proaktivt CSAE-materiale gjennom en kombinasjon av hash-matching-teknologi, kunstig intelligens-klassifiserere og menneskelige anmeldelser," GoogleDet skrev Susan Jaspers visepresident for tillits- og sikkerhetsløsninger i et innlegg. "Våre retningslinjer og beskyttelser er designet for å oppdage alle typer CSAE, inkludert AI-generert CSAM. Når vi identifiserer utnyttende innhold, fjerner vi det og iverksetter passende tiltak, som kan inkludere rapportering til NCMEC.»

I oktober ble den britiske vakthundgruppen, den Internet Watch Foundation, advarte om at AI-generert materiale om overgrep mot barn kunne 'overvelde' internettet.

Redigert av Ryan Ozawa.

Hold deg oppdatert på kryptonyheter, få daglige oppdateringer i innboksen din.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material