Per combattere la diffusione di materiale pedopornografico (CSAM), una coalizione dei principali sviluppatori di intelligenza artificiale generativa, tra cui Google, Meta e OpenAI, ha promesso di rafforzare le barriere attorno alla tecnologia emergente.

Il gruppo è stato messo insieme da due organizzazioni no-profit: il gruppo tecnologico per bambini Thorn e All Tech is Human con sede a New York. Precedentemente nota come DNA Foundation, Thorn è stata lanciata nel 2012 dagli attori Demi Moore e Ashton Kutcher.

L'impegno collettivo è stato annunciato martedì insieme ad un nuovo impegno Rapporto Spina sostenendo un principio di “sicurezza fin dalla progettazione” nello sviluppo dell’intelligenza artificiale generativa che impedirebbe la creazione di materiale pedopornografico (CSAM) durante l’intero ciclo di vita di un modello di intelligenza artificiale.

“Esortiamo tutte le aziende che sviluppano, implementano, mantengono e utilizzano tecnologie e prodotti di intelligenza artificiale generativa a impegnarsi ad adottare questi principi Safety by Design e a dimostrare il loro impegno nel prevenire la creazione e la diffusione di materiale pedopornografico, AIG-CSAM e altri atti sessuali su minori”. abusi e sfruttamento”, spina ha detto in una dichiarazione.

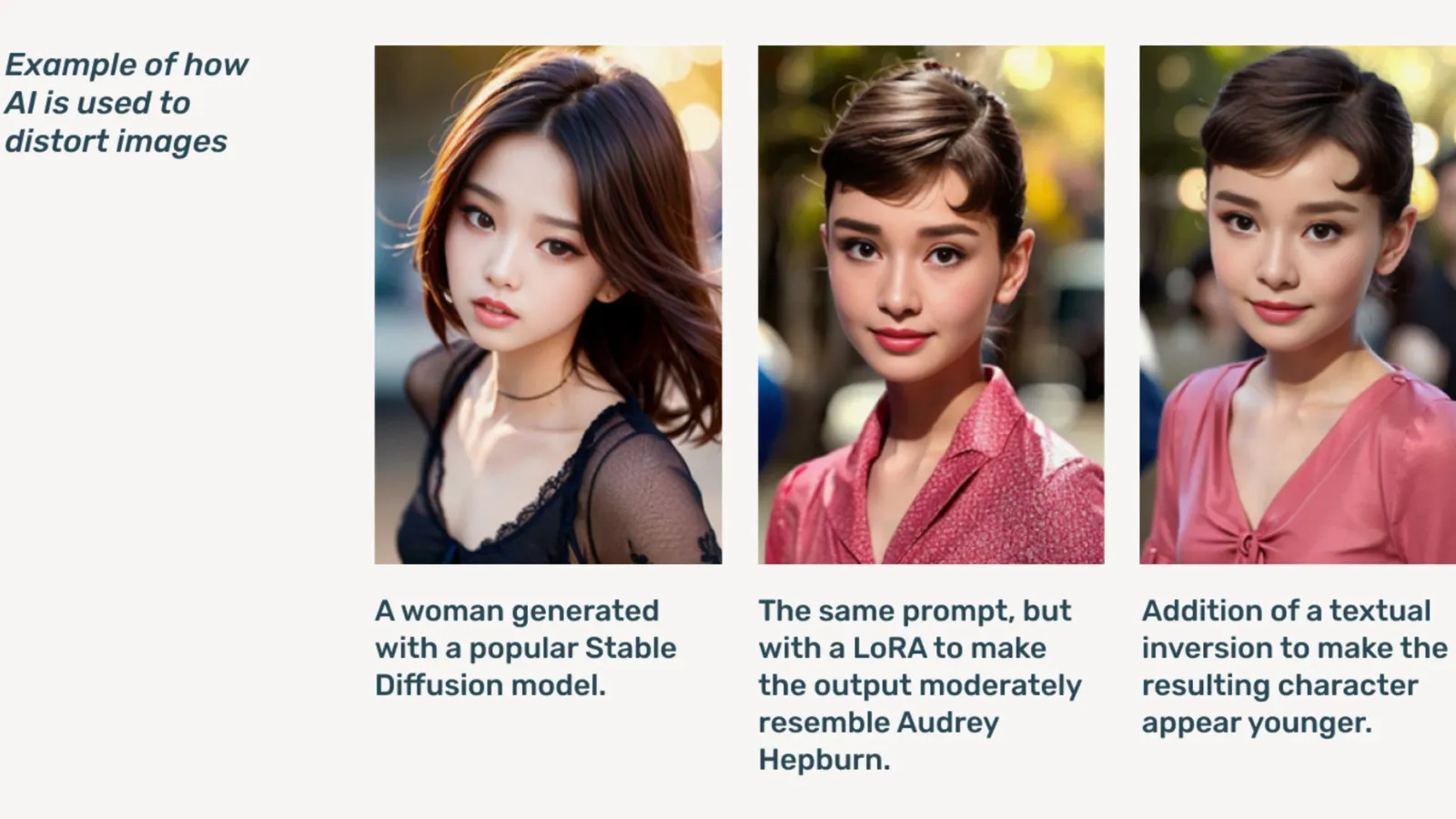

AIG-CSAM è un materiale CSAM generato dall'intelligenza artificiale e, come dimostra il rapporto, può essere relativamente facile da creare.

La spina si sviluppa strumenti e risorse incentrate sulla difesa dei bambini dall’abuso e dallo sfruttamento sessuale. Nel suo rapporto sull’impatto del 2022, l’organizzazione ha affermato che sono stati trovati oltre 824,466 file contenenti materiale pedopornografico. L'anno scorso, Thorn ha riferito che solo negli Stati Uniti sono stati segnalati più di 104 milioni di file di sospetti contenuti pedofilia.

Già un problema online, la pornografia infantile deepfake è salita alle stelle dopo che i modelli di intelligenza artificiale generativa sono diventati disponibili al pubblico, con modelli di intelligenza artificiale autonomi che non necessitano di servizi cloud diffusi su Web scuro forum.

L’intelligenza artificiale generativa, ha affermato Thorn, rende la creazione di volumi di contenuti più semplice che mai. Un singolo predatore di bambini potrebbe potenzialmente creare enormi volumi di materiale pedopornografico (CSAM), incluso l’adattamento di immagini e video originali in nuovi contenuti.

“Un afflusso di AIG-CSAM pone rischi significativi a un ecosistema di sicurezza infantile già messo a dura prova, esacerbando le sfide affrontate dalle forze dell’ordine nell’identificazione e nel salvataggio delle vittime esistenti di abusi e aumentando la nuova vittimizzazione di più bambini”, osserva Thorn.

Il rapporto di Thorn delinea una serie di principi che gli sviluppatori di IA generativa seguirebbero per impedire che la loro tecnologia venga utilizzata per creare pornografia infantile, compreso l'approvvigionamento responsabile della formazione dataset, incorporando cicli di feedback e strategie di stress test, utilizzando la cronologia dei contenuti o la "provenienza" tenendo presente l'uso improprio da parte degli avversari e ospitando responsabilmente i rispettivi modelli di intelligenza artificiale.

Altri che firmano l'impegno includono Microsoft, antropico, Maestrale AI, Amazon, Stabilità AI, IA civilee metafisica, ciascuno dei quali ha rilasciato oggi dichiarazioni separate.

"Parte della nostra etica in Metaphysic è lo sviluppo responsabile in un mondo di intelligenza artificiale, giusto, si tratta di conferire potere, ma è anche una questione di responsabilità", ha dichiarato Alejandro Lopez, responsabile marketing di Metaphysical decrypt. "Riconosciamo rapidamente che avviare e sviluppare ciò significa letteralmente salvaguardare i più vulnerabili nella nostra società, che sono i bambini, e sfortunatamente, l'estremità più oscura di questa tecnologia, che viene utilizzata per materiale pedopornografico sotto forma di pornografia profondamente falsa. , è successo”.

Lanciato nel 2021, metafisica è venuto alla ribalta l'anno scorso dopo che è stato rivelato che diverse star di Hollywood, tra cui Tom Hanks, Octavia Spencer e Anne Hathaway, stavano utilizzando la tecnologia Metaphysic Pro per digitalizzare caratteristiche a loro somiglianza nel tentativo di mantenere la proprietà sui tratti necessari per addestrare un modello di intelligenza artificiale .

OpenAI ha rifiutato di commentare ulteriormente l'iniziativa, fornendo invece decrypt una dichiarazione pubblica da parte della responsabile della sicurezza infantile Chelsea Carlson.

"Ci preoccupiamo profondamente della sicurezza e dell'uso responsabile dei nostri strumenti, motivo per cui abbiamo integrato robusti guardrail e misure di sicurezza in ChatGPT e DALL-E", ha affermato Carlson in un dichiarazione. “Ci impegniamo a lavorare a fianco di Thorn, All Tech is Human e della più ampia comunità tecnologica per sostenere i principi Safety by Design e continuare il nostro lavoro per mitigare i potenziali danni ai bambini”.

decrypt ha contattato altri membri della Coalizione ma non ha ricevuto risposta immediatamente.

“Noi di Meta lavoriamo da oltre un decennio per garantire la sicurezza delle persone online. Nel frattempo, abbiamo sviluppato numerosi strumenti e funzionalità per aiutare a prevenire e combattere potenziali danni e, man mano che i predatori si sono adattati per cercare di eludere le nostre protezioni, anche noi abbiamo continuato ad adattarci." Meta detto in una dichiarazione preparata.

"Nei nostri prodotti, rileviamo e rimuoviamo in modo proattivo il materiale CSAE attraverso una combinazione di tecnologia di corrispondenza hash, classificatori di intelligenza artificiale e revisioni umane" Googleha scritto in un post il vicepresidente di Trust and Safety Solutions, Susan Jasper. “Le nostre policy e protezioni sono progettate per rilevare tutti i tipi di CSAE, incluso il CSAM generato dall’intelligenza artificiale. Quando identifichiamo contenuti di sfruttamento, li rimuoviamo e adottiamo le azioni appropriate, che potrebbero includere la segnalazione all’NCMEC”.

Nel mese di ottobre, il gruppo di controllo del Regno Unito, the Internet Watch Foundation, ha avvertito che il materiale pedopornografico generato dall'intelligenza artificiale potrebbesopraffare' la rete.

A cura di Ryan Ozawa.

Rimani aggiornato sulle notizie crittografiche, ricevi aggiornamenti quotidiani nella tua casella di posta.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material