تیم طراحی و ساخت آمازون اتحادیه اروپا (Amazon D&C) تیم مهندسی طراحی و ساخت انبارهای آمازون است. این تیم حجم زیادی از اسناد را پیمایش میکند و اطلاعات مناسب را پیدا میکند تا مطمئن شود که طراحی انبار با بالاترین استانداردها مطابقت دارد. در پست یک راه حل مولد مبتنی بر هوش مصنوعی در Amazon SageMaker برای کمک به آمازون در طراحی و ساخت اتحادیه اروپا، ما یک راه حل ربات پاسخ به سوال با استفاده از a ارائه کردیم بازیابی نسل افزوده (RAG) خط لوله با تنظیم دقیق مدل زبان بزرگ (LLM) برای آمازون D&C برای بازیابی کارآمد اطلاعات دقیق از حجم زیادی از اسناد سازماندهی نشده و ارائه خدمات به موقع و با کیفیت بالا در پروژه های ساختمانی خود. تیم آمازون D&C این راه حل را به صورت آزمایشی برای مهندسان آمازون پیاده سازی کرد و بازخورد کاربران را جمع آوری کرد.

در این پست، نحوه تجزیه و تحلیل دادههای بازخورد و شناسایی محدودیتهای دقت و توهمات RAG را به اشتراک میگذاریم و از امتیاز ارزیابی انسانی برای آموزش مدل استفاده میکنیم. تقویت یادگیری. برای افزایش نمونه های آموزشی برای یادگیری بهتر، ما همچنین از LLM دیگری برای ایجاد امتیاز بازخورد استفاده کردیم. این روش محدودیت RAG را برطرف کرد و کیفیت پاسخ ربات را بیشتر بهبود بخشید. ما فرآیند یادگیری تقویتی و نتایج محک زدن را برای نشان دادن بهبود عملکرد LLM ارائه میکنیم. راه حل استفاده می کند Amazon SageMaker JumpStart به عنوان سرویس اصلی برای استقرار مدل، تنظیم دقیق، و یادگیری تقویتی.

جمع آوری بازخورد از مهندسان آمازون در یک پروژه آزمایشی

پس از توسعه راه حل شرح داده شده در یک راه حل مولد مبتنی بر هوش مصنوعی در Amazon SageMaker برای کمک به آمازون در طراحی و ساخت اتحادیه اروپا، تیم آمازون D&C راه حل را به کار گرفت و یک پروژه آزمایشی را با مهندسان آمازون اجرا کرد. مهندسان از طریق یک برنامه وب توسعه یافته توسط این سیستم به سیستم آزمایشی دسترسی پیدا کردند Streamlit، به خط لوله RAG متصل است. در خط لوله، ما استفاده کردیم سرویس جستجوی باز آمازون برای پایگاه داده برداری، و یک مدل Mistral-7B-Instruct دقیق تنظیم شده را در Amazon SageMaker مستقر کرد.

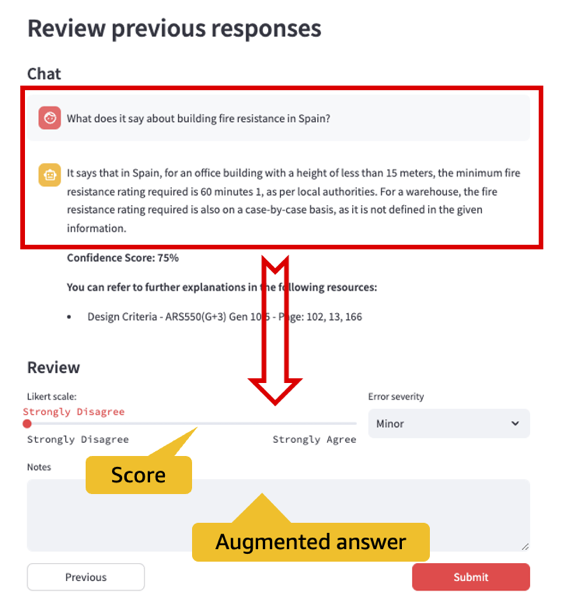

یکی از اهداف کلیدی این آزمایش جمع آوری بازخورد از مهندسان آمازون و استفاده از بازخورد برای کاهش بیشتر توهمات LLM است. برای دستیابی به این هدف، همانطور که در شکل زیر نشان داده شده است، یک ماژول جمع آوری بازخورد در رابط کاربری ایجاد کردیم و اطلاعات جلسه وب و بازخورد کاربر را در آمازون DynamoDB. از طریق رابط کاربری مجموعه بازخورد، مهندسان آمازون میتوانند از بین پنج سطح رضایت انتخاب کنند: کاملاً مخالف، مخالف، خنثی، موافق، و کاملاً موافق، که مربوط به امتیازات بازخورد از 1 تا 5 است. آنها همچنین می توانند پاسخ بهتری به این سوال یا نظر در مورد اینکه چرا پاسخ LLM رضایت بخش نیست ارائه دهند.

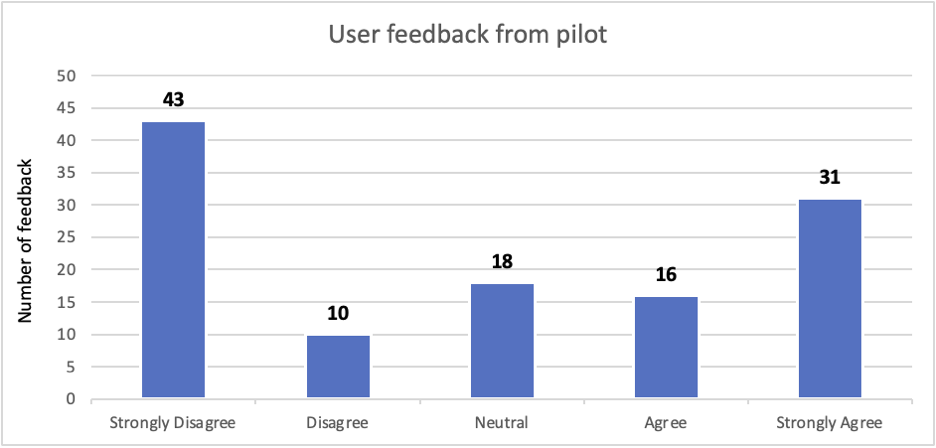

در طول آزمایش، کاربران 118 پاسخ بازخورد ارائه کردند. نمودار زیر توزیع از منفی به مثبت را نشان می دهد. مشاهده کردیم که پاسخهای نادرست که با بازخورد منفی (مخالف و کاملاً مخالف) مشخص شدهاند، 45 درصد از کل بازخوردها (53 از 118) است. برخی از خطاها (حدود 10٪ از بازخورد منفی و 7.5٪ از پاسخ های کلی) را می توان با آموزش کاربر و مهندسی سریع برطرف کرد. علاوه بر این، میتوانیم با راهحل یادگیری تقویتی و تنظیم دقیق LLM که در بخش بعدی توضیح داده شده است، به این مشکل بپردازیم.

برخی از کاربران به سادگی یادداشتی مانند "عالی!" برای پاسخهای کاملاً موافق، یا «به سؤال پاسخ نمیدهد»، برای پاسخهای کاملاً مخالف. سایر کاربران نمرات ارائه کردند و توضیح دادند که چگونه پاسخ های LLM را در یادداشت های خود توجیه می کنند. در مثال زیر، کاربر به طور خاص سند و محتوای کافی را برای تصحیح توهم LLM ارائه کرده است.

| سوال | چند جای پارک ماشین داریم؟ |

| پاسخ ربات |

بر اساس زمینه داده شده، ما اطلاعات کافی برای تعیین تعداد جای پارک خودرو نداریم. این زمینه حداقل اندازه فضاهای پارکینگ و الزامات سطوح روشنایی خارجی را مورد بحث قرار می دهد، اما تعداد مشخصی از فضاهای پارکینگ را ارائه نمی دهد. **توضیحات بیشتر را می توانید در منابع زیر رجوع کنید:** * ARS GEN 10.0/05.01.02. معیارها و ضمائم طراحی/بسته عملکرد AR قابل مرتب سازی معیارهای طراحی v20.1.1.pdf – صفحه: 10 * ARS GEN 10.0/05.01.02. معیارها و ضمائم طراحی/بسته عملکرد AR قابل مرتب سازی معیارهای طراحی v20.1.1.pdf – صفحه: 79 |

| امتیاز کاربر | کاملا مخالف |

| یادداشت های کاربر | این در صفحه 21 بخش معیارهای طراحی 01 13 10 مشخص شده است |

با تنظیم دقیق و یادگیری تقویتی، پاسخ ربات را بهبود بخشید

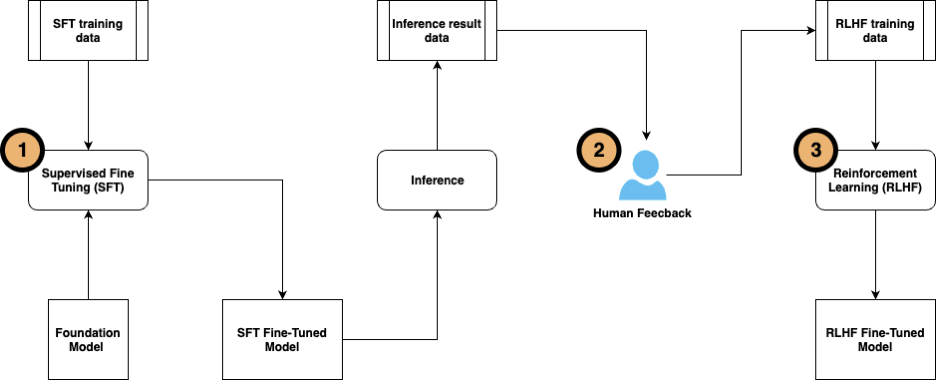

راه حل شامل سه مرحله تنظیم دقیق است:

- تنظیم دقیق نظارت شده را با استفاده از داده های برچسب دار انجام دهید. این روش در شرح داده شد یک راه حل مولد مبتنی بر هوش مصنوعی در Amazon SageMaker برای کمک به آمازون در طراحی و ساخت اتحادیه اروپا.

- بازخورد کاربر را جمعآوری کنید تا جفتهای پرسش و پاسخ را برای تنظیم بیشتر LLM برچسبگذاری کنید.

- وقتی داده های آموزشی آماده شد، مدل را با استفاده از آن بیشتر تنظیم کنید یادگیری تقویتی از بازخورد انسانی (RLHF).

RLHF به طور گسترده در سراسر برنامه های هوش مصنوعی مولد (AI) و LLM استفاده می شود. این بازخورد انسانی را در تابع پاداش ترکیب میکند و مدل را با الگوریتم یادگیری تقویتی برای به حداکثر رساندن پاداشها آموزش میدهد، که باعث میشود مدل وظایف را با اهداف انسانی هماهنگتر انجام دهد. نمودار زیر خط لوله مراحل را نشان می دهد.

ما این روش را با استفاده از اسناد D&C آمازون با مدل Mistral-7B در SageMaker JumpStart آزمایش کردیم.

نظارت بر تنظیم دقیق

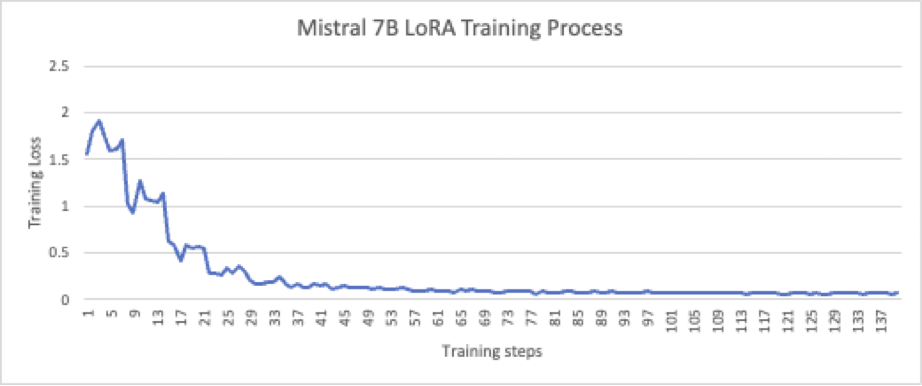

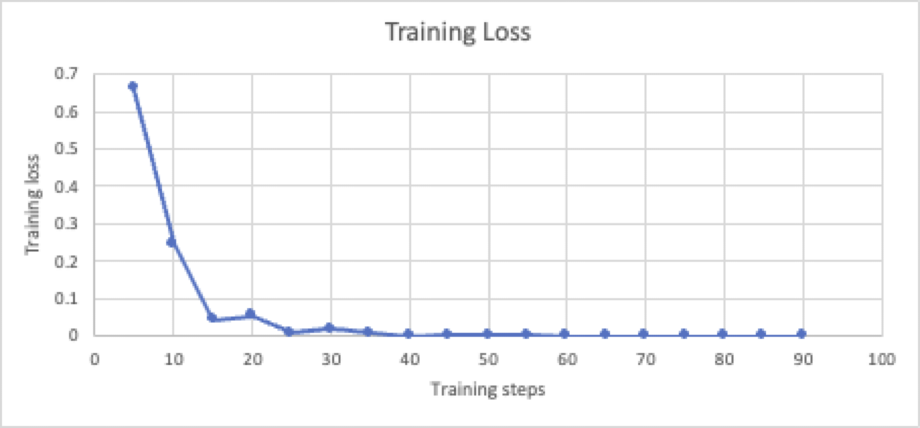

در پست قبلی، نشان دادیم که چگونه مدل Falcon-7B تنظیم شده بهتر از خط لوله RAG عمل می کند و کیفیت و دقت پاسخ ربات QA را بهبود می بخشد. برای این پست، ما تنظیمات دقیق نظارت شده را در مدل Mistral-7B انجام دادیم. تنظیم دقیق نظارت شده از تکنیک PEFT/LoRA (LoRA_r = 512، LoRA_alpha = 1024) روی 436,207,616 پارامتر (5.68٪ از کل 7,677,964,288 پارامتر) استفاده کرد. آموزش بر روی یک گره p3.8x با 137 نمونه که به طور مصنوعی توسط LLM تولید شده و توسط انسان تایید شده است، انجام شد. همانطور که در شکل زیر نشان داده شده است، این فرآیند پس از 20 دوره به خوبی همگرا شده است.

مدل دقیق تنظیم شده توسط 274 نمونه تایید شد و نتایج استنتاج با پاسخ های مرجع با نمره شباهت معنایی مقایسه شد. امتیاز 0.8100 است که بالاتر از امتیاز 0.6419 از RAG سنتی است.

بازخورد انسان و هوش مصنوعی را برای یادگیری تقویتی جمع آوری کنید

برای RLHF، مقدار کافی از نمونه های آموزشی با کیفیت بالا که توسط کارشناسان موضوع (SMEs) برچسب گذاری شده اند ضروری است. با این حال، برچسبهای انسانی با کیفیت پایین احتمالاً باعث عملکرد بدتر مدل نسبت به مدل اصلی پس از آموزش RLHF میشوند. زمان SME ها است یک منبع کمیاب در هر سازمانی; بررسی صدها یا هزاران پاسخ LLM و ارائه بازخورد نیاز به سرمایه گذاری زمانی قابل توجهی از سوی SMEها دارد که ممکن است بازگشت سرمایه مشخصی نداشته باشند.

برای رسیدگی به این چالش، ما را پذیرفتیم یادگیری تقویتی از بازخورد هوش مصنوعی روش (RLAIF) RLAIF از یک دستیار هوش مصنوعی (LLM دیگر) برای ارائه نمرات ارزیابی استفاده می کند، نه از انسان. در این رویکرد یادگیری ترکیبی، عامل یادگیری اقدامات را نه تنها بر اساس تعامل با یک انسان، بلکه از بازخورد ارائه شده توسط یک مدل هوش مصنوعی دیگر نیز اصلاح می کند. ارائه داده های آموزشی کافی برای یادگیری تقویتی بسیار مقیاس پذیرتر است و بسیار کمتر ذهنی است زیرا آموزش به ترجیحات خاص گروه کوچکی از SME ها وابسته نیست. ممکن است SMEها همچنان درگیر باشند، اما فقط برای نظارت بر فرآیند و بررسی کیفیت بازخورد هوش مصنوعی. این امر حجم کار SME ها را به شدت کاهش می دهد، زیرا امتیازات و برچسب های ایجاد شده توسط هوش مصنوعی برای تجزیه و تحلیل، فیلتر کردن و مرتب سازی برای SME ها بسیار پیچیده تر است.

در این مورد، ما دستور زیر را به مدل Anthropic Claude 2 ارائه می کنیم تا امتیازات ارزیابی را به عنوان نمونه های آموزشی برای مرحله یادگیری تقویتی ایجاد کنیم:

همانطور که در مثال زیر نشان داده شده است، مدل Claude 2 یک امتیاز ارزیابی و یک نظر در مورد چرایی امتیاز دادن ایجاد می کند.

| سوال | منظور از «تطبیق کارها» در این زمینه چیست؟ |

| پاسخ مرجع | Fit Out Works به کارهایی اطلاق میشود که تحت قرارداد ساخت و ساز توسط یا از طرف آمازون از طریق توسعهدهنده تا تاریخ دریافت اول از یک موقعیت ساخت پایه Developer Shell & Core انجام میشوند. این آثار شامل فیتآوتهای مورد نیاز آمازون، نصبهای جعبه بزرگ و سفارشی است |

| پاسخ ربات QA | Fit Out Works به کارهایی اطلاق میشود که تحت قرارداد ساخت و ساز توسط یا از طرف آمازون از طریق توسعهدهنده تا تاریخ دریافت اول از یک موقعیت ساخت پایه Developer Shell & Core انجام میشوند. |

| امتیاز هوش مصنوعی | 4.5 |

| نظر هوش مصنوعی | پاسخ ماشینی اطلاعات کلیدی را از پاسخ استاندارد ارائه می دهد - که Fit Out Works به کارهایی اطلاق می شود که تحت قرارداد ساخت و ساز توسط آمازون یا از طرف آمازون از طریق توسعه دهنده تا تاریخ دریافت اول از یک موقعیت ساخت پایه Developer Shell & Core انجام شده است. . جزئیات اضافی در مورد از جمله موارد مورد نیاز آمازون، نصبهای جعبه بزرگ و سفارشیسازیها مرتبط هستند و به ارائه زمینههای بیشتر کمک میکنند، بنابراین من به پاسخ دستگاه امتیاز 4.5 از 5 را دادهام. این پاسخ ماهیت پاسخ استاندارد را نشان میدهد و مقداری را ارائه میکند. جزئیات اضافی مفید |

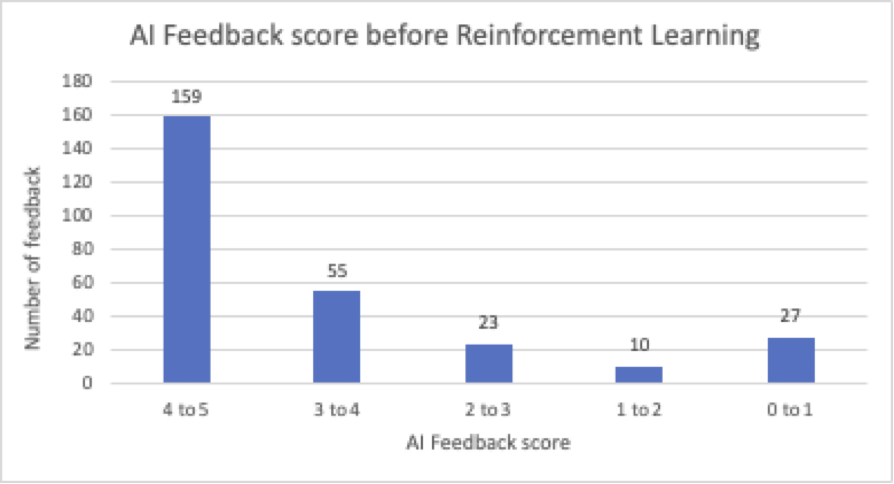

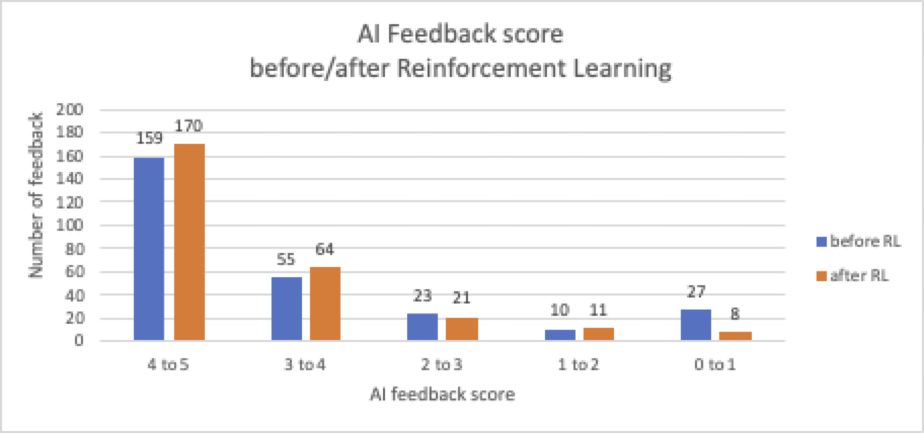

از 274 سؤال اعتبارسنجی، مدل تنظیم دقیق نظارت شده 159 پاسخ ایجاد کرد که نمرات هوش مصنوعی بالاتر از 4 داشتند. ما 60 پاسخ را با امتیازات کمتر از 3 مشاهده کردیم. فضایی برای بهبود کیفیت کلی پاسخ وجود دارد.

شرکتهای کوچک و متوسط مهندسی آمازون این بازخورد هوش مصنوعی را تأیید کردند و مزایای استفاده از امتیازات هوش مصنوعی را تأیید کردند. بدون بازخورد هوش مصنوعی، SMEها برای بررسی و تجزیه و تحلیل هر پاسخ LLM برای شناسایی پاسخهای قطعی و توهمات و قضاوت در مورد اینکه آیا LLM مطالب و مفاهیم کلیدی صحیح را برمیگرداند، به زمان نیاز دارند. بازخورد هوش مصنوعی امتیازات هوش مصنوعی را به صورت خودکار ارائه میکند و به SMEها امکان میدهد از فیلتر کردن، مرتبسازی و گروهبندی برای اعتبارسنجی امتیازات و شناسایی روندها در پاسخها استفاده کنند. این امر میانگین زمان بررسی SME ها را 80 درصد کاهش می دهد.

تقویت یادگیری از بازخورد انسان و هوش مصنوعی

وقتی نمونه های آموزشی آماده شد، از آن استفاده می کنیم الگوریتم بهینه سازی سیاست پروگزیمال (PPO). برای انجام یادگیری تقویتی PPO از یک روش گرادیان خط مشی استفاده می کند که گام های کوچکی برای به روز رسانی خط مشی در فرآیند یادگیری برمی دارد، به طوری که عوامل یادگیری می توانند به طور قابل اعتماد به شبکه خط مشی بهینه برسند. این باعث می شود روند تمرین پایدارتر شود و احتمال واگرایی کاهش یابد.

در طول آموزش، ابتدا از دادههای برچسبگذاری شده با انسان و هوش مصنوعی برای ساختن یک مدل پاداش استفاده میکنیم، که از آن برای بهروزرسانی وزنها در فرآیند یادگیری استفاده میشود. برای این مورد استفاده، ما یک مدل پاداش مبتنی بر دیستیلروبرتا را انتخاب میکنیم و آن را با نمونههایی در قالب زیر آموزش میدهیم:

[Instruction, Chosen_response, Rejected_response]

در زیر نمونه ای از کارنامه آموزشی آورده شده است.

| دستور العمل | با توجه به زمینه، چه چیزی برای طراحی فراگیر و در دسترس مشخص شده است؟ |

| انتخاب_پاسخ | BREEAM Credit HEA06 – طراحی فراگیر و در دسترس – ساختمان به گونه ای طراحی شده است که برای هدف مناسب، مناسب و قابل دسترس برای همه کاربران بالقوه باشد. یک استراتژی دسترسی در راستای چک لیست BREEAM A3 ایجاد شده است |

| Rejected_response | متن بیان می کند که |

مدل پاداش با نرخ یادگیری 1e-5 آموزش داده شده است. همانطور که در نمودار زیر نشان داده شده است، پس از 10 دوره به خوبی تمرین همگرا می شود.

سپس از مدل پاداش برای یادگیری تقویتی استفاده می شود. برای این مورد، ما از PEFT/LoRA برای تسریع یادگیری استفاده می کنیم. LoRA_r 32 و LoRA_alpha 64 است. یادگیری مبتنی بر PPO در نرخ 1.41e-5 در سه دوره است. آموزش تقویتی بسیار فرار است و به داده های برچسب و داده های بازخورد بسیار حساس است. ما از متریک reward_mean، میانگین پاداش به دست آمده از محیط با نظارت خاص بر مدل پاداش، برای مشاهده فرآیند یادگیری استفاده می کنیم.

پس از RLAIF، میتوان شاهد افزایش تعداد پاسخهای ربات با امتیاز مثبت (بالای 3) از 78.1% به 85.5% و آنهایی که دارای امتیاز منفی (زیر 3) از 21.9% به 14.5% کاهش یافت. در مجموع، میانگین امتیاز بازخورد هوش مصنوعی تا 8٪ افزایش می یابد، از 3.9 به 4.2.

در مثال زیر می توانید بهبود را مشاهده کنید.

| سوال | برای کاشی کاری سطوح کف، چه کفی مورد نیاز است؟ |

| ارجاع | کفپوش بتنی اسکرید فقط در قسمت های کاشی کاری شده قابل اجرا است. به نقشه سری A-32 مراجعه کنید تا ببینید کاشی های کف کجا قابل اجرا هستند. |

| پاسخ ربات قبل از RLAIF | کفپوش بتنی Screed فقط در داخل قابل اجرا می باشد |

| امتیاز هوش مصنوعی قبل از RLAIF | 3 |

| پاسخ ربات بعد از RLAIF | کفپوش بتنی اسکرید فقط در مناطقی که کاشی کاری می شود قابل اجرا است. به نقشه سری A-32 مراجعه کنید تا ببینید کجا کفپوش کاشی قابل اجرا است. |

| امتیاز هوش مصنوعی بعد از RLAIF | 4.5 |

نتیجه

این پست ادامه کار ما با تیم طراحی و ساخت آمازون اتحادیه اروپا است همانطور که در آن بحث شد یک راه حل مولد مبتنی بر هوش مصنوعی در Amazon SageMaker برای کمک به آمازون در طراحی و ساخت اتحادیه اروپا. در این پست، ما نشان دادیم که چگونه دادههای بازخورد انسانی و هوش مصنوعی را برای تنظیم دقیق مدل Mistral-7B با یادگیری تقویتی تولید میکنیم. مدل پس از RLAIF عملکرد بهتری را برای ربات پاسخگویی به سؤالات مهندسی آمازون ارائه کرد و امتیاز بازخورد هوش مصنوعی را 8٪ بهبود بخشید. در پروژه آزمایشی تیم آمازون D&C، استفاده از RLAIF حجم کار اعتبارسنجی برای SME ها را تا حدود 80 درصد کاهش داد. به عنوان گام بعدی، ما این راه حل را با اتصال به زیرساخت داده های Amazon Engineering افزایش می دهیم و چارچوبی را برای خودکارسازی فرآیند یادگیری مداوم با یک انسان در حلقه طراحی می کنیم. همچنین کیفیت بازخورد هوش مصنوعی را با تنظیم الگوی سریع بهبود خواهیم داد.

از طریق این فرآیند، ما یاد گرفتیم که چگونه کیفیت و عملکرد وظایف پاسخگویی به سؤال را از طریق RLHF و RLAIF بهبود دهیم.

- اعتبار سنجی و تقویت انسانی برای ارائه خروجی های دقیق و مسئولانه از LLM ضروری است. بازخورد انسانی را می توان در RLHF برای بهبود بیشتر پاسخ مدل استفاده کرد.

- RLAIF چرخه ارزیابی و یادگیری را خودکار می کند. بازخورد تولید شده توسط هوش مصنوعی کمتر ذهنی است زیرا به ترجیح خاصی از مجموعه کوچکی از SME ها بستگی ندارد.

- RLAIF برای بهبود کیفیت ربات از طریق یادگیری تقویتی مستمر و در عین حال به حداقل رساندن تلاش های مورد نیاز از SMEها مقیاس پذیرتر است. به ویژه برای توسعه راه حل های هوش مصنوعی مولد دامنه خاص در سازمان های بزرگ مفید است.

- این فرآیند باید به طور منظم انجام شود، به خصوص زمانی که داده های دامنه جدید در دسترس هستند تا توسط راه حل پوشش داده شوند.

در این مورد، ما از SageMaker JumpStart برای آزمایش چندین LLM و آزمایش با چندین رویکرد آموزشی LLM استفاده کردیم. به طور قابل توجهی چرخه بازخورد و یادگیری هوش مصنوعی را با حداکثر کارایی و کیفیت تسریع می کند. برای پروژه خود، میتوانید رویکرد انسان در حلقه را برای جمعآوری بازخورد کاربران خود معرفی کنید، یا با استفاده از LLM دیگری بازخورد هوش مصنوعی ایجاد کنید. سپس می توانید فرآیند سه مرحله ای تعریف شده در این پست را برای تنظیم دقیق مدل های خود با استفاده از RLHF و RLAIF دنبال کنید. توصیه میکنیم روشهایی را با استفاده از SageMaker JumpStart برای سرعت بخشیدن به فرآیند آزمایش کنید.

درباره نویسنده

یونفی بای یک معمار ارشد راه حل در AWS است. Yunfei با سابقه ای در AI/ML، علم داده و تجزیه و تحلیل، به مشتریان کمک می کند تا خدمات AWS را برای ارائه نتایج تجاری اتخاذ کنند. او راه حل های AI/ML و تجزیه و تحلیل داده را طراحی می کند که بر چالش های فنی پیچیده غلبه کرده و اهداف استراتژیک را هدایت می کند. یونفی دارای مدرک دکترای مهندسی الکترونیک و برق است. خارج از کار، یونفی از خواندن و موسیقی لذت می برد.

یونفی بای یک معمار ارشد راه حل در AWS است. Yunfei با سابقه ای در AI/ML، علم داده و تجزیه و تحلیل، به مشتریان کمک می کند تا خدمات AWS را برای ارائه نتایج تجاری اتخاذ کنند. او راه حل های AI/ML و تجزیه و تحلیل داده را طراحی می کند که بر چالش های فنی پیچیده غلبه کرده و اهداف استراتژیک را هدایت می کند. یونفی دارای مدرک دکترای مهندسی الکترونیک و برق است. خارج از کار، یونفی از خواندن و موسیقی لذت می برد.

الاد دوک مدیر فناوری ساخت و ساز در آمازون است. الاد با سابقه ای در ساخت و ساز و مدیریت پروژه، به تیم ها کمک می کند تا فناوری های جدید و فرآیندهای مبتنی بر داده را برای ارائه پروژه های ساختمانی اتخاذ کنند. او نیازها و راه حل ها را شناسایی می کند و توسعه ویژگی های سفارشی را تسهیل می کند. الاد دارای مدرک MBA و لیسانس مهندسی سازه است. الاد خارج از محل کار، از یوگا، نجاری و مسافرت با خانواده لذت می برد.

الاد دوک مدیر فناوری ساخت و ساز در آمازون است. الاد با سابقه ای در ساخت و ساز و مدیریت پروژه، به تیم ها کمک می کند تا فناوری های جدید و فرآیندهای مبتنی بر داده را برای ارائه پروژه های ساختمانی اتخاذ کنند. او نیازها و راه حل ها را شناسایی می کند و توسعه ویژگی های سفارشی را تسهیل می کند. الاد دارای مدرک MBA و لیسانس مهندسی سازه است. الاد خارج از محل کار، از یوگا، نجاری و مسافرت با خانواده لذت می برد.

لوکا سرابون یک مهندس هوش تجاری در آمازون است. Luca crafts با اقتباس از پیشینه خود در علم داده و تجزیه و تحلیل، راه حل های فنی را برای رفع نیازهای منحصر به فرد مشتریان خود طراحی کرد و آنها را به سمت فرآیندهای پایدارتر و مقیاس پذیرتر سوق داد. لوکا با داشتن مدرک کارشناسی ارشد در علوم داده، از شرکت در پروژه های DIY، باغبانی و تجربه لذت های آشپزی در لحظات فراغت خود لذت می برد.

لوکا سرابون یک مهندس هوش تجاری در آمازون است. Luca crafts با اقتباس از پیشینه خود در علم داده و تجزیه و تحلیل، راه حل های فنی را برای رفع نیازهای منحصر به فرد مشتریان خود طراحی کرد و آنها را به سمت فرآیندهای پایدارتر و مقیاس پذیرتر سوق داد. لوکا با داشتن مدرک کارشناسی ارشد در علوم داده، از شرکت در پروژه های DIY، باغبانی و تجربه لذت های آشپزی در لحظات فراغت خود لذت می برد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/improve-llm-performance-with-human-and-ai-feedback-on-amazon-sagemaker-for-amazon-engineering/