Η ομάδα σχεδίασης και κατασκευής της Amazon EU (Amazon D&C) είναι η ομάδα μηχανικών που σχεδιάζει και κατασκευάζει αποθήκες της Amazon. Η ομάδα πλοηγείται σε μεγάλο όγκο εγγράφων και εντοπίζει τις σωστές πληροφορίες για να βεβαιωθεί ότι ο σχεδιασμός της αποθήκης πληροί τα υψηλότερα πρότυπα. Στο ταχυδρομείο Μια παραγωγική λύση με τεχνητή νοημοσύνη στο Amazon SageMaker για να βοηθήσει την Amazon EU Design and Construction, παρουσιάσαμε μια λύση ρομπότ απάντησης ερώτησης χρησιμοποιώντας α Ανάκτηση επαυξημένης γενιάς (RAG) αγωγός με τελειοποιημένο μεγάλο γλωσσικό μοντέλο (LLM) για την Amazon D&C να ανακτά αποτελεσματικά ακριβείς πληροφορίες από μεγάλο όγκο μη οργανωμένων εγγράφων και να παρέχει έγκαιρες και υψηλής ποιότητας υπηρεσίες στα κατασκευαστικά της έργα. Η ομάδα D&C της Amazon εφάρμοσε τη λύση σε πιλοτικό πρόγραμμα για μηχανικούς της Amazon και συνέλεξε σχόλια από τους χρήστες.

Σε αυτήν την ανάρτηση, μοιραζόμαστε τον τρόπο με τον οποίο αναλύσαμε τα δεδομένα ανατροφοδότησης και εντοπίσαμε περιορισμούς ακρίβειας και παραισθήσεων που παρείχε η RAG και χρησιμοποιήσαμε τη βαθμολογία ανθρώπινης αξιολόγησης για να εκπαιδεύσουμε το μοντέλο ενίσχυση μάθησης. Για να αυξήσουμε τα δείγματα εκπαίδευσης για καλύτερη μάθηση, χρησιμοποιήσαμε επίσης ένα άλλο LLM για να δημιουργήσουμε βαθμολογίες ανατροφοδότησης. Αυτή η μέθοδος αντιμετώπισε τον περιορισμό RAG και βελτίωσε περαιτέρω την ποιότητα απόκρισης του bot. Παρουσιάζουμε τη διαδικασία ενισχυτικής μάθησης και τα αποτελέσματα συγκριτικής αξιολόγησης για να δείξουμε τη βελτίωση της απόδοσης του LLM. Η λύση χρησιμοποιεί Amazon SageMaker JumpStart ως βασική υπηρεσία για την ανάπτυξη μοντέλων, τη λεπτομερή ρύθμιση και την ενίσχυση της εκμάθησης.

Συλλέξτε σχόλια από μηχανικούς της Amazon σε ένα πιλοτικό έργο

Μετά την ανάπτυξη της λύσης που περιγράφεται στο Μια παραγωγική λύση με τεχνητή νοημοσύνη στο Amazon SageMaker για να βοηθήσει την Amazon EU Design and Construction, η ομάδα D&C της Amazon ανέπτυξε τη λύση και έτρεξε ένα πιλοτικό έργο με μηχανικούς της Amazon. Οι μηχανικοί είχαν πρόσβαση στο πιλοτικό σύστημα μέσω μιας διαδικτυακής εφαρμογής που αναπτύχθηκε από Ροή, που συνδέεται με τον αγωγό RAG. Στα σκαριά, χρησιμοποιήσαμε Amazon OpenSearch Service για τη διανυσματική βάση δεδομένων και ανέπτυξε ένα βελτιστοποιημένο μοντέλο Mistral-7B-Instruct στο Amazon SageMaker.

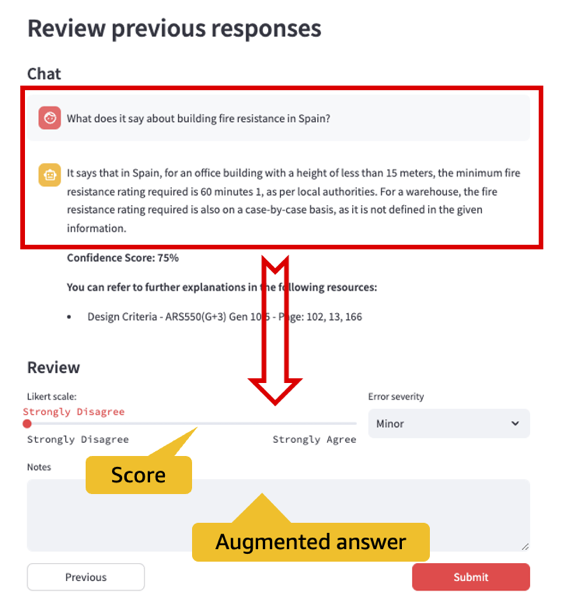

Ένας από τους βασικούς στόχους του πιλότου είναι να συλλέξει σχόλια από μηχανικούς της Amazon και να χρησιμοποιήσει τα σχόλια για να μειώσει περαιτέρω τις παραισθήσεις LLM. Για να το επιτύχουμε αυτό, αναπτύξαμε μια ενότητα συλλογής σχολίων στη διεπαφή χρήστη, όπως φαίνεται στην παρακάτω εικόνα, και αποθηκεύσαμε τις πληροφορίες περιόδου σύνδεσης ιστού και τα σχόλια των χρηστών στο Amazon DynamoDB. Μέσω της διεπαφής χρήστη συλλογής σχολίων, οι μηχανικοί της Amazon μπορούν να επιλέξουν από πέντε επίπεδα ικανοποίησης: διαφωνώ έντονα, διαφωνώ, ουδέτερο, συμφωνώ και συμφωνώ απόλυτα, που αντιστοιχούν στις βαθμολογίες σχολίων από 1–5. Μπορούν επίσης να δώσουν μια καλύτερη απάντηση στην ερώτηση ή να σχολιάσουν γιατί η απάντηση LLM δεν είναι ικανοποιητική.

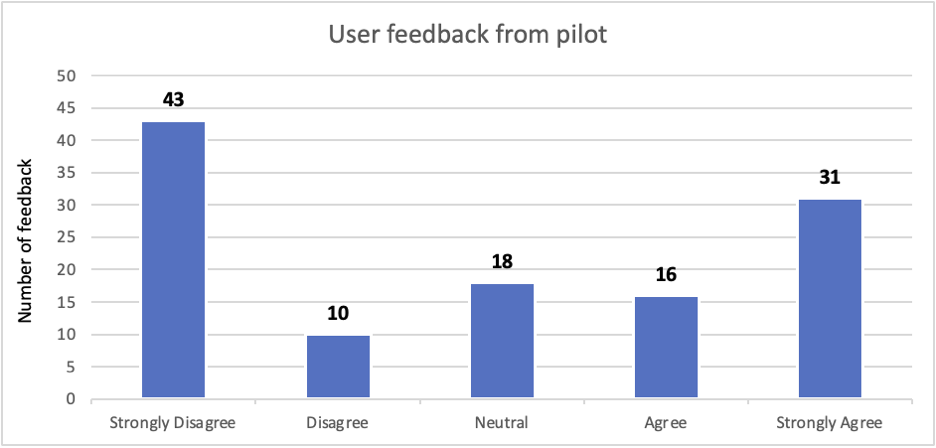

Κατά τη διάρκεια του πιλοτικού προγράμματος, οι χρήστες παρείχαν 118 απαντήσεις ανατροφοδότησης. Το παρακάτω διάγραμμα δείχνει την κατανομή από αρνητική σε θετική. Παρατηρήσαμε ότι οι λανθασμένες απαντήσεις που χαρακτηρίζονται από τα αρνητικά σχόλια (διαφωνώ και διαφωνώ έντονα) είναι 45% μεταξύ των συνολικών σχολίων (53 από 118). Μερικά από τα σφάλματα (περίπου 10% των αρνητικών σχολίων και 7.5% των συνολικών απαντήσεων) μπορούν να αντιμετωπιστούν από την εκπαίδευση των χρηστών και την άμεση τεχνική υποστήριξη. Επιπλέον, μπορούμε να αντιμετωπίσουμε το πρόβλημα με τη λύση της τελειοποίησης και της ενίσχυσης εκμάθησης LLM, που περιγράφεται στην επόμενη ενότητα.

Ορισμένοι χρήστες απλώς άφησαν μια σημείωση, όπως "Τέλεια!" για τις απαντήσεις που συμφωνώ απόλυτα ή "Δεν απαντά στην ερώτηση", για τις απαντήσεις που διαφωνούν έντονα. Άλλοι χρήστες έδωσαν βαθμολογίες και εξήγησαν πώς δικαιολογούν τις απαντήσεις LLM στις σημειώσεις τους. Στο ακόλουθο παράδειγμα, ο χρήστης παρείχε συγκεκριμένα το κατάλληλο έγγραφο και περιεχόμενο για τη διόρθωση της ψευδαίσθησης LLM.

| Ερώτηση | Πόσες θέσεις στάθμευσης αυτοκινήτων έχουμε; |

| Απάντηση Bot |

Με βάση το δεδομένο πλαίσιο, δεν έχουμε αρκετές πληροφορίες για να προσδιορίσουμε τον αριθμό των θέσεων στάθμευσης αυτοκινήτων. Το πλαίσιο συζητά το ελάχιστο μέγεθος των χώρων στάθμευσης και τις απαιτήσεις για τα επίπεδα εξωτερικού φωτισμού, αλλά δεν παρέχει συγκεκριμένο αριθμό θέσεων στάθμευσης. **Μπορείτε να ανατρέξετε σε περαιτέρω εξηγήσεις στις ακόλουθες πηγές:** * ARS GEN 10.0/05.01.02. Κριτήρια σχεδίασης και παραρτήματα/Πακέτο απόδοσης Κριτήρια σχεδίασης AR με δυνατότητα ταξινόμησης v20.1.1.pdf – σελίδα: 10 * ARS GEN 10.0/05.01.02. Κριτήρια σχεδίασης και παραρτήματα/Πακέτο απόδοσης Κριτήρια σχεδίασης AR με δυνατότητα ταξινόμησης v20.1.1.pdf – σελίδα: 79 |

| Βαθμολογία χρήστη | Διαφωνώ έντονα |

| Σημειώσεις χρήστη | Αυτό καθορίζεται στη σελίδα 21 της ενότητας κριτηρίων σχεδίασης 01 13 10 |

Βελτιώστε την απόκριση του bot με εποπτευόμενη λεπτομέρεια και ενισχυτική μάθηση

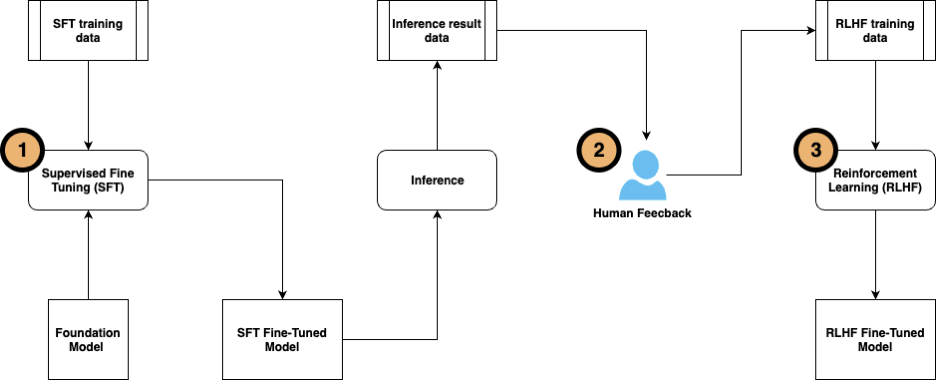

Η λύση αποτελείται από τρία βήματα λεπτομέρειας:

- Πραγματοποιήστε εποπτευόμενη μικρορύθμιση χρησιμοποιώντας δεδομένα με ετικέτα. Αυτή η μέθοδος περιγράφηκε στο Μια παραγωγική λύση με τεχνητή νοημοσύνη στο Amazon SageMaker για να βοηθήσει την Amazon EU Design and Construction.

- Συλλέξτε σχόλια χρηστών για να επισημάνετε τα ζεύγη ερωτήσεων-απαντήσεων για περαιτέρω συντονισμό LLM.

- Όταν τα δεδομένα εκπαίδευσης είναι έτοιμα, συντονίστε περαιτέρω το μοντέλο χρησιμοποιώντας ενίσχυση της μάθησης από την ανθρώπινη ανατροφοδότηση (RLHF).

Το RLHF χρησιμοποιείται ευρέως σε εφαρμογές γενετικής τεχνητής νοημοσύνης (AI) και LLM. Ενσωματώνει την ανθρώπινη ανατροφοδότηση στη λειτουργία ανταμοιβών και εκπαιδεύει το μοντέλο με έναν αλγόριθμο ενίσχυσης μάθησης για τη μεγιστοποίηση των ανταμοιβών, γεγονός που κάνει το μοντέλο να εκτελεί εργασίες πιο ευθυγραμμισμένες με τους ανθρώπινους στόχους. Το παρακάτω διάγραμμα δείχνει τη διοχέτευση των βημάτων.

Δοκιμάσαμε τη μεθοδολογία χρησιμοποιώντας τα έγγραφα Amazon D&C με ένα μοντέλο Mistral-7B στο SageMaker JumpStart.

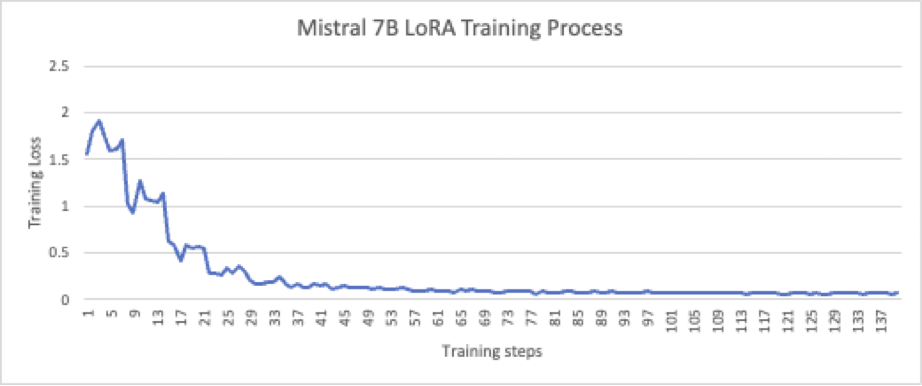

Εποπτευόμενη μικρορύθμιση

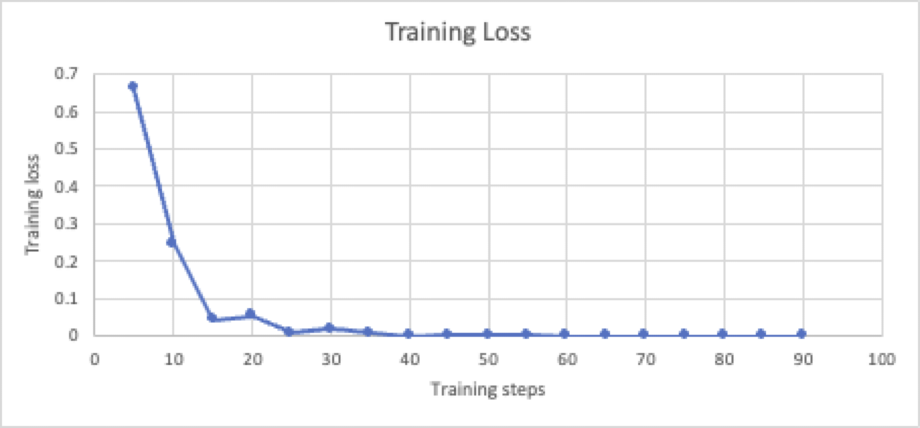

Στην προηγούμενη ανάρτηση, δείξαμε πώς το βελτιστοποιημένο μοντέλο Falcon-7B ξεπερνά τις επιδόσεις του αγωγού RAG και βελτιώνει την ποιότητα και την ακρίβεια της απόκρισης bot QA. Για αυτήν την ανάρτηση, πραγματοποιήσαμε εποπτευόμενη λεπτομέρεια στο μοντέλο Mistral-7B. Η εποπτευόμενη ρύθμιση χρησιμοποίησε την τεχνική PEFT/LoRA (LoRA_r = 512, LoRA_alpha = 1024) σε 436,207,616 παραμέτρους (5.68% του συνόλου των 7,677,964,288 παραμέτρων). Η εκπαίδευση διεξήχθη σε έναν κόμβο p3.8x με 137 δείγματα που δημιουργήθηκαν συνθετικά από το LLM και επικυρώθηκαν από ανθρώπους. η διαδικασία συγκλίνει καλά μετά από 20 εποχές, όπως φαίνεται στο παρακάτω σχήμα.

Το τελειοποιημένο μοντέλο επικυρώθηκε από 274 δείγματα και τα αποτελέσματα συμπερασμάτων συγκρίθηκαν με τις απαντήσεις αναφοράς με τη βαθμολογία σημασιολογικής ομοιότητας. Το σκορ είναι 0.8100, το οποίο είναι υψηλότερο από το σκορ 0.6419 από το παραδοσιακό RAG.

Συλλέξτε ανατροφοδότηση ανθρώπου και τεχνητής νοημοσύνης για ενισχυτική μάθηση

Για το RLHF, είναι απαραίτητο να υπάρχει επαρκής ποσότητα δειγμάτων εκπαίδευσης υψηλής ποιότητας με επισήμανση από ειδικούς στο αντικείμενο (ΜΜΕ). Ωστόσο, οι ανθρώπινες ετικέτες κακής ποιότητας πιθανότατα θα προκαλέσουν χειρότερη απόδοση του μοντέλου από το αρχικό μοντέλο μετά την εκπαίδευση RLHF. Ο χρόνος των ΜΜΕ είναι ένας σπάνιος πόρος σε κάθε οργανισμό; Η εξέταση εκατοντάδων ή χιλιάδων απαντήσεων LLM και η παροχή σχολίων απαιτεί σημαντική επένδυση χρόνου από ΜΜΕ που μπορεί να μην έχουν σαφή απόδοση επένδυσης.

Για να αντιμετωπίσουμε αυτήν την πρόκληση, υιοθετήσαμε το ενισχυτική μάθηση από την ανατροφοδότηση AI μέθοδος (RLAIF). Η RLAIF απασχολεί έναν βοηθό τεχνητής νοημοσύνης (άλλο LLM) για να παρέχει βαθμολογίες αξιολόγησης και όχι από ανθρώπους. Σε αυτήν την υβριδική προσέγγιση μάθησης, ο εκπαιδευτικός πράκτορας βελτιώνει τις ενέργειες όχι μόνο με βάση την αλληλεπίδραση με έναν άνθρωπο αλλά και από την ανατροφοδότηση που παρέχεται από ένα άλλο μοντέλο τεχνητής νοημοσύνης. Είναι πολύ πιο επεκτάσιμο να παρέχονται επαρκή δεδομένα κατάρτισης για ενισχυτική μάθηση και πολύ λιγότερο υποκειμενικό επειδή η κατάρτιση δεν εξαρτάται από ιδιαίτερες προτιμήσεις μιας μικρής ομάδας ΜΜΕ. Οι ΜΜΕ ενδέχεται να εξακολουθούν να συμμετέχουν, αλλά μόνο για την επίβλεψη της διαδικασίας και την εξέταση της ποιότητας ανατροφοδότησης AI. Αυτό μειώνει τρομερά τον φόρτο εργασίας των ΜΜΕ, επειδή οι βαθμολογίες και οι ετικέτες που δημιουργούνται από την τεχνητή νοημοσύνη είναι πολύ λιγότερο περίπλοκες για τις ΜΜΕ να αναλύουν, να φιλτράρουν και να ταξινομούν.

Σε αυτήν την περίπτωση χρήσης, παρέχουμε την ακόλουθη προτροπή σε ένα μοντέλο Anthropic Claude 2 για τη δημιουργία των βαθμολογιών αξιολόγησης ως δείγματα εκπαίδευσης για το βήμα ενίσχυσης μάθησης:

Το μοντέλο Claude 2 δημιουργεί μια βαθμολογία αξιολόγησης και ένα σχόλιο σχετικά με το γιατί δίνεται η βαθμολογία, όπως φαίνεται στο ακόλουθο παράδειγμα.

| Ερώτηση | Τι σημαίνει «Fit Out Works» σε αυτό το πλαίσιο; |

| Αναφορά Απάντηση | Το Fit Out Works αναφέρεται σε Εργασίες που εκτελούνται στο πλαίσιο της σύμβασης κατασκευής από ή για λογαριασμό της Amazon μέσω του Προγραμματιστή έως την Ημερομηνία Πρώτης Παραλαβής από μια πλασματική θέση κατασκευής Developer Shell & Core Base. Αυτά τα Έργα περιλαμβάνουν τα απαιτούμενα Fit-Outs της Amazon, εγκαταστάσεις μεγάλων κουτιών και προσαρμοσμένες |

| Απάντηση QA Bot | Το Fit Out Works αναφέρεται σε Εργασίες που εκτελούνται στο πλαίσιο της σύμβασης κατασκευής από ή για λογαριασμό της Amazon μέσω του Προγραμματιστή έως την Ημερομηνία Πρώτης Παραλαβής από μια πλασματική θέση κατασκευής Developer Shell & Core Base. |

| βαθμολογία AI | 4.5 |

| Σχόλιο AI | Η απάντηση του μηχανήματος παρέχει τις βασικές πληροφορίες από την τυπική απάντηση - ότι το Fit Out Works αναφέρεται σε Εργασίες που εκτελούνται στο πλαίσιο της σύμβασης κατασκευής από ή για λογαριασμό της Amazon μέσω του Προγραμματιστή έως την Ημερομηνία Πρώτης Παραλαβής από μια πλασματική θέση κατασκευής της Shell & Core για προγραμματιστές . Οι πρόσθετες λεπτομέρειες σχετικά με τη συμπερίληψη των απαιτούμενων Fit-Outs, εγκαταστάσεων μεγάλου κουτιού και προσαρμογών της Amazon είναι σχετικές και βοηθούν στην παροχή περαιτέρω πλαισίου, επομένως βαθμολόγησα την απάντηση του μηχανήματος με 4.5 στα 5. Καταγράφει την ουσία της τυπικής απάντησης και παρέχει ορισμένες χρήσιμες επιπλέον λεπτομέρειες. |

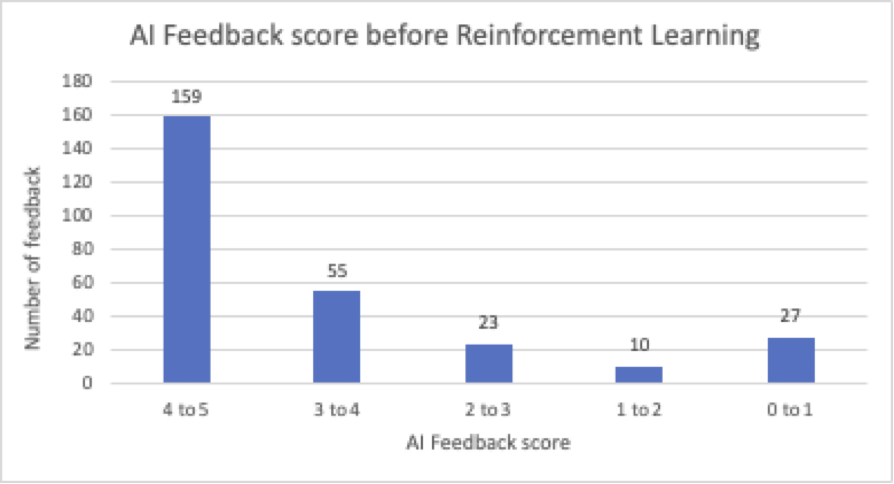

Από τις 274 ερωτήσεις επικύρωσης, το εποπτευόμενο μοντέλο δημιούργησε 159 απαντήσεις που έχουν βαθμολογίες τεχνητής νοημοσύνης μεγαλύτερες από 4. Παρατηρήσαμε 60 απαντήσεις με βαθμολογίες χαμηλότερες από 3. υπάρχει χώρος για βελτίωση της συνολικής ποιότητας απόκρισης.

Οι ΜΜΕ της Amazon Engineering επικύρωσαν αυτή την ανατροφοδότηση τεχνητής νοημοσύνης και αναγνώρισαν τα οφέλη από τη χρήση βαθμολογιών τεχνητής νοημοσύνης. Χωρίς ανατροφοδότηση τεχνητής νοημοσύνης, οι ΜΜΕ θα χρειάζονταν λίγο χρόνο για να επανεξετάσουν και να αναλύσουν κάθε απόκριση LLM για να εντοπίσουν τις τελικές απαντήσεις και τις ψευδαισθήσεις και να κρίνουν εάν το LLM επιστρέφει σωστά περιεχόμενα και βασικές έννοιες. Η ανατροφοδότηση τεχνητής νοημοσύνης παρέχει αυτόματα βαθμολογίες τεχνητής νοημοσύνης και δίνει τη δυνατότητα στις ΜΜΕ να χρησιμοποιούν φιλτράρισμα, ταξινόμηση και ομαδοποίηση για να επικυρώσουν τις βαθμολογίες και να προσδιορίσουν τις τάσεις στις απαντήσεις. Αυτό μειώνει τον μέσο χρόνο επανεξέτασης των ΜΜΕ κατά 80%.

Ενίσχυση της μάθησης από την ανατροφοδότηση ανθρώπων και τεχνητής νοημοσύνης

Όταν τα δείγματα εκπαίδευσης είναι έτοιμα, χρησιμοποιούμε το αλγόριθμος εγγύς βελτιστοποίησης πολιτικής (PPO). για την εκτέλεση ενισχυτικής μάθησης. Το PPO χρησιμοποιεί μια μέθοδο διαβάθμισης πολιτικής, η οποία κάνει μικρά βήματα για την ενημέρωση της πολιτικής στη διαδικασία εκμάθησης, έτσι ώστε οι εκπαιδευτικοί πράκτορες να μπορούν να φτάσουν αξιόπιστα στο βέλτιστο δίκτυο πολιτικής. Αυτό κάνει τη διαδικασία προπόνησης πιο σταθερή και μειώνει την πιθανότητα απόκλισης.

Κατά τη διάρκεια της εκπαίδευσης, πρώτα χρησιμοποιούμε τα δεδομένα με ετικέτα ανθρώπου και τεχνητής νοημοσύνης για να δημιουργήσουμε ένα μοντέλο ανταμοιβής, το οποίο θα χρησιμοποιηθεί ως οδηγός για την ενημέρωση βαρών στη διαδικασία εκμάθησης. Για αυτήν την περίπτωση χρήσης, επιλέγουμε ένα μοντέλο ανταμοιβής με βάση το distilroberta και το εκπαιδεύουμε με δείγματα στην ακόλουθη μορφή:

[Instruction, Chosen_response, Rejected_response]

Το παρακάτω είναι ένα παράδειγμα αρχείου προπόνησης.

| Εντολή | Σύμφωνα με το πλαίσιο, τι καθορίζεται για συμπεριληπτικό και προσβάσιμο σχεδιασμό; |

| Chosen_response | BREEAM Credit HEA06 – σχεδιασμός χωρίς αποκλεισμούς και προσβάσιμος – Το κτίριο έχει σχεδιαστεί για να είναι κατάλληλο για τον σκοπό του, κατάλληλο και προσβάσιμο από όλους τους πιθανούς χρήστες. Αναπτύσσεται στρατηγική πρόσβασης σύμφωνα με τη λίστα ελέγχου BREEAM A3 |

| Rejected_response | Το πλαίσιο αναφέρει ότι |

Το μοντέλο ανταμοιβής εκπαιδεύεται με το ποσοστό μάθησης 1e-5. Όπως φαίνεται στο παρακάτω διάγραμμα, η προπόνηση συγκλίνει μετά από 10 εποχές.

Στη συνέχεια, το μοντέλο ανταμοιβής χρησιμοποιείται για την ενισχυτική μάθηση. Για αυτήν την περίπτωση χρήσης, χρησιμοποιούμε PEFT/LoRA για να επιταχύνουμε τη μάθηση. Το LoRA_r είναι 32 και το LoRA_alpha είναι 64. Η μάθηση που βασίζεται στο PPO είναι σε ρυθμό 1.41e-5 σε τρεις εποχές. Η εκπαίδευση ενίσχυσης είναι εξαιρετικά ασταθής και πολύ ευαίσθητη στα δεδομένα της ετικέτας και στα δεδομένα ανατροφοδότησης. Χρησιμοποιούμε τη μέτρηση reward_mean, τη μέση ανταμοιβή που λαμβάνεται από το περιβάλλον παρακολουθώντας συγκεκριμένα το μοντέλο ανταμοιβής, για να παρατηρήσουμε τη διαδικασία μάθησης.

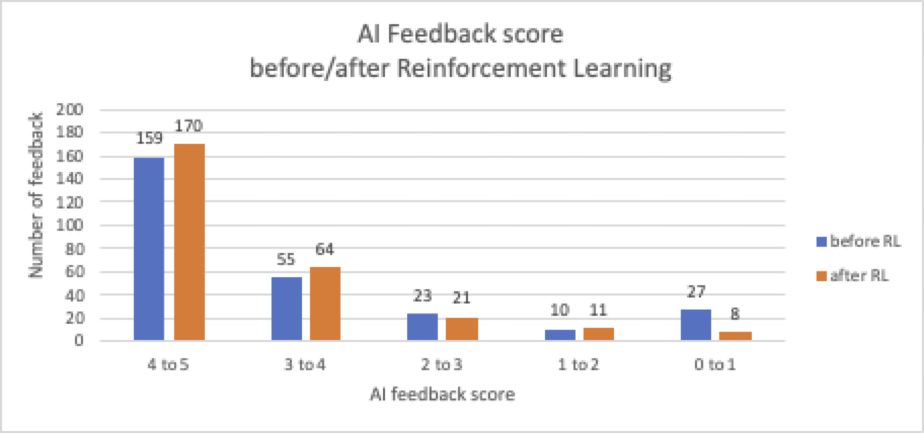

Μετά το RLAIF, μπορούμε να δούμε τον αριθμό των απαντήσεων bot με θετικές βαθμολογίες (πάνω από 3) να αυξάνεται από 78.1% σε 85.5%, και αυτές με αρνητικές βαθμολογίες (κάτω από 3) να μειώνονται από 21.9% σε 14.5%. Συνολικά, η μέση βαθμολογία ανατροφοδότησης AI αυξάνεται έως και 8%, από 3.9 σε 4.2.

Μπορείτε να δείτε τη βελτίωση στο παρακάτω παράδειγμα.

| Ερώτηση | Για τις επιφάνειες δαπέδου με πλακάκια, τι τσιμεντοκονία χρειάζεται; |

| Αναφορά | Το δάπεδο από σκυρόδεμα εφαρμόζεται μόνο σε χώρους με πλακάκια δαπέδου. Ανατρέξτε στη σειρά σχεδίων A-32 για να δείτε πού ισχύουν τα πλακάκια δαπέδου. |

| Απόκριση bot πριν από το RLAIF | Το δάπεδο από σκυρόδεμα εφαρμόζεται μόνο σε |

| Βαθμολογία AI πριν από το RLAIF | 3 |

| Απόκριση bot μετά το RLAIF | Το δάπεδο από σκυρόδεμα εφαρμόζεται μόνο σε χώρους με πλακάκια. Ανατρέξτε στη σειρά σχεδίων A-32 για να δείτε πού εφαρμόζεται το δάπεδο με πλακάκια. |

| Σκορ AI μετά το RLAIF | 4.5 |

Συμπέρασμα

Αυτή η ανάρτηση αποτελεί συνέχεια της δουλειάς μας με την ομάδα Σχεδιασμού και Κατασκευής της Amazon EU όπως συζητήθηκε στο Μια παραγωγική λύση με τεχνητή νοημοσύνη στο Amazon SageMaker για να βοηθήσει την Amazon EU Design and Construction. Σε αυτήν την ανάρτηση, δείξαμε πώς δημιουργήσαμε δεδομένα ανατροφοδότησης ανθρώπου και τεχνητής νοημοσύνης για να τελειοποιήσουμε το μοντέλο Mistral-7B με ενισχυτική μάθηση. Το μοντέλο μετά το RLAIF παρείχε καλύτερη απόδοση για το bot απάντησης ερωτήσεων της Amazon Engineering, βελτίωσε τη βαθμολογία ανατροφοδότησης AI κατά 8%. Στο πιλοτικό έργο της ομάδας D&C της Amazon, η χρήση του RLAIF μείωσε τον φόρτο εργασίας επικύρωσης για τις ΜΜΕ κατά 80%. Ως επόμενο βήμα, θα κλιμακώσουμε αυτήν τη λύση συνδέοντας με την υποδομή δεδομένων της Amazon Engineering και θα σχεδιάσουμε ένα πλαίσιο για την αυτοματοποίηση της συνεχούς διαδικασίας μάθησης με έναν άνθρωπο στο βρόχο. Θα βελτιώσουμε επίσης περαιτέρω την ποιότητα των σχολίων AI συντονίζοντας το πρότυπο προτροπής.

Μέσω αυτής της διαδικασίας, μάθαμε πώς να βελτιώσουμε περαιτέρω την ποιότητα και την απόδοση των εργασιών απάντησης ερωτήσεων μέσω του RLHF και του RLAIF.

- Η ανθρώπινη επικύρωση και η αύξηση είναι ουσιαστικής σημασίας για την παροχή ακριβών και υπεύθυνων αποτελεσμάτων από το LLM. Η ανθρώπινη ανάδραση μπορεί να χρησιμοποιηθεί στο RLHF για περαιτέρω βελτίωση της απόκρισης του μοντέλου.

- Το RLAIF αυτοματοποιεί τον κύκλο αξιολόγησης και μάθησης. Η ανατροφοδότηση που δημιουργείται από την τεχνητή νοημοσύνη είναι λιγότερο υποκειμενική επειδή δεν εξαρτάται από μια συγκεκριμένη προτίμηση από μια μικρή ομάδα ΜΜΕ.

- Το RLAIF είναι πιο επεκτάσιμο για τη βελτίωση της ποιότητας του bot μέσω της συνεχούς ενισχυτικής μάθησης, ελαχιστοποιώντας παράλληλα τις προσπάθειες που απαιτούνται από τις ΜΜΕ. Είναι ιδιαίτερα χρήσιμο για την ανάπτυξη γενετικών λύσεων τεχνητής νοημοσύνης για συγκεκριμένο τομέα σε μεγάλους οργανισμούς.

- Αυτή η διαδικασία θα πρέπει να γίνεται σε τακτική βάση, ειδικά όταν είναι διαθέσιμα νέα δεδομένα τομέα που θα καλυφθούν από τη λύση.

Σε αυτήν την περίπτωση χρήσης, χρησιμοποιήσαμε το SageMaker JumpStart για να δοκιμάσουμε πολλά LLM και να πειραματιστούμε με πολλαπλές προσεγγίσεις εκπαίδευσης LLM. Επιταχύνει σημαντικά τον κύκλο ανατροφοδότησης και μάθησης AI με μεγιστοποιημένη απόδοση και ποιότητα. Για το δικό σας έργο, μπορείτε να εισαγάγετε την προσέγγιση του ανθρώπου στον βρόχο για να συλλέξετε τα σχόλια των χρηστών σας ή να δημιουργήσετε σχόλια AI χρησιμοποιώντας άλλο LLM. Στη συνέχεια, μπορείτε να ακολουθήσετε τη διαδικασία τριών βημάτων που ορίζεται σε αυτήν την ανάρτηση για να ρυθμίσετε τα μοντέλα σας χρησιμοποιώντας RLHF και RLAIF. Συνιστούμε να πειραματιστείτε με τις μεθόδους χρησιμοποιώντας το SageMaker JumpStart για να επιταχύνετε τη διαδικασία.

Σχετικά με το Συγγραφέας

Γιουνφέι Μπάι είναι Senior Solutions Architect στην AWS. Με υπόβαθρο στην AI/ML, την επιστήμη δεδομένων και την ανάλυση, η Yunfei βοηθά τους πελάτες να υιοθετήσουν υπηρεσίες AWS για να προσφέρουν επιχειρηματικά αποτελέσματα. Σχεδιάζει λύσεις AI/ML και ανάλυσης δεδομένων που ξεπερνούν περίπλοκες τεχνικές προκλήσεις και οδηγούν στρατηγικούς στόχους. Ο Yunfei έχει διδακτορικό στην Ηλεκτρονική και Ηλεκτρολογία. Εκτός δουλειάς, ο Γιουνφέι απολαμβάνει το διάβασμα και τη μουσική.

Γιουνφέι Μπάι είναι Senior Solutions Architect στην AWS. Με υπόβαθρο στην AI/ML, την επιστήμη δεδομένων και την ανάλυση, η Yunfei βοηθά τους πελάτες να υιοθετήσουν υπηρεσίες AWS για να προσφέρουν επιχειρηματικά αποτελέσματα. Σχεδιάζει λύσεις AI/ML και ανάλυσης δεδομένων που ξεπερνούν περίπλοκες τεχνικές προκλήσεις και οδηγούν στρατηγικούς στόχους. Ο Yunfei έχει διδακτορικό στην Ηλεκτρονική και Ηλεκτρολογία. Εκτός δουλειάς, ο Γιουνφέι απολαμβάνει το διάβασμα και τη μουσική.

Έλαντ Ντουέκ είναι Διευθυντής Τεχνολογίας Κατασκευών στην Amazon. Με υπόβαθρο στην κατασκευή και τη διαχείριση έργων, η Elad βοηθά τις ομάδες να υιοθετήσουν νέες τεχνολογίες και διαδικασίες που βασίζονται σε δεδομένα για την υλοποίηση κατασκευαστικών έργων. Εντοπίζει ανάγκες και λύσεις και διευκολύνει την ανάπτυξη των κατά παραγγελία χαρακτηριστικών. Ο Elad έχει MBA και BSc στη Δομική Μηχανική. Εκτός δουλειάς, ο Elad του αρέσει η γιόγκα, η ξυλουργική και τα ταξίδια με την οικογένειά του.

Έλαντ Ντουέκ είναι Διευθυντής Τεχνολογίας Κατασκευών στην Amazon. Με υπόβαθρο στην κατασκευή και τη διαχείριση έργων, η Elad βοηθά τις ομάδες να υιοθετήσουν νέες τεχνολογίες και διαδικασίες που βασίζονται σε δεδομένα για την υλοποίηση κατασκευαστικών έργων. Εντοπίζει ανάγκες και λύσεις και διευκολύνει την ανάπτυξη των κατά παραγγελία χαρακτηριστικών. Ο Elad έχει MBA και BSc στη Δομική Μηχανική. Εκτός δουλειάς, ο Elad του αρέσει η γιόγκα, η ξυλουργική και τα ταξίδια με την οικογένειά του.

Λούκα Κεραμπόν είναι Μηχανικός Business Intelligence στην Amazon. Αντλώντας από το υπόβαθρό του στην επιστήμη δεδομένων και την ανάλυση, ο Luca προσάρμοσε τεχνικές λύσεις για να καλύψει τις μοναδικές ανάγκες των πελατών του, οδηγώντας τους σε πιο βιώσιμες και επεκτάσιμες διαδικασίες. Οπλισμένος με MSc στην Επιστήμη των Δεδομένων, ο Luca απολαμβάνει να ασχολείται με έργα DIY, να ασχολείται με την κηπουρική και να πειραματίζεται με γαστρονομικές απολαύσεις στις στιγμές αναψυχής του.

Λούκα Κεραμπόν είναι Μηχανικός Business Intelligence στην Amazon. Αντλώντας από το υπόβαθρό του στην επιστήμη δεδομένων και την ανάλυση, ο Luca προσάρμοσε τεχνικές λύσεις για να καλύψει τις μοναδικές ανάγκες των πελατών του, οδηγώντας τους σε πιο βιώσιμες και επεκτάσιμες διαδικασίες. Οπλισμένος με MSc στην Επιστήμη των Δεδομένων, ο Luca απολαμβάνει να ασχολείται με έργα DIY, να ασχολείται με την κηπουρική και να πειραματίζεται με γαστρονομικές απολαύσεις στις στιγμές αναψυχής του.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/improve-llm-performance-with-human-and-ai-feedback-on-amazon-sagemaker-for-amazon-engineering/