Αυτή η ανάρτηση γράφτηκε από κοινού με τον Anthony Medeiros, Διευθυντή Μηχανικής και Αρχιτεκτονικής Λύσεων για την Τεχνητή Νοημοσύνη της Βόρειας Αμερικής και τον Blake Santschi, Διευθυντή Business Intelligence, από τη Schneider Electric. Επιπλέον ειδικοί της Schneider Electric περιλαμβάνουν τους Jesse Miller, Somik Chowdhury, Shaswat Babhulgaonkar, David Watkins, Mark Carlson και Barbara Sleczkowski.

Τα συστήματα Enterprise Resource Planning (ERP) χρησιμοποιούνται από εταιρείες για τη διαχείριση πολλών επιχειρηματικών λειτουργιών όπως η λογιστική, οι πωλήσεις ή η διαχείριση παραγγελιών σε ένα σύστημα. Συγκεκριμένα, χρησιμοποιούνται συνήθως για την αποθήκευση πληροφοριών που σχετίζονται με λογαριασμούς πελατών. Διαφορετικοί οργανισμοί μέσα σε μια εταιρεία ενδέχεται να χρησιμοποιούν διαφορετικά συστήματα ERP και η συγχώνευσή τους είναι μια πολύπλοκη τεχνική πρόκληση σε κλίμακα που απαιτεί γνώσεις σε συγκεκριμένο τομέα.

Η Schneider Electric είναι πρωτοπόρος στον ψηφιακό μετασχηματισμό της διαχείρισης ενέργειας και του βιομηχανικού αυτοματισμού. Για την καλύτερη εξυπηρέτηση των αναγκών των πελατών της, η Schneider Electric πρέπει να παρακολουθεί τις συνδέσεις μεταξύ των λογαριασμών των σχετικών πελατών στα συστήματα ERP της. Καθώς η πελατειακή βάση τους αυξάνεται, καθημερινά προστίθενται νέοι πελάτες και οι ομάδες λογαριασμών τους πρέπει να ταξινομούν με μη αυτόματο τρόπο αυτούς τους νέους πελάτες και να τους συνδέσουν με την κατάλληλη μητρική οντότητα.

Η απόφαση σύνδεσης βασίζεται στις πιο πρόσφατες πληροφορίες που είναι διαθέσιμες δημόσια στο Διαδίκτυο ή στα μέσα ενημέρωσης και ενδέχεται να επηρεαστεί από πρόσφατες εξαγορές, νέα της αγοράς ή αναδιάρθρωση τμημάτων. Ένα παράδειγμα σύνδεσης λογαριασμών θα ήταν ο προσδιορισμός της σχέσης μεταξύ της Amazon και της θυγατρικής της, Whole Foods Market [πηγή].

Η Schneider Electric αναπτύσσει μεγάλα γλωσσικά μοντέλα για τις δυνατότητές τους να απαντούν σε ερωτήσεις σε διάφορους τομείς της γνώσης, η ημερομηνία που εκπαιδεύτηκε το μοντέλο περιορίζει τις γνώσεις του. Αντιμετώπισαν αυτήν την πρόκληση χρησιμοποιώντας ένα μοντέλο ανοιχτού κώδικα μεγάλης γλώσσας Retriever-Augmented Generation που διατίθεται στο Amazon SageMaker JumpStart να επεξεργάζεται μεγάλες ποσότητες εξωτερικής γνώσης που αντλείται και να παρουσιάζει εταιρικές ή δημόσιες σχέσεις μεταξύ των αρχείων ERP.

Στις αρχές του 2023, όταν η Schneider Electric αποφάσισε να αυτοματοποιήσει μέρος της διαδικασίας σύνδεσης λογαριασμών της χρησιμοποιώντας τεχνητή νοημοσύνη (AI), η εταιρεία συνεργάστηκε με το Εργαστήριο Λύσεων Μηχανικής Μάθησης AWS (MLSL). Με την τεχνογνωσία της MLSL στη συμβουλευτική και εκτέλεση ML, η Schneider Electric μπόρεσε να αναπτύξει μια αρχιτεκτονική τεχνητής νοημοσύνης που θα μείωνε τη μη αυτόματη προσπάθεια στις ροές εργασιών σύνδεσης και θα παρείχε ταχύτερη πρόσβαση δεδομένων στις μεταγενέστερες ομάδες ανάλυσης.

Παραγωγική τεχνητή νοημοσύνη

Το Generative AI και τα μεγάλα γλωσσικά μοντέλα (LLM) μεταμορφώνουν τον τρόπο με τον οποίο οι επιχειρηματικές οργανώσεις είναι σε θέση να επιλύουν παραδοσιακά πολύπλοκες προκλήσεις που σχετίζονται με την επεξεργασία και την κατανόηση της φυσικής γλώσσας. Μερικά από τα πλεονεκτήματα που προσφέρουν τα LLM περιλαμβάνουν τη δυνατότητα κατανόησης μεγάλων τμημάτων κειμένου και απάντησης σε σχετικές ερωτήσεις παράγοντας απαντήσεις που μοιάζουν με τον άνθρωπο. Το AWS διευκολύνει τους πελάτες να πειραματιστούν και να παράγουν φόρτους εργασίας LLM, καθιστώντας διαθέσιμες πολλές επιλογές μέσω του Amazon SageMaker JumpStart, Θεμέλιο του Αμαζονίου, να Amazon Titan.

Εξωτερική Απόκτηση Γνώσης

Τα LLM είναι γνωστά για την ικανότητά τους να συμπιέζουν την ανθρώπινη γνώση και έχουν επιδείξει αξιοσημείωτες ικανότητες στην απάντηση ερωτήσεων σε διάφορους τομείς της γνώσης, αλλά οι γνώσεις τους περιορίζονται από την ημερομηνία εκπαίδευσης του μοντέλου. Αντιμετωπίζουμε αυτό το όριο πληροφοριών συνδέοντας το LLM με ένα API Αναζήτησης Google για να παραδώσουμε ένα ισχυρό Επαυξημένο LLM ανάκτησης (RAG) που αντιμετωπίζει τις προκλήσεις της Schneider Electric. Το RAG είναι σε θέση να επεξεργάζεται μεγάλες ποσότητες εξωτερικής γνώσης που αντλείται από την αναζήτηση Google και να παρουσιάζει εταιρικές ή δημόσιες σχέσεις μεταξύ των εγγραφών ERP.

Δείτε το παρακάτω παράδειγμα:

Ερώτηση: Ποια είναι η μητρική εταιρεία της One Medical;

Ερώτημα Google: «Μητρική εταιρεία One Medical» → πληροφορίες → LLM

Απάντηση: One Medical, θυγατρική της Amazon…

Το προηγούμενο παράδειγμα (λαμβανόμενο από τη βάση δεδομένων πελατών της Schneider Electric) αφορά μια εξαγορά που συνέβη τον Φεβρουάριο του 2023 και, επομένως, δεν θα μπορούσε να εντοπιστεί μόνο από το LLM λόγω περιορισμών στη γνώση. Η ενίσχυση του LLM με την αναζήτηση Google εγγυάται τις πιο ενημερωμένες πληροφορίες.

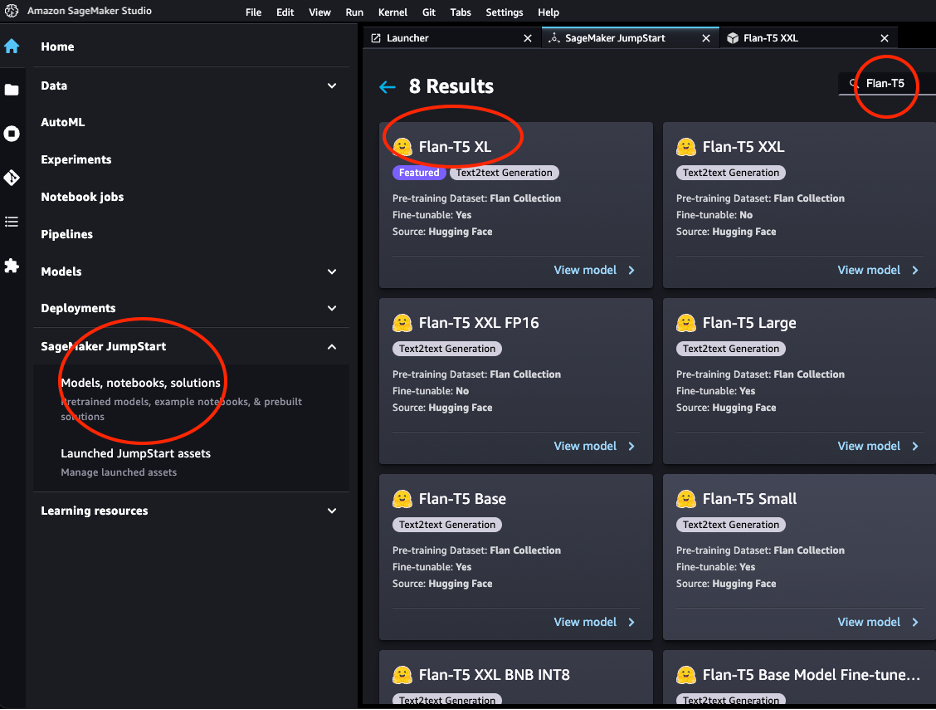

Μοντέλο Flan-T5

Σε αυτό το έργο χρησιμοποιήσαμε το μοντέλο Flan-T5-XXL από το Flan-T5 οικογένεια μοντέλων.

Τα μοντέλα Flan-T5 είναι ρυθμισμένα με οδηγίες και επομένως είναι ικανά να εκτελούν διάφορες εργασίες NLP μηδενικής λήψης. Στην κατάντη εργασία μας δεν χρειαζόταν να συμπεριλάβουμε μια τεράστια ποσότητα παγκόσμιας γνώσης, αλλά μάλλον να αποδίδουμε καλά στην απάντηση ερωτήσεων, δεδομένου ενός πλαισίου κειμένων που παρέχονται μέσω των αποτελεσμάτων αναζήτησης, και ως εκ τούτου, το μοντέλο Τ11 παραμέτρων 5Β είχε καλή απόδοση.

Το JumpStart παρέχει βολική ανάπτυξη αυτής της οικογένειας μοντέλων μέσω Στούντιο Amazon SageMaker και το SageMaker SDK. Αυτό περιλαμβάνει Flan-T5 Small, Flan-T5 Base, Flan-T5 Large, Flan-T5 XL και Flan-T5 XXL. Επιπλέον, το JumpStart παρέχει μερικές εκδόσεις του Flan-T5 XXL σε διαφορετικά επίπεδα κβαντισμού. Αναπτύξαμε το Flan-T5-XXL σε ένα τελικό σημείο για χρήση συμπερασμάτων Amazon SageMaker Studio Jumpstart.

Ανάκτηση Augmented LLM με LangChain

LangChain είναι δημοφιλές και ταχέως αναπτυσσόμενο πλαίσιο που επιτρέπει την ανάπτυξη εφαρμογών που υποστηρίζονται από LLM. Βασίζεται στην έννοια του αλυσίδες, τα οποία είναι συνδυασμοί διαφορετικών στοιχείων που έχουν σχεδιαστεί για τη βελτίωση της λειτουργικότητας των LLM για μια δεδομένη εργασία. Για παράδειγμα, μας επιτρέπει να προσαρμόσουμε προτρέπει και ενσωματώστε τα LLM με διαφορετικά εργαλεία όπως εξωτερικές μηχανές αναζήτησης ή πηγές δεδομένων. Στην περίπτωσή μας, χρησιμοποιήσαμε το Google Serper συστατικό για αναζήτηση στον Ιστό και ανέπτυξε το μοντέλο Flan-T5-XXL που είναι διαθέσιμο σε Amazon SageMaker Studio Jumpstart. Το LangChain εκτελεί τη συνολική ενορχήστρωση και επιτρέπει στις σελίδες των αποτελεσμάτων αναζήτησης να τροφοδοτούνται στο στιγμιότυπο Flan-T5-XXL.

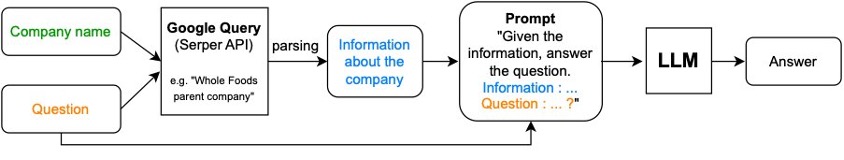

Το Retrieval-Augmented Generation (RAG) αποτελείται από δύο βήματα:

- Ανάκτηση σχετικών τμημάτων κειμένου από εξωτερικές πηγές

- Αύξηση των κομματιών με πλαίσιο στην προτροπή που δόθηκε στο LLM.

Για την περίπτωση χρήσης της Schneider Electric, το RAG προχωρά ως εξής:

- Το όνομα της εταιρείας συνδυάζεται με μια ερώτηση όπως "Ποιος είναι η μητρική εταιρεία του X", όπου X είναι η δεδομένη εταιρεία) και μεταβιβάζεται σε ένα ερώτημα google χρησιμοποιώντας το Serper AI

- Οι εξαγόμενες πληροφορίες συνδυάζονται με την άμεση και αρχική ερώτηση και διαβιβάζονται στο LLM για απάντηση.

Το παρακάτω διάγραμμα απεικονίζει αυτή τη διαδικασία.

Χρησιμοποιήστε τον ακόλουθο κώδικα για να δημιουργήσετε ένα τελικό σημείο:

Εργαλείο άμεσης αναζήτησης:

Στον παρακάτω κώδικα, ενώνουμε τα στοιχεία ανάκτησης και αύξησης:

Το Prompt Engineering

Ο συνδυασμός του πλαισίου και της ερώτησης ονομάζεται προτροπή. Παρατηρήσαμε ότι η γενική προτροπή που χρησιμοποιήσαμε (παραλλαγές σχετικά με το αίτημα για τη μητρική εταιρεία) είχε καλή απόδοση για τους περισσότερους δημόσιους τομείς (τομείς), αλλά δεν γενικεύτηκε καλά στην εκπαίδευση ή την υγειονομική περίθαλψη, καθώς η έννοια της μητρικής εταιρείας δεν έχει νόημα εκεί. Για την εκπαίδευση χρησιμοποιήσαμε το "Χ" ενώ για την υγειονομική περίθαλψη χρησιμοποιήσαμε το "Y".

Για να ενεργοποιήσουμε αυτήν την επιλογή προτροπής για συγκεκριμένο τομέα, έπρεπε επίσης να προσδιορίσουμε τον τομέα στον οποίο ανήκει ένας συγκεκριμένος λογαριασμός. Για αυτό, χρησιμοποιήσαμε επίσης ένα RAG όπου μια ερώτηση πολλαπλών επιλογών "Ποιος είναι ο τομέας του {account};" ως πρώτο βήμα και με βάση την απάντηση που ρωτήσαμε τη μητρική του λογαριασμού χρησιμοποιώντας τη σχετική προτροπή ως δεύτερο βήμα. Δείτε τον παρακάτω κώδικα:

Οι ειδικές προτροπές του κλάδου αύξησαν τη συνολική απόδοση από 55% σε 71% ακρίβειας. Συνολικά, η προσπάθεια και ο χρόνος που επενδύθηκαν για να αναπτυχθούν αποτελεσματικά προτρέπει φαίνεται να βελτιώνουν σημαντικά την ποιότητα της απόκρισης LLM.

RAG με δεδομένα σε πίνακα (SEC-10k)

Οι καταθέσεις SEC 10K είναι μια άλλη αξιόπιστη πηγή πληροφοριών για θυγατρικές και υποδιαιρέσεις που υποβάλλονται ετησίως από εισηγμένες εταιρείες. Αυτά τα αρχεία είναι διαθέσιμα απευθείας στο SEC EDGAR ή μέσω CorpWatch API.

Υποθέτουμε ότι οι πληροφορίες δίνονται σε μορφή πίνακα. Παρακάτω είναι ένα ψευδο csv σύνολο δεδομένων που μιμείται την αρχική μορφή του συνόλου δεδομένων SEC-10K. Είναι δυνατή η συγχώνευση πολλών csv πηγές δεδομένων σε ένα συνδυασμένο πλαίσιο δεδομένων pandas:

# A pseudo dataset similar by schema to the CorpWatch API dataset

df.head()

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/schneider-electric-leverages-retrieval-augmented-llms-on-sagemaker-to-ensure-real-time-updates-in-their-erp-systems/

Αντώνης Μεδέιρος είναι Διευθυντής Μηχανικής και Αρχιτεκτονικής Λύσεων στη Schneider Electric. Ειδικεύεται στην παροχή πρωτοβουλιών AI/ML υψηλής αξίας σε πολλές επιχειρηματικές λειτουργίες στη Βόρεια Αμερική. Με 17 χρόνια εμπειρίας στη Schneider Electric, φέρνει πλήθος γνώσεων στον κλάδο και τεχνικής εξειδίκευσης στην ομάδα.

Αντώνης Μεδέιρος είναι Διευθυντής Μηχανικής και Αρχιτεκτονικής Λύσεων στη Schneider Electric. Ειδικεύεται στην παροχή πρωτοβουλιών AI/ML υψηλής αξίας σε πολλές επιχειρηματικές λειτουργίες στη Βόρεια Αμερική. Με 17 χρόνια εμπειρίας στη Schneider Electric, φέρνει πλήθος γνώσεων στον κλάδο και τεχνικής εξειδίκευσης στην ομάδα. Blake Sanstchi είναι Διευθυντής Business Intelligence στη Schneider Electric, επικεφαλής μιας ομάδας ανάλυσης που επικεντρώνεται στην υποστήριξη του οργανισμού πωλήσεων μέσω πληροφοριών που βασίζονται σε δεδομένα.

Blake Sanstchi είναι Διευθυντής Business Intelligence στη Schneider Electric, επικεφαλής μιας ομάδας ανάλυσης που επικεντρώνεται στην υποστήριξη του οργανισμού πωλήσεων μέσω πληροφοριών που βασίζονται σε δεδομένα. Τζόσουα Λέβι είναι Ανώτερος Διευθυντής Εφαρμοσμένης Επιστήμης στο εργαστήριο λύσεων μηχανικής μάθησης της Amazon, όπου βοηθά τους πελάτες να σχεδιάσουν και να δημιουργήσουν λύσεις AI/ML για την επίλυση βασικών επιχειρηματικών προβλημάτων.

Τζόσουα Λέβι είναι Ανώτερος Διευθυντής Εφαρμοσμένης Επιστήμης στο εργαστήριο λύσεων μηχανικής μάθησης της Amazon, όπου βοηθά τους πελάτες να σχεδιάσουν και να δημιουργήσουν λύσεις AI/ML για την επίλυση βασικών επιχειρηματικών προβλημάτων. Κόστα Μπελζ είναι Ανώτερος Εφαρμοσμένος Επιστήμονας με AWS MLSL με εστίαση στο Generative AI και στην επεξεργασία εγγράφων. Είναι παθιασμένος με τη δημιουργία εφαρμογών χρησιμοποιώντας Γραφήματα Γνώσης και NLP. Έχει περίπου 10 χρόνια εμπειρίας στην κατασκευή λύσεων δεδομένων και τεχνητής νοημοσύνης για τη δημιουργία αξίας για πελάτες και επιχειρήσεις.

Κόστα Μπελζ είναι Ανώτερος Εφαρμοσμένος Επιστήμονας με AWS MLSL με εστίαση στο Generative AI και στην επεξεργασία εγγράφων. Είναι παθιασμένος με τη δημιουργία εφαρμογών χρησιμοποιώντας Γραφήματα Γνώσης και NLP. Έχει περίπου 10 χρόνια εμπειρίας στην κατασκευή λύσεων δεδομένων και τεχνητής νοημοσύνης για τη δημιουργία αξίας για πελάτες και επιχειρήσεις. Aude Genevay είναι Applied Scientist στο Amazon GenAI Incubator, όπου βοηθά τους πελάτες να λύσουν βασικά επιχειρηματικά προβλήματα μέσω ML και AI. Προηγουμένως ήταν ερευνήτρια στη θεωρητική ML και της αρέσει να εφαρμόζει τις γνώσεις της για να παρέχει λύσεις αιχμής στους πελάτες.

Aude Genevay είναι Applied Scientist στο Amazon GenAI Incubator, όπου βοηθά τους πελάτες να λύσουν βασικά επιχειρηματικά προβλήματα μέσω ML και AI. Προηγουμένως ήταν ερευνήτρια στη θεωρητική ML και της αρέσει να εφαρμόζει τις γνώσεις της για να παρέχει λύσεις αιχμής στους πελάτες. Md Sirajus Salekin είναι Εφαρμοσμένος Επιστήμονας στο AWS Machine Learning Solution Lab. Βοηθά τους πελάτες της AWS να επιταχύνουν την επιχείρησή τους δημιουργώντας λύσεις AI/ML. Τα ερευνητικά του ενδιαφέροντα είναι η πολυτροπική μηχανική μάθηση, η γενετική τεχνητή νοημοσύνη και οι εφαρμογές ML στην υγειονομική περίθαλψη.

Md Sirajus Salekin είναι Εφαρμοσμένος Επιστήμονας στο AWS Machine Learning Solution Lab. Βοηθά τους πελάτες της AWS να επιταχύνουν την επιχείρησή τους δημιουργώντας λύσεις AI/ML. Τα ερευνητικά του ενδιαφέροντα είναι η πολυτροπική μηχανική μάθηση, η γενετική τεχνητή νοημοσύνη και οι εφαρμογές ML στην υγειονομική περίθαλψη. Ζιχέν Γουάνγκ, PhD, είναι Senior Applied Scientist στο AWS. Με αρκετά χρόνια ερευνητικής εμπειρίας στην ανάπτυξη ML και στατιστικών μεθόδων χρησιμοποιώντας βιολογικά και ιατρικά δεδομένα, συνεργάζεται με πελάτες σε διάφορους κλάδους για να λύσει τα προβλήματα ML τους.

Ζιχέν Γουάνγκ, PhD, είναι Senior Applied Scientist στο AWS. Με αρκετά χρόνια ερευνητικής εμπειρίας στην ανάπτυξη ML και στατιστικών μεθόδων χρησιμοποιώντας βιολογικά και ιατρικά δεδομένα, συνεργάζεται με πελάτες σε διάφορους κλάδους για να λύσει τα προβλήματα ML τους. Άντον Γκρίντιν είναι Αρχιτέκτονας της Principal Solutions που υποστηρίζει τους Παγκόσμιους Βιομηχανικούς Λογαριασμούς, με έδρα τη Νέα Υόρκη. Διαθέτει περισσότερα από 15 χρόνια εμπειρίας στη δημιουργία ασφαλών εφαρμογών και κορυφαίων ομάδων μηχανικών.

Άντον Γκρίντιν είναι Αρχιτέκτονας της Principal Solutions που υποστηρίζει τους Παγκόσμιους Βιομηχανικούς Λογαριασμούς, με έδρα τη Νέα Υόρκη. Διαθέτει περισσότερα από 15 χρόνια εμπειρίας στη δημιουργία ασφαλών εφαρμογών και κορυφαίων ομάδων μηχανικών.