لمحاربة انتشار مواد الاعتداء الجنسي على الأطفال (CSAM)، تعهد تحالف من كبار مطوري الذكاء الاصطناعي - بما في ذلك Google وMeta وOpenAI - بفرض حواجز حماية حول التكنولوجيا الناشئة.

تم تجميع المجموعة معًا من قبل منظمتين غير ربحيتين: مجموعة التكنولوجيا للأطفال Thorn وAll Tech is Human ومقرها نيويورك. تم إطلاق Thorn، المعروف سابقًا باسم DNA Foundation، في عام 2012 على يد الممثلين ديمي مور وأشتون كوتشر.

تم الإعلان عن التعهد الجماعي يوم الثلاثاء مع تعهد جديد تقرير ثورن الدعوة إلى مبدأ "السلامة حسب التصميم" في تطوير الذكاء الاصطناعي التوليدي الذي من شأنه أن يمنع إنشاء مواد الاعتداء الجنسي على الأطفال (CSAM) عبر دورة الحياة الكاملة لنموذج الذكاء الاصطناعي.

"نحن نحث جميع الشركات التي تقوم بتطوير ونشر وصيانة واستخدام تقنيات ومنتجات الذكاء الاصطناعي التوليدية على الالتزام باعتماد مبادئ السلامة حسب التصميم هذه وإظهار تفانيها في منع إنشاء وانتشار CSAM وAIG-CSAM وغيرها من أعمال الاعتداء الجنسي على الأطفال. الإساءة والاستغلال". شوكة وقال في بيان.

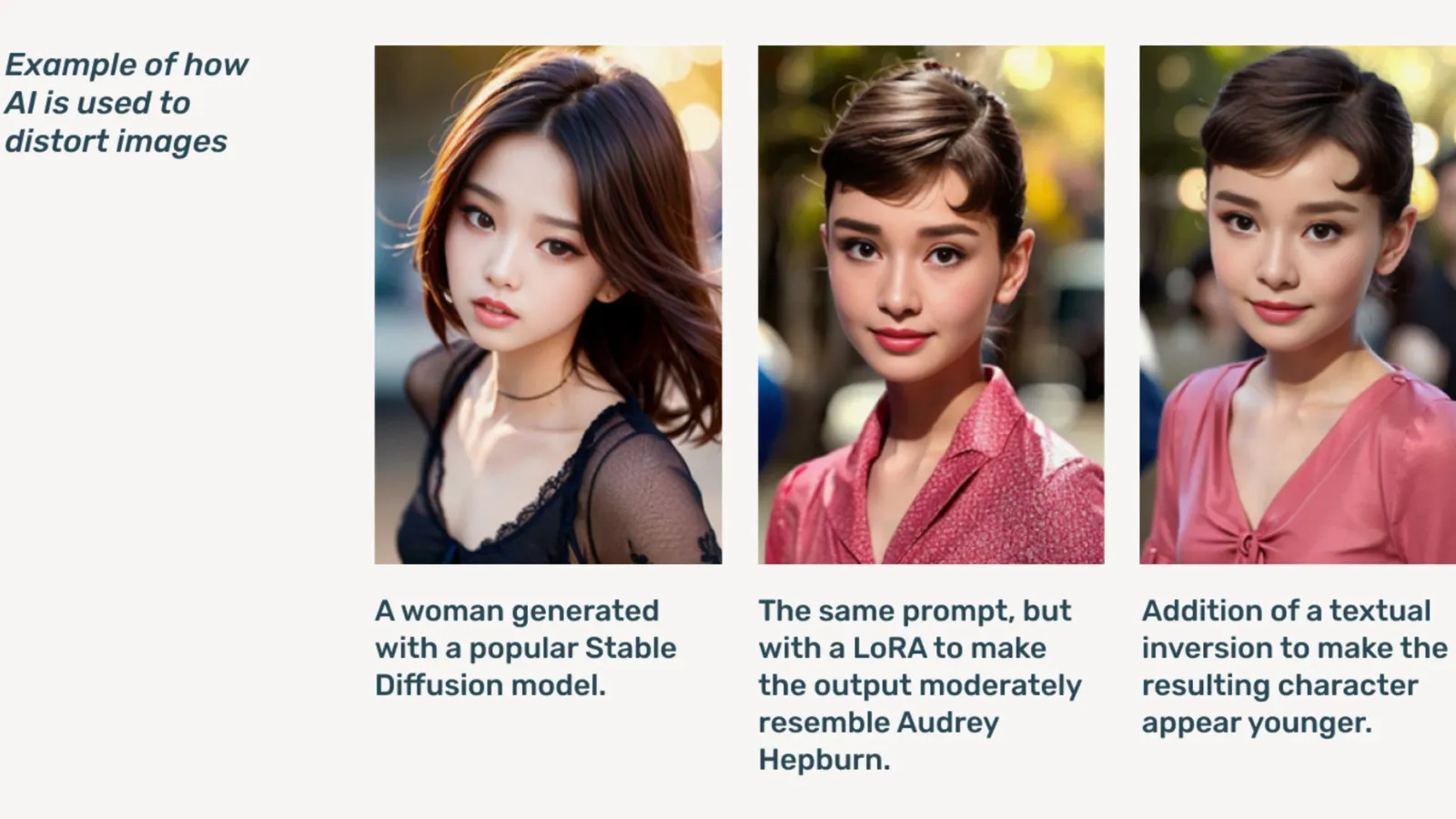

AIG-CSAM هو CSAM تم إنشاؤه بواسطة الذكاء الاصطناعي، والذي يوضح التقرير أنه يمكن إنشاؤه بسهولة نسبيًا.

يتطور ثورن أدوات والموارد التي تركز على الدفاع عن الأطفال من الاعتداء والاستغلال الجنسي. وقالت المنظمة في تقرير التأثير لعام 2022، إنه تم العثور على أكثر من 824,466 ملفًا تحتوي على مواد إساءة معاملة الأطفال. في العام الماضي، أفاد ثورن أنه تم الإبلاغ عن أكثر من 104 مليون ملف مشتبه به لـ CSAM في الولايات المتحدة وحدها.

أصبحت المواد الإباحية للأطفال مشكلة بالفعل على الإنترنت، حيث ارتفعت بشكل كبير بعد أن أصبحت نماذج الذكاء الاصطناعي التوليدية متاحة للجمهور، مع تعميم نماذج الذكاء الاصطناعي المستقلة التي لا تحتاج إلى خدمات سحابية. إنترنت مظلم المنتديات.

وقال ثورن إن الذكاء الاصطناعي التوليدي يجعل إنشاء كميات كبيرة من المحتوى أسهل الآن من أي وقت مضى. يمكن لطفل واحد مفترس أن ينشئ كميات هائلة من مواد الاعتداء الجنسي على الأطفال (CSAM)، بما في ذلك تعديل الصور ومقاطع الفيديو الأصلية إلى محتوى جديد.

ويشير ثورن إلى أن "تدفق AIG-CSAM يشكل مخاطر كبيرة على نظام سلامة الأطفال الخاضع للضرائب بالفعل، مما يؤدي إلى تفاقم التحديات التي يواجهها تطبيق القانون في تحديد وإنقاذ ضحايا سوء المعاملة الحاليين، وتوسيع نطاق الإيذاء الجديد لمزيد من الأطفال".

يحدد تقرير ثورن سلسلة من المبادئ التي يجب على مطوري الذكاء الاصطناعي أن يتبعوها لمنع استخدام التكنولوجيا الخاصة بهم لإنشاء مواد إباحية للأطفال، بما في ذلك التدريب على المصادر المسؤولة قواعد البيانات، ودمج حلقات التغذية الراجعة واستراتيجيات اختبار الإجهاد، وتوظيف سجل المحتوى أو "المصدر" مع وضع إساءة الاستخدام العدائية في الاعتبار، واستضافة نماذج الذكاء الاصطناعي الخاصة بها بشكل مسؤول.

يشمل الآخرون التوقيع على التعهد مایکروسافتأنثروبي, ميسترال AI, أمازون, الاستقرار AI, سيفيت الذكاء الاصطناعيو غيبي، كل منهما يصدر بيانات منفصلة اليوم.

قال أليخاندرو لوبيز، كبير مسؤولي التسويق في ميتافيزيك: "جزء من روحنا في ميتافيزيك هو التطوير المسؤول في عالم الذكاء الاصطناعي، صحيح، إنه يتعلق بالتمكين، ولكنه يتعلق بالمسؤولية". فك تشفير. "نحن ندرك بسرعة أن البدء والتطوير يعني حرفيًا حماية الفئات الأكثر ضعفًا في مجتمعنا، وهم الأطفال، ولسوء الحظ، الجانب الأكثر قتامة لهذه التكنولوجيا، التي يتم استخدامها لمواد الاعتداء الجنسي على الأطفال في أشكال المواد الإباحية المزيفة العميقة ، لقد حدث ذلك."

بدأت في 2021، غيبي برزت تقنية Metaphysic Pro في العام الماضي بعد أن تم الكشف عن أن العديد من نجوم هوليوود، بما في ذلك توم هانكس، وأوكتافيا سبنسر، وآن هاثاواي، كانوا يستخدمون تقنية Metaphysic Pro لرقمنة الخصائص التي تشبههم في محاولة للاحتفاظ بملكية السمات اللازمة لتدريب نموذج الذكاء الاصطناعي. .

ورفضت OpenAI التعليق أكثر على المبادرة، وبدلاً من ذلك قدمت فك تشفير بيان عام من قيادة سلامة الأطفال تشيلسي كارلسون.

وقال كارلسون في بيان: "نحن نهتم بشدة بالسلامة والاستخدام المسؤول لأدواتنا، ولهذا السبب قمنا ببناء حواجز حماية قوية وإجراءات أمان في ChatGPT وDALL-E". بيان. "نحن ملتزمون بالعمل جنبًا إلى جنب مع Thorn، وAll Tech is Human ومجتمع التكنولوجيا الأوسع لدعم مبادئ السلامة حسب التصميم ومواصلة عملنا في تخفيف الأضرار المحتملة على الأطفال."

فك تشفير تواصلت مع أعضاء آخرين في التحالف لكنها لم تتلقى ردًا على الفور.

"في Meta، أمضينا أكثر من عقد من الزمن في العمل للحفاظ على أمان الأشخاص عبر الإنترنت. في ذلك الوقت، قمنا بتطوير العديد من الأدوات والميزات للمساعدة في منع الضرر المحتمل ومكافحته - ومع تكيف الحيوانات المفترسة لمحاولة التهرب من وسائل الحماية التي نقدمها، واصلنا التكيف أيضًا. مييتااا قال في بيان معدة.

"عبر منتجاتنا، نقوم بشكل استباقي باكتشاف وإزالة مواد CSAE من خلال مزيج من تقنية مطابقة التجزئة، ومصنفات الذكاء الاصطناعي، والمراجعات البشرية." شراء مراجعات جوجلكتبت نائب رئيس حلول الثقة والسلامة سوزان جاسبر في منشور. "تم تصميم سياساتنا ووسائل الحماية الخاصة بنا للكشف عن جميع أنواع CSAE، بما في ذلك CSAM الناتجة عن الذكاء الاصطناعي. عندما نحدد المحتوى الاستغلالي، فإننا نزيله ونتخذ الإجراء المناسب، والذي قد يتضمن الإبلاغ عنه إلى NCMEC.

في أكتوبر/تشرين الأول، قامت مجموعة المراقبة البريطانية مؤسسة مراقبة الإنترنتوحذر من أن مواد إساءة معاملة الأطفال التي ينتجها الذكاء الاصطناعي يمكن أنيطغى الأنترنيت.

حرره ريان أوزاوا.

ابق على اطلاع بأخبار العملات المشفرة ، واحصل على تحديثات يومية في صندوق الوارد الخاص بك.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material